-

-  -

-  -

-

-

-

-

- +

+

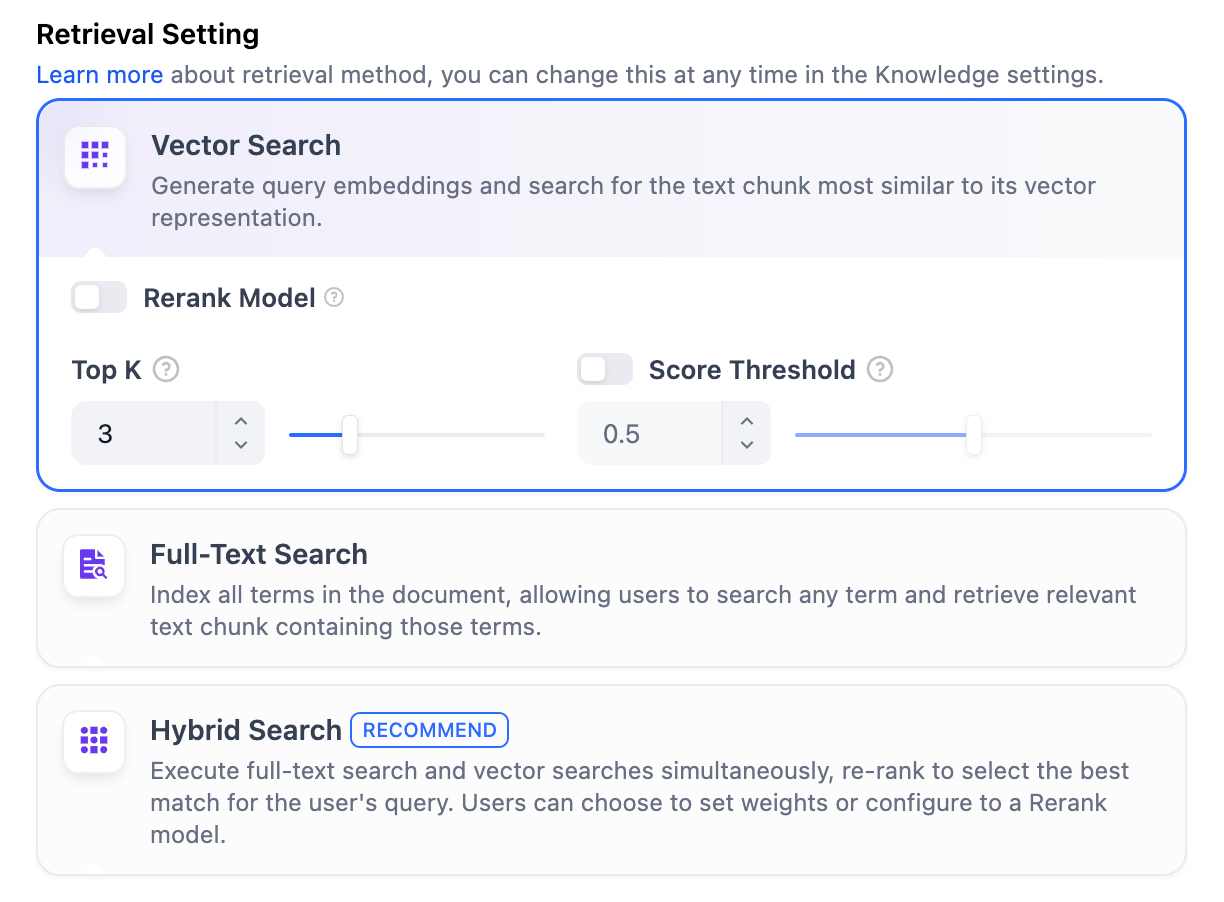

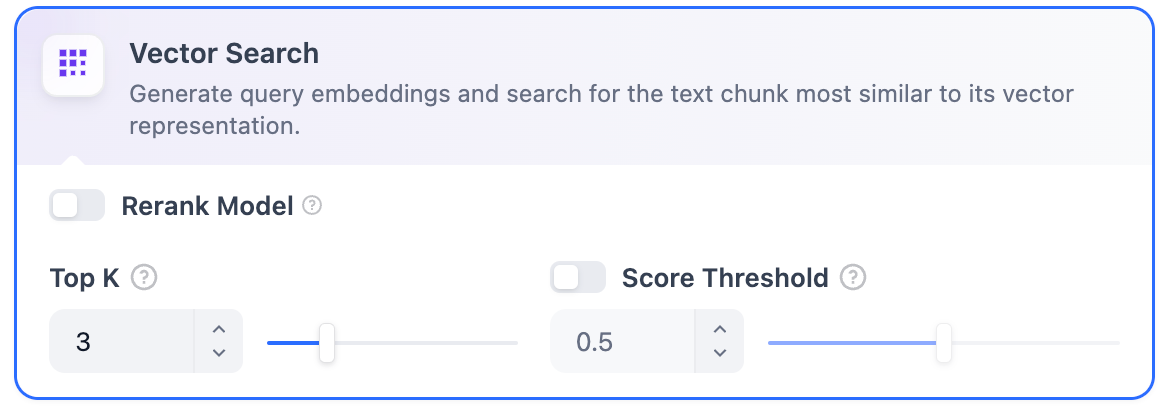

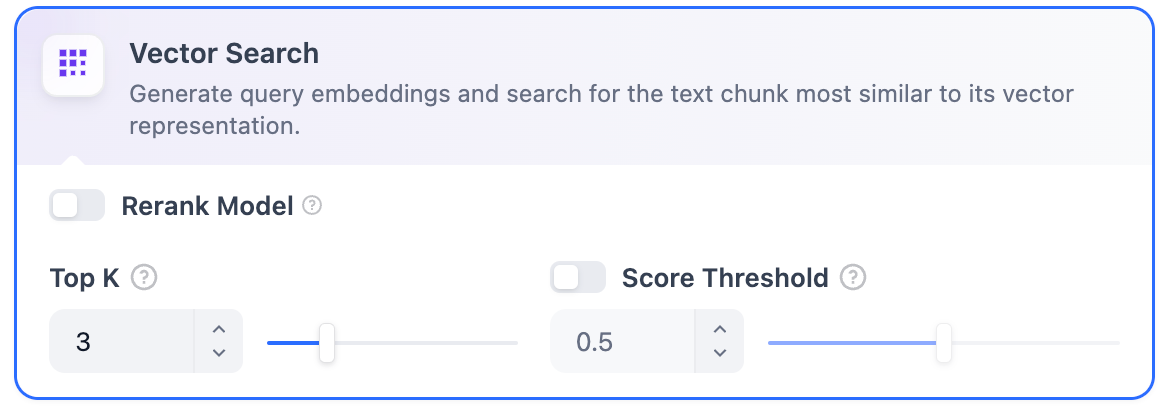

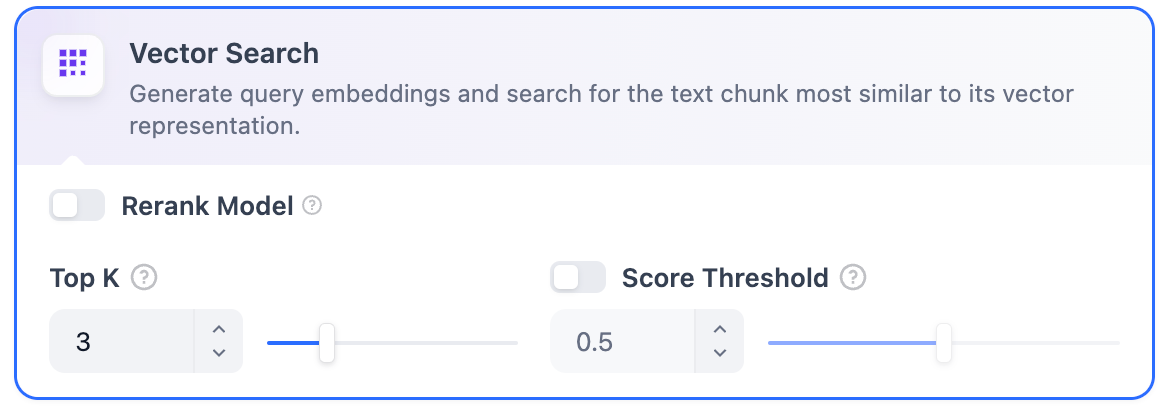

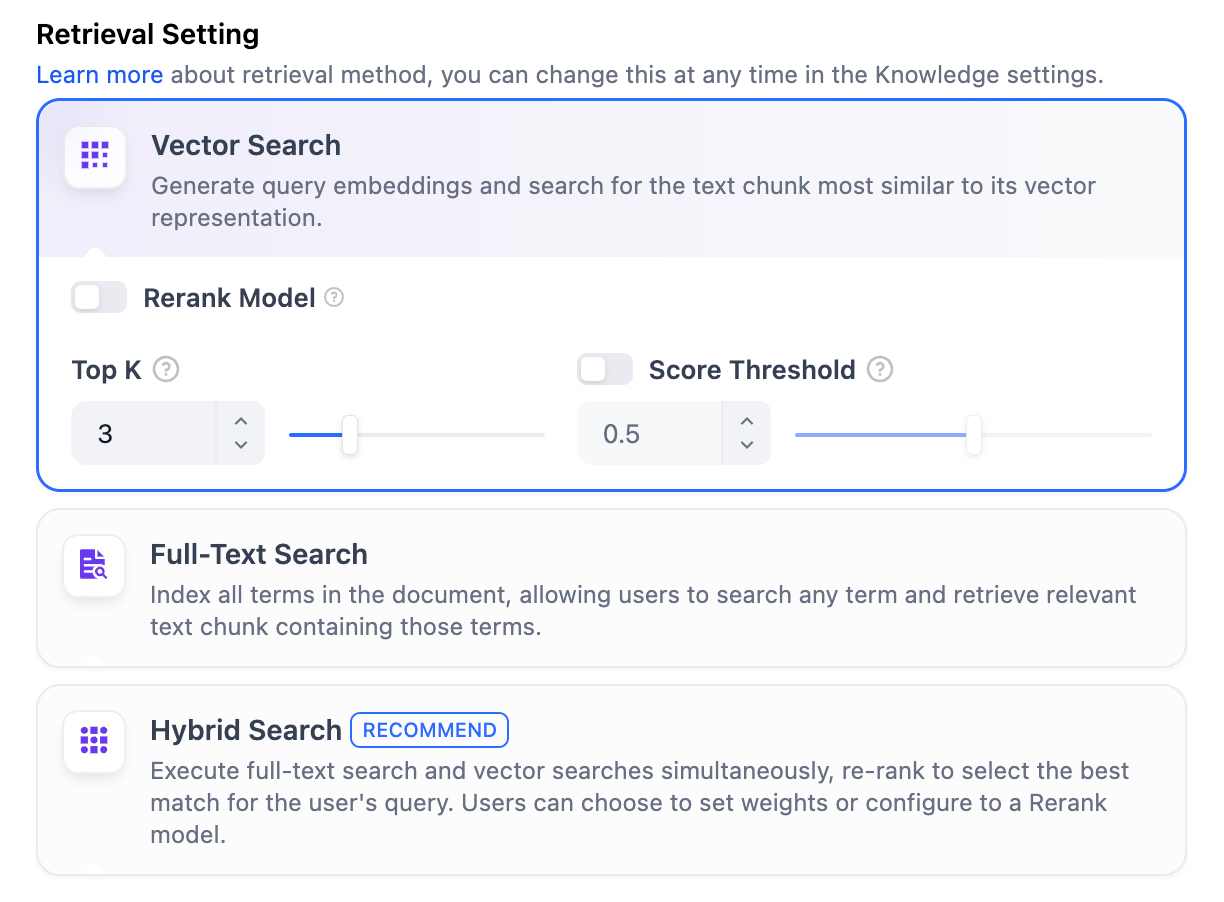

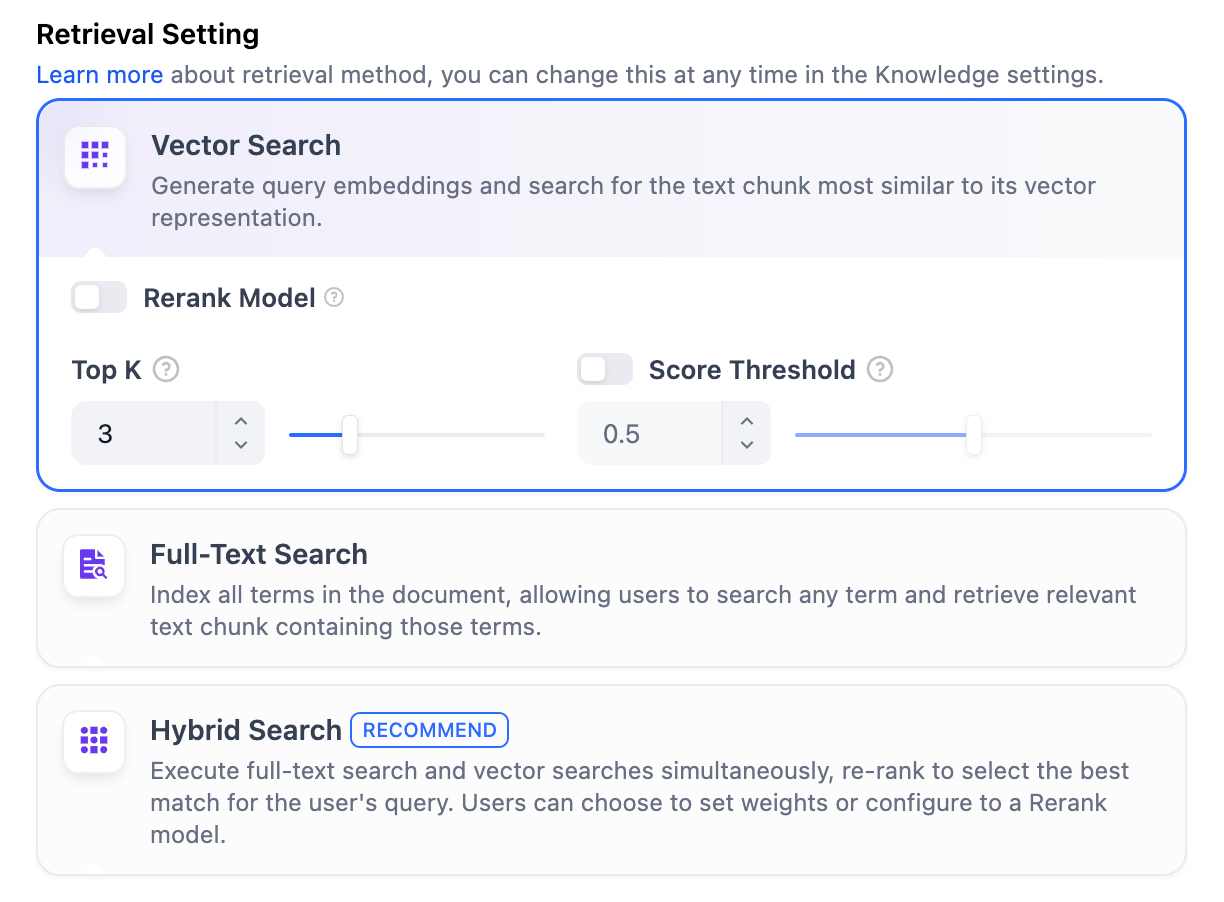

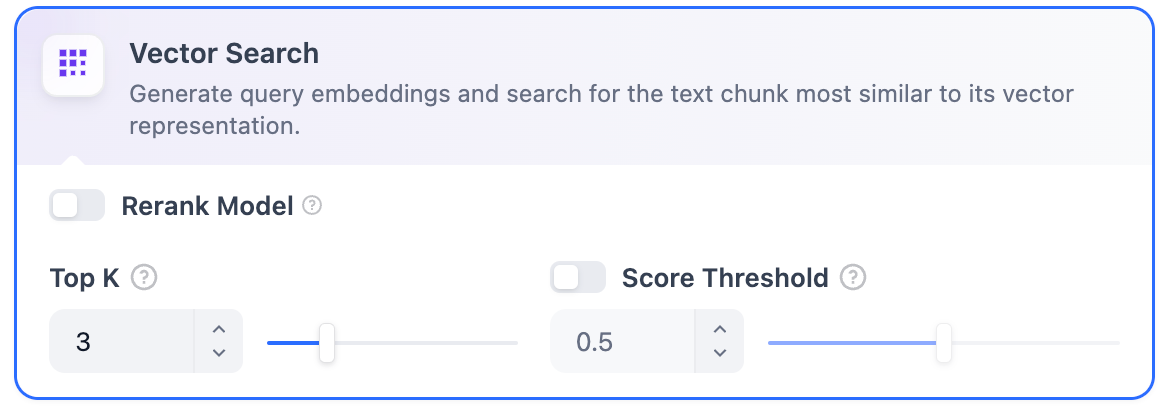

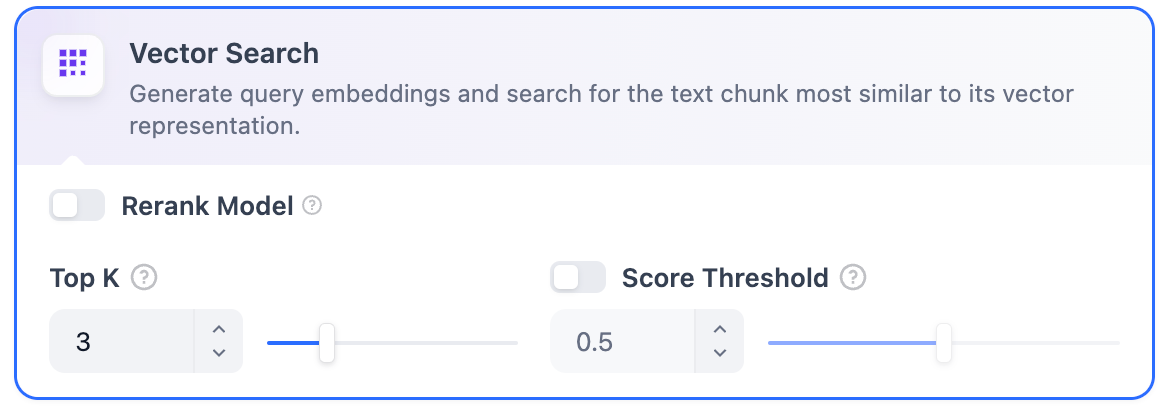

-**ベクトル検索**

+ **ベクトル検索**

-**定義**: ユーザーの質問をベクトル化してクエリベクトルを生成し、ナレッジベース内の対応するテキストベクトルと比較して、最も近いチャンクを見つけます。

+ **定義:** ユーザーが入力した質問をベクトル化し、クエリテキストの数学ベクトルを生成し、クエリベクトルとナレッジベース内の対応するテキストベクトル間の距離を比較し、隣接する分割コンテンツを探します。

-

+

-**ベクトル検索**

+ **ベクトル検索**

-**定義**: ユーザーの質問をベクトル化してクエリベクトルを生成し、ナレッジベース内の対応するテキストベクトルと比較して、最も近いチャンクを見つけます。

+ **定義:** ユーザーが入力した質問をベクトル化し、クエリテキストの数学ベクトルを生成し、クエリベクトルとナレッジベース内の対応するテキストベクトル間の距離を比較し、隣接する分割コンテンツを探します。

-

+  -**ベクトル検索設定:**

+ **ベクトル検索設定:**

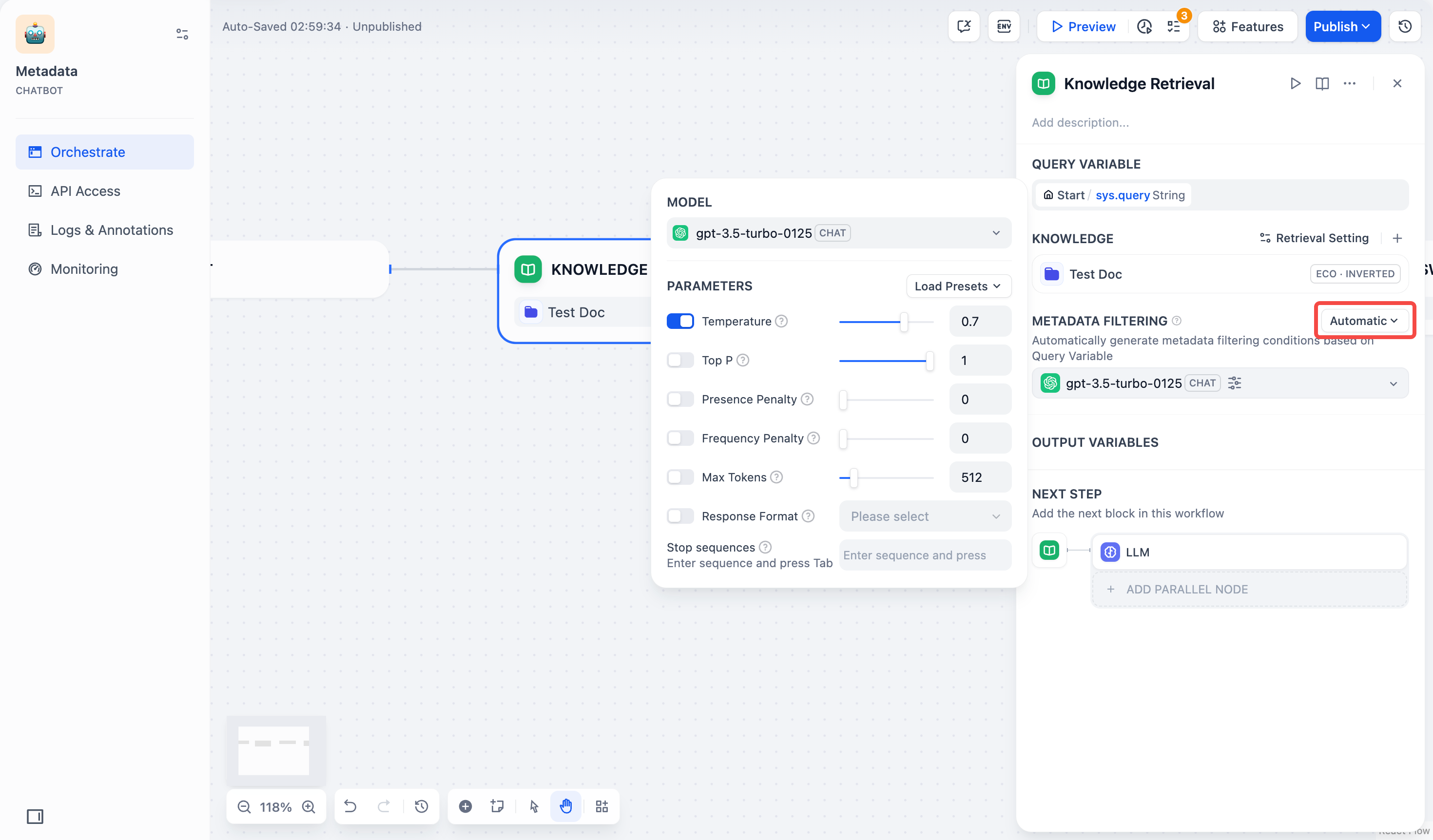

-**Rerankモデル**: デフォルトでは無効です。有効にすると、サードパーティのRerankモデルがベクトル検索によって返されたテキストチャンクを並べ替えて結果を最適化します。これにより、LLMがより正確な情報にアクセスし、出力品質を向上させることができます。このオプションを有効にする前に、**設定** → **モデルプロバイダー**に移動してRerankモデルのAPIキーを設定してください。

+ **Rerankモデル:** デフォルトでは無効です。有効にすると、ベクトル検索によって呼び出されたコンテンツセグメントを第三者のRerankモデルを使用して再度並べ替え、並べ替え結果を最適化します。LLMがより正確なコンテンツを取得し、出力の品質を向上させるのを助けます。このオプションを有効にする前に、「設定」→「モデルプロバイダー」に移動し、RerankモデルのAPIキーを事前に設定する必要があります。

-

-**ベクトル検索設定:**

+ **ベクトル検索設定:**

-**Rerankモデル**: デフォルトでは無効です。有効にすると、サードパーティのRerankモデルがベクトル検索によって返されたテキストチャンクを並べ替えて結果を最適化します。これにより、LLMがより正確な情報にアクセスし、出力品質を向上させることができます。このオプションを有効にする前に、**設定** → **モデルプロバイダー**に移動してRerankモデルのAPIキーを設定してください。

+ **Rerankモデル:** デフォルトでは無効です。有効にすると、ベクトル検索によって呼び出されたコンテンツセグメントを第三者のRerankモデルを使用して再度並べ替え、並べ替え結果を最適化します。LLMがより正確なコンテンツを取得し、出力の品質を向上させるのを助けます。このオプションを有効にする前に、「設定」→「モデルプロバイダー」に移動し、RerankモデルのAPIキーを事前に設定する必要があります。

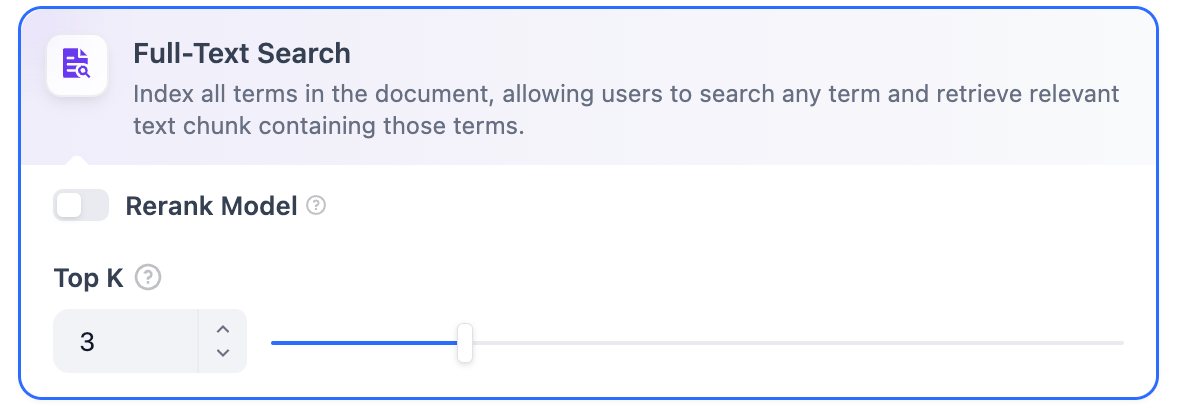

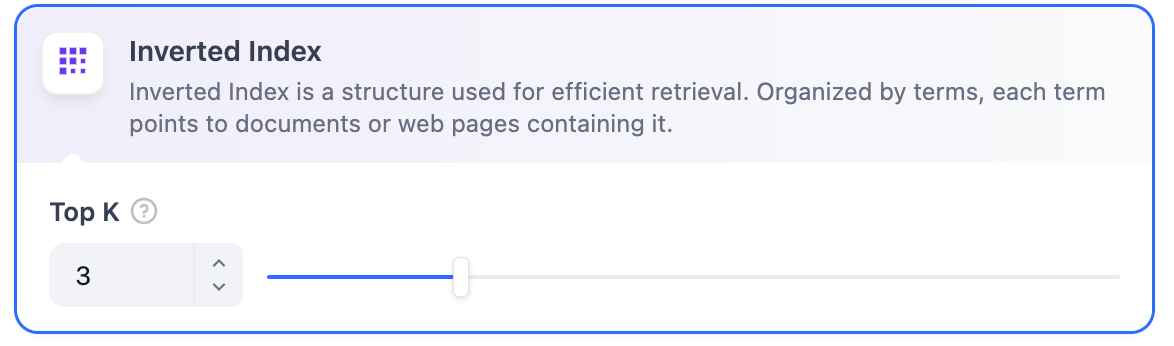

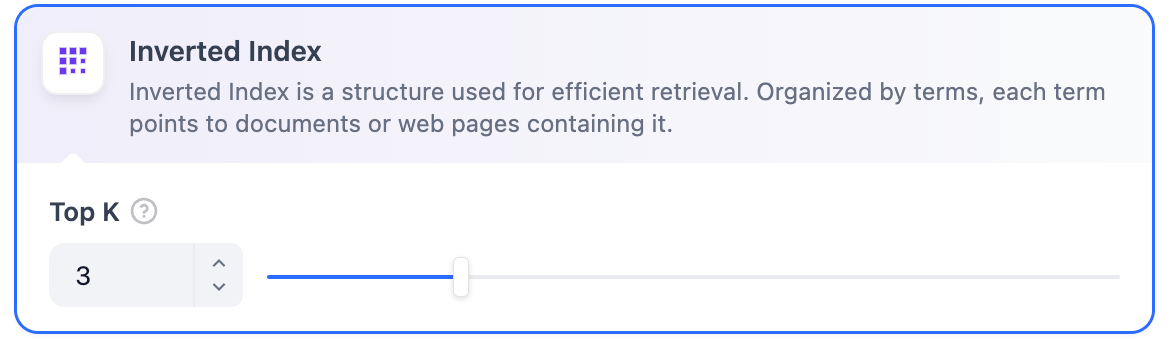

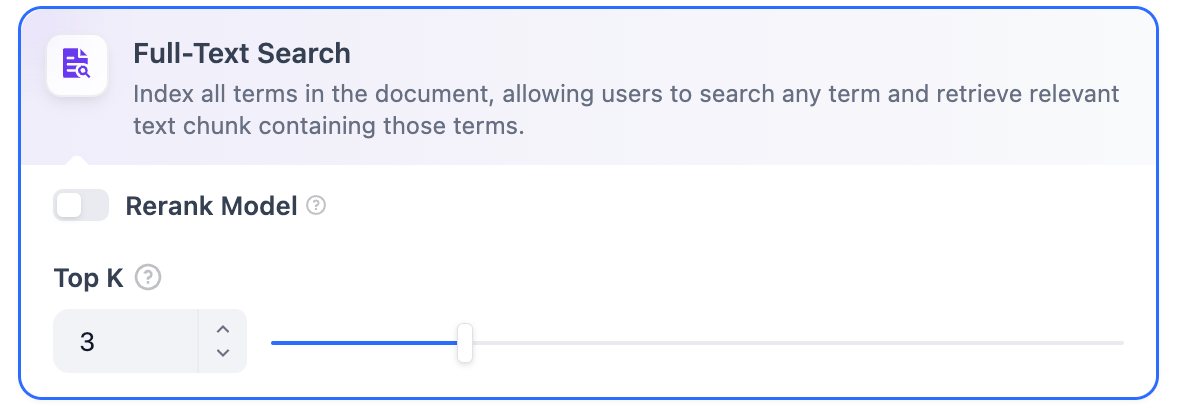

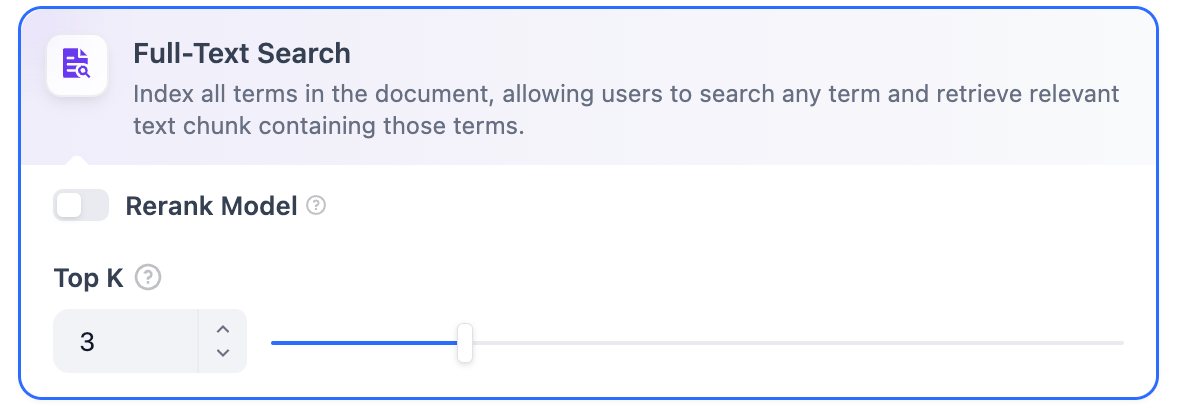

- -**Rerankモデル**: デフォルトでは無効です。有効にすると、サードパーティのRerankモデルが全文検索によって返されたテキストチャンクを並べ替えて結果を最適化します。これにより、LLMがより正確な情報にアクセスし、出力品質を向上させることができます。このオプションを有効にする前に、**設定** → **モデルプロバイダー**に移動してRerankモデルのAPIキーを設定してください。

+ **Rerankモデル:** デフォルトでは無効です。有効にすると、全文検索によって呼び出されたコンテンツセグメントを第三者のRerankモデルを使用して再度並べ替え、並べ替え結果を最適化します。LLMに再並べ替えされたセグメントを送信し、出力コンテンツの品質を向上させます。このオプションを有効にする前に、「設定」→「モデルプロバイダー」に移動し、RerankモデルのAPIキーを事前に設定する必要があります。

-

-**Rerankモデル**: デフォルトでは無効です。有効にすると、サードパーティのRerankモデルが全文検索によって返されたテキストチャンクを並べ替えて結果を最適化します。これにより、LLMがより正確な情報にアクセスし、出力品質を向上させることができます。このオプションを有効にする前に、**設定** → **モデルプロバイダー**に移動してRerankモデルのAPIキーを設定してください。

+ **Rerankモデル:** デフォルトでは無効です。有効にすると、全文検索によって呼び出されたコンテンツセグメントを第三者のRerankモデルを使用して再度並べ替え、並べ替え結果を最適化します。LLMに再並べ替えされたセグメントを送信し、出力コンテンツの品質を向上させます。このオプションを有効にする前に、「設定」→「モデルプロバイダー」に移動し、RerankモデルのAPIキーを事前に設定する必要があります。

- -

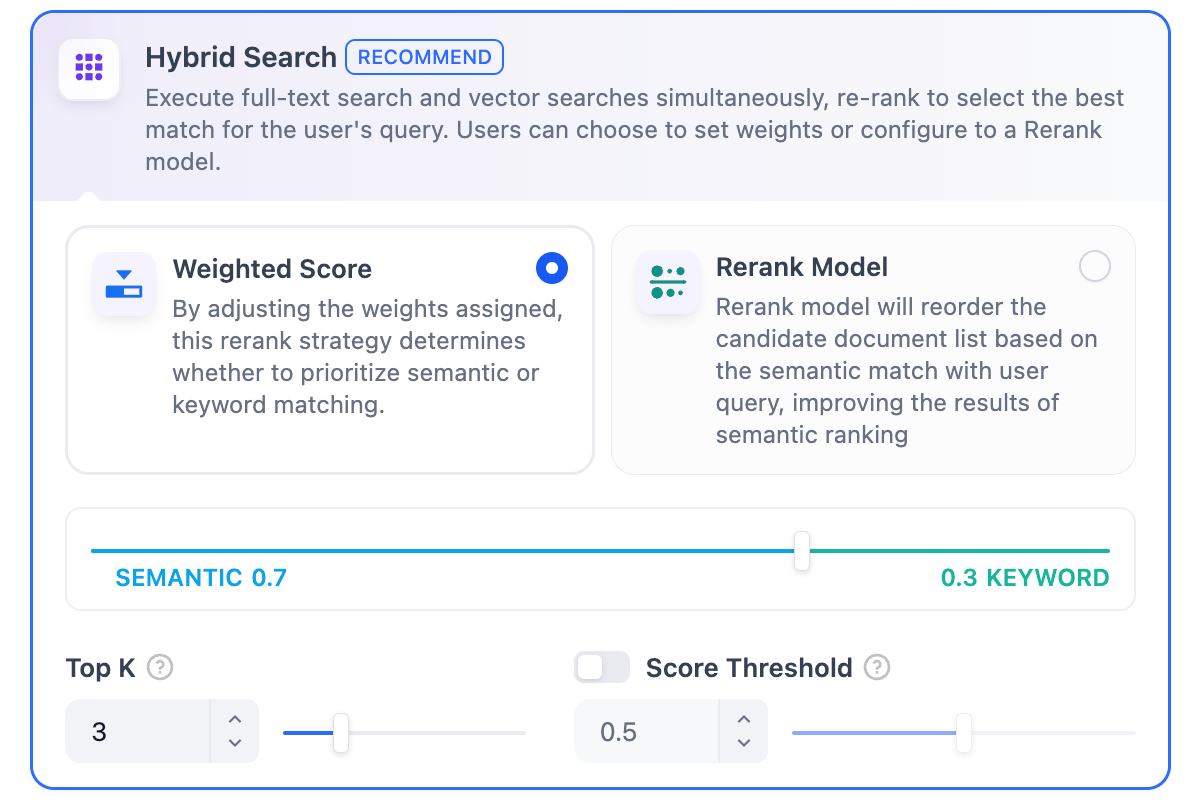

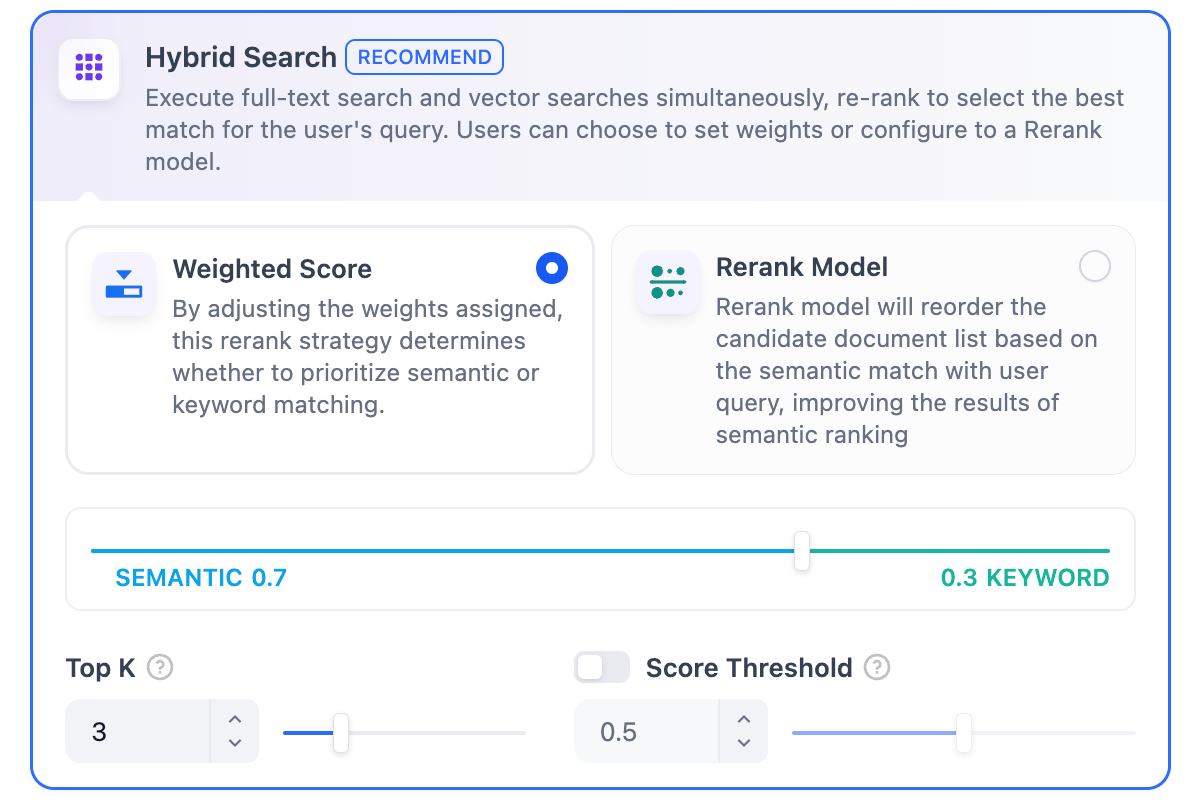

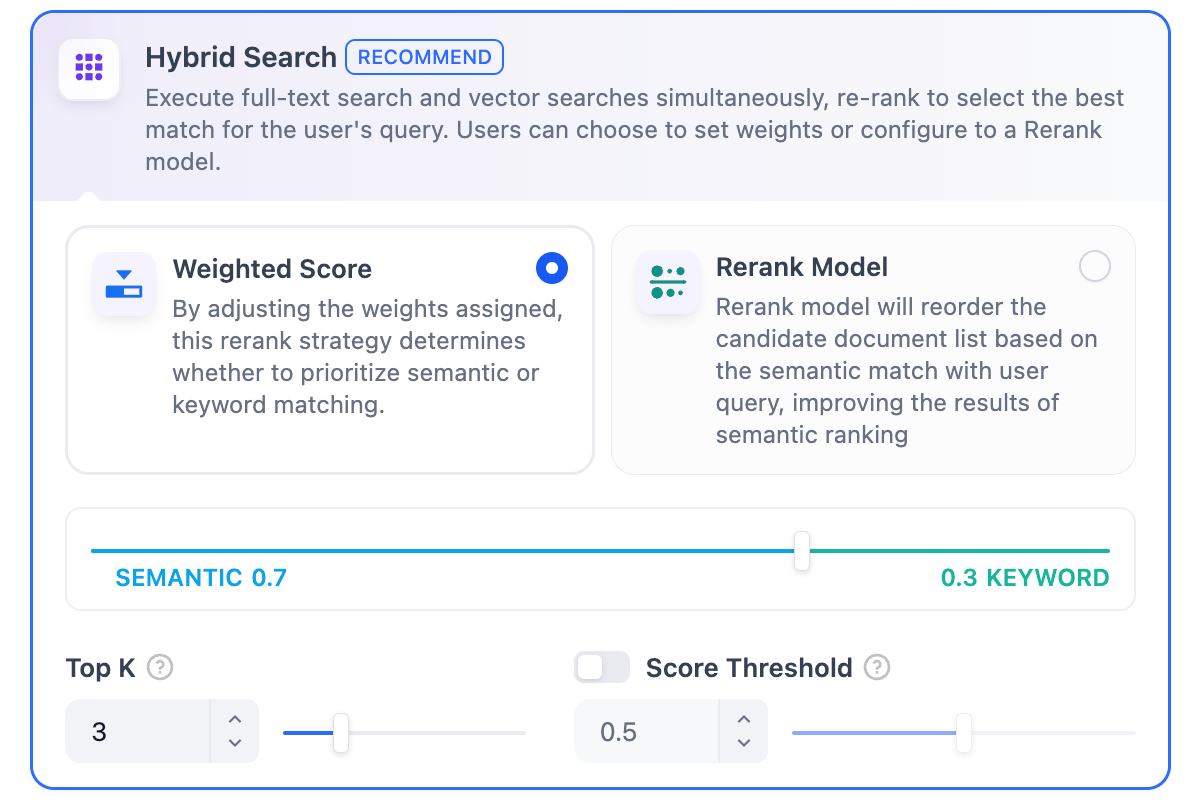

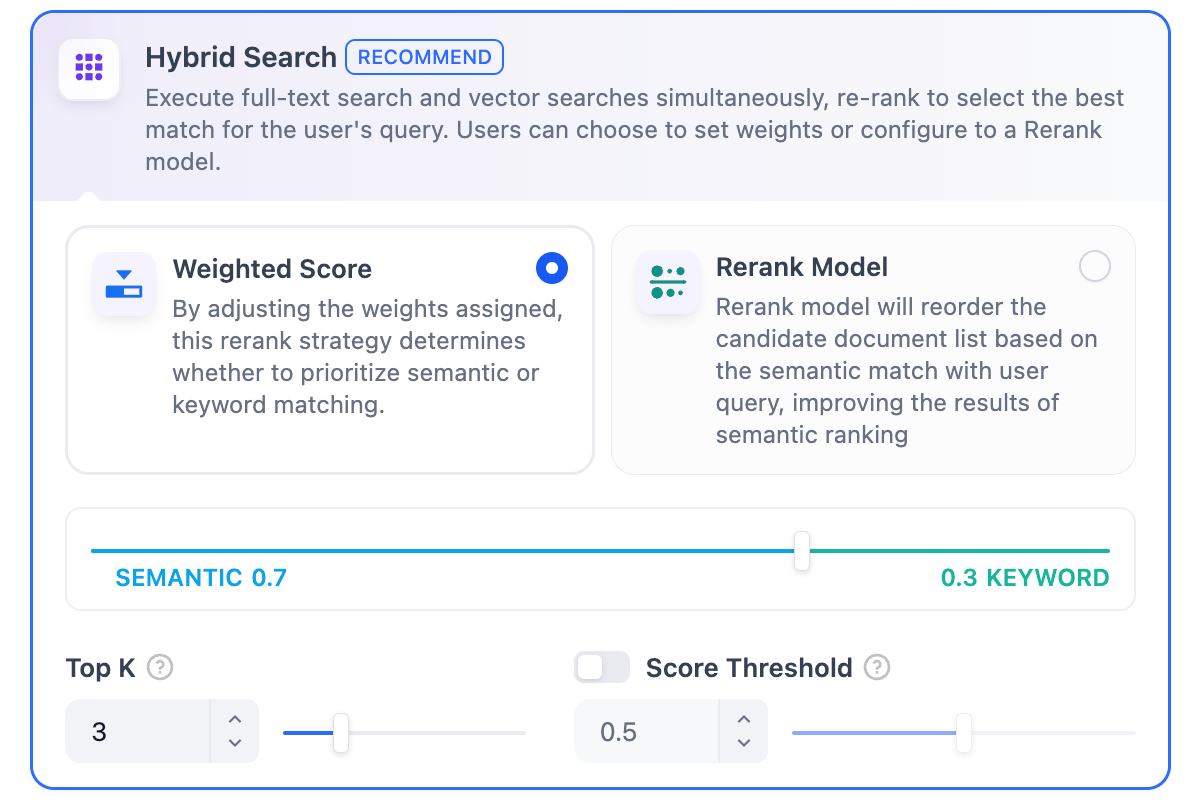

+ ハイブリッド検索設定では、**「重み付け設定」**または**「Rerankモデル」**の有効化を選択できます。

-このモードでは、RerankモデルAPIを設定せずに**「重み付け設定」**を指定するか、**Rerankモデル**を有効にして検索を行うことができます。

+ * **重み付け設定**

-* **重み付け設定**

+ ユーザーが意味的優先度とキーワード優先度にカスタム重みを付けることができます。キーワード検索はナレッジベース内での全文検索(Full Text Search)を指し、意味検索はナレッジベース内でのベクトル検索(Vector Search)を指します。

- この機能により、ユーザーは意味優先度とキーワード優先度にカスタム重みを設定できます。キーワード検索はナレッジベース内での全文検索を指し、意味検索はナレッジベース内でのベクトル検索を指します。

+ * **意味値を1にする**

- * **意味値を1にする**

+ **意味検索モードのみを有効にします**。Embeddingモデルを活用することで、クエリに含まれる正確な単語がナレッジベースになくても、ベクトル距離を計算することで検索の深度を高め、正確なコンテンツを返すことができます。また、多言語コンテンツを処理する必要がある場合、意味検索は異なる言語間の意味変換をキャプチャし、より正確なクロス言語検索結果を提供できます。

+ * **キーワード値を1にする**

- 意味検索モードのみを有効にします。埋め込みモデルを活用することで、クエリに含まれる正確な用語がナレッジベースになくても、ベクトル距離を計算することで検索の深度を高め、関連コンテンツを返すことができます。また、多言語コンテンツを処理する場合、意味検索は異なる言語間の意味をキャプチャし、より正確なクロス言語検索結果を提供できます。

- * **キーワード値を1にする**

+ **キーワード検索モードのみを有効にします**。ユーザーが入力した情報テキストをナレッジベース全体でマッチングし、ユーザーが正確な情報や用語を知っているシナリオに適しています。この方法は消費する計算リソースが比較的少なく、大量の文書を含むナレッジベース内での迅速な検索に適しています。

+ * **キーワードと意味の重みをカスタマイズする**

- キーワード検索モードのみを有効にします。ナレッジベース内で入力テキストとの完全一致を実行し、ユーザーが正確な情報や用語を知っているシナリオに適しています。この方法は消費する計算リソースが比較的少なく、大量のドキュメントを含むナレッジベース内での迅速な検索に適しています。

- * **キーワードと意味の重みをカスタマイズする**

+ 異なる値を1に引き上げるだけでなく、両者の重みを継続的に調整して、ビジネスシナリオに合った最適な重み比率を見つけることができます。

+

+ > 意味検索とは、ユーザーの質問とナレッジベースコンテンツ内のベクトル間の距離を比較することを指します。距離が近いほど、マッチングの確率が高くなります。

- 意味検索またはキーワード検索のみを有効にするだけでなく、柔軟なカスタム重み設定を提供しています。両方の方法の重みを継続的に調整して、ビジネスシナリオに合った最適な重み比率を見つけることができます。

***

- **Rerankモデル**

+ * **Rerankモデル**

- デフォルトでは無効です。有効にすると、サードパーティのRerankモデルがハイブリッド検索によって返されたテキストチャンクを並べ替えて結果を最適化します。これにより、LLMがより正確な情報にアクセスし、出力品質を向上させることができます。このオプションを有効にする前に、**設定** → **モデルプロバイダー**に移動してRerankモデルのAPIキーを設定してください。

+ デフォルトでは無効です。有効にすると、ハイブリッド検索によって呼び出されたコンテンツセグメントを第三者のRerankモデルを使用して再度並べ替え、並べ替え結果を最適化します。LLMに再並べ替えされたセグメントを送信し、出力コンテンツの品質を向上させます。このオプションを有効にする前に、「設定」→「モデルプロバイダー」に移動し、RerankモデルのAPIキーを事前に設定する必要があります。

-

-

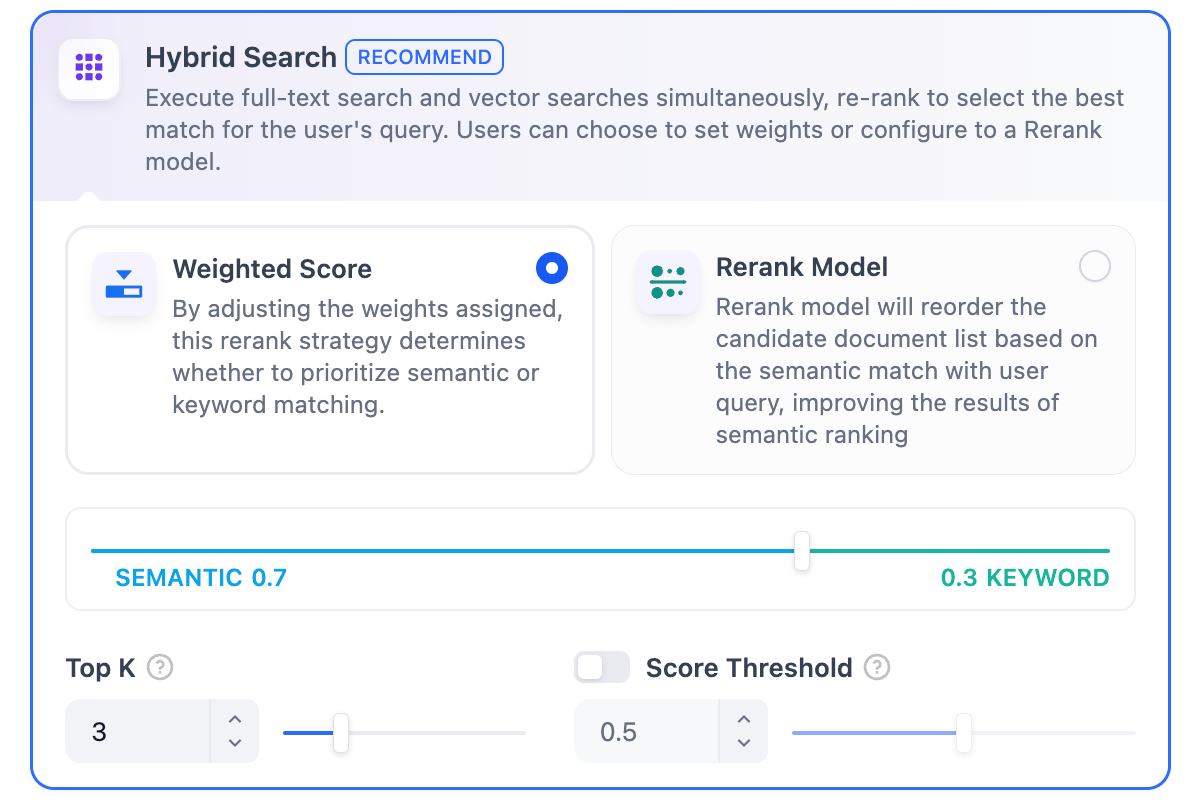

+ ハイブリッド検索設定では、**「重み付け設定」**または**「Rerankモデル」**の有効化を選択できます。

-このモードでは、RerankモデルAPIを設定せずに**「重み付け設定」**を指定するか、**Rerankモデル**を有効にして検索を行うことができます。

+ * **重み付け設定**

-* **重み付け設定**

+ ユーザーが意味的優先度とキーワード優先度にカスタム重みを付けることができます。キーワード検索はナレッジベース内での全文検索(Full Text Search)を指し、意味検索はナレッジベース内でのベクトル検索(Vector Search)を指します。

- この機能により、ユーザーは意味優先度とキーワード優先度にカスタム重みを設定できます。キーワード検索はナレッジベース内での全文検索を指し、意味検索はナレッジベース内でのベクトル検索を指します。

+ * **意味値を1にする**

- * **意味値を1にする**

+ **意味検索モードのみを有効にします**。Embeddingモデルを活用することで、クエリに含まれる正確な単語がナレッジベースになくても、ベクトル距離を計算することで検索の深度を高め、正確なコンテンツを返すことができます。また、多言語コンテンツを処理する必要がある場合、意味検索は異なる言語間の意味変換をキャプチャし、より正確なクロス言語検索結果を提供できます。

+ * **キーワード値を1にする**

- 意味検索モードのみを有効にします。埋め込みモデルを活用することで、クエリに含まれる正確な用語がナレッジベースになくても、ベクトル距離を計算することで検索の深度を高め、関連コンテンツを返すことができます。また、多言語コンテンツを処理する場合、意味検索は異なる言語間の意味をキャプチャし、より正確なクロス言語検索結果を提供できます。

- * **キーワード値を1にする**

+ **キーワード検索モードのみを有効にします**。ユーザーが入力した情報テキストをナレッジベース全体でマッチングし、ユーザーが正確な情報や用語を知っているシナリオに適しています。この方法は消費する計算リソースが比較的少なく、大量の文書を含むナレッジベース内での迅速な検索に適しています。

+ * **キーワードと意味の重みをカスタマイズする**

- キーワード検索モードのみを有効にします。ナレッジベース内で入力テキストとの完全一致を実行し、ユーザーが正確な情報や用語を知っているシナリオに適しています。この方法は消費する計算リソースが比較的少なく、大量のドキュメントを含むナレッジベース内での迅速な検索に適しています。

- * **キーワードと意味の重みをカスタマイズする**

+ 異なる値を1に引き上げるだけでなく、両者の重みを継続的に調整して、ビジネスシナリオに合った最適な重み比率を見つけることができます。

+

+ > 意味検索とは、ユーザーの質問とナレッジベースコンテンツ内のベクトル間の距離を比較することを指します。距離が近いほど、マッチングの確率が高くなります。

- 意味検索またはキーワード検索のみを有効にするだけでなく、柔軟なカスタム重み設定を提供しています。両方の方法の重みを継続的に調整して、ビジネスシナリオに合った最適な重み比率を見つけることができます。

***

- **Rerankモデル**

+ * **Rerankモデル**

- デフォルトでは無効です。有効にすると、サードパーティのRerankモデルがハイブリッド検索によって返されたテキストチャンクを並べ替えて結果を最適化します。これにより、LLMがより正確な情報にアクセスし、出力品質を向上させることができます。このオプションを有効にする前に、**設定** → **モデルプロバイダー**に移動してRerankモデルのAPIキーを設定してください。

+ デフォルトでは無効です。有効にすると、ハイブリッド検索によって呼び出されたコンテンツセグメントを第三者のRerankモデルを使用して再度並べ替え、並べ替え結果を最適化します。LLMに再並べ替えされたセグメントを送信し、出力コンテンツの品質を向上させます。このオプションを有効にする前に、「設定」→「モデルプロバイダー」に移動し、RerankモデルのAPIキーを事前に設定する必要があります。

-

-  -

-

-

-

-

-

-

-

-

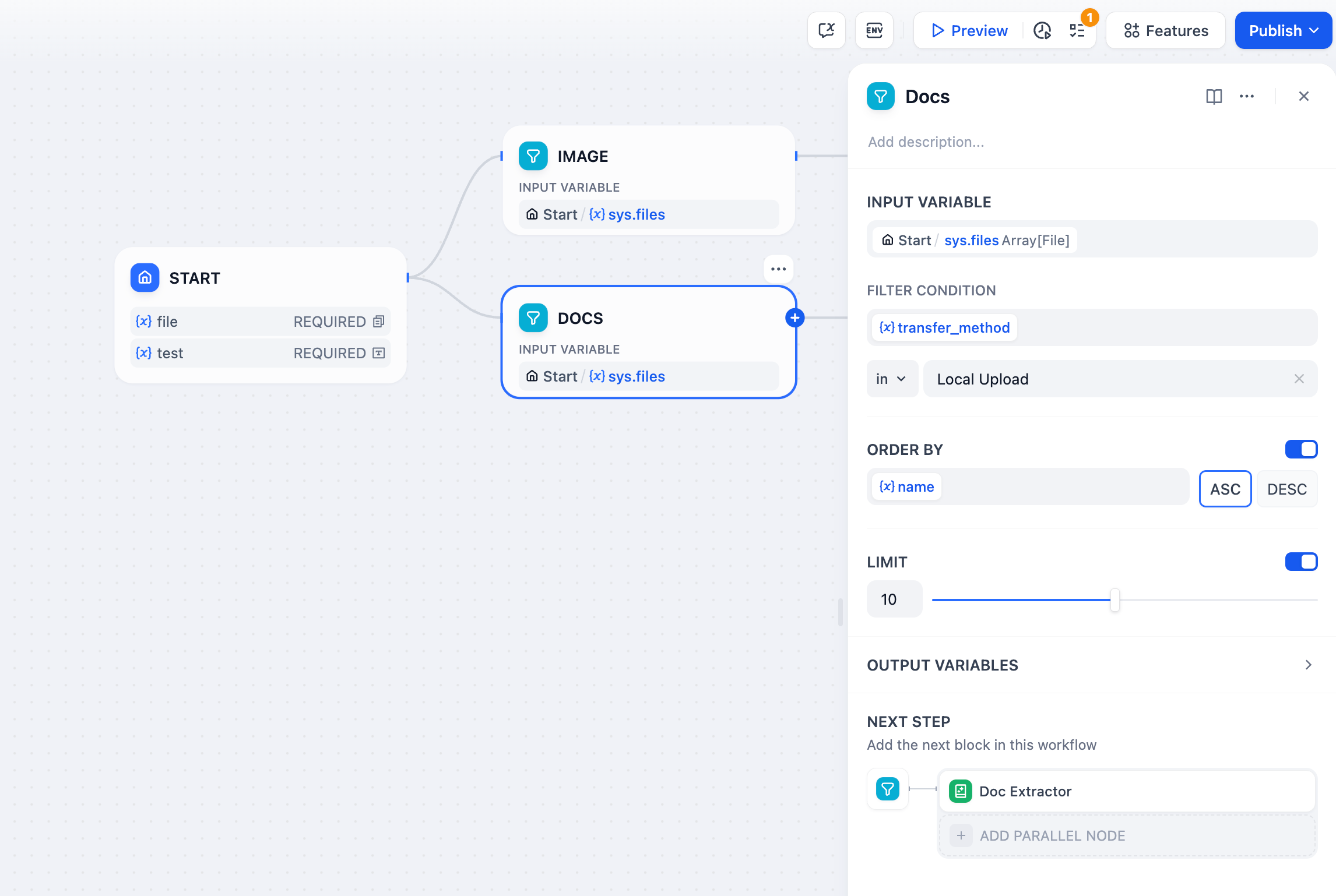

-**設定オプション**

-

-| 項目 | 説明 |

-|----------------|------------------------------------|

-| ファイル形式 | PDF、XLSX、DOCXなどに対応。ユーザーは選択をカスタマイズできます |

-| アップロード方法 | ドラッグ&ドロップまたはファイル選択でローカルファイルやフォルダをアップロード。バッチアップロード対応 |

+

---

@@ -94,22 +92,18 @@ title: ステップ2:ナレッジパイプラインをオーケストレーシ

Notionワークスペースと連携し、ページやデータベースをシームレスにインポート可能です。ナレッジベースは常に自動で最新状態に保たれます。

-

+

+

+

+

+ **設定オプション**

-**制限事項**

+ | 項目 | 説明 |

+ |----------------|------------------------------------|

+ | ファイル形式 | PDF、XLSX、DOCXなどに対応 |

+ | アップロード方法 | ドラッグ&ドロップまたは選択、バッチ対応 |

-| 項目 | 説明 |

-|--------------|-------------------------------------------------|

-| ファイル数 | 1回あたり最大50ファイルまで |

-| ファイルサイズ | 1ファイルあたり最大15MB |

-| ストレージ | SaaSサブスクリプションプランによりアップロード上限やストレージ容量が異なる場合があります |

+ **制限事項**

-**出力変数**

+ | 項目 | 説明 |

+ |--------------|-------------------------------------------------|

+ | ファイル数 | 1回あたり最大50ファイルまで |

+ | ファイルサイズ | 1ファイルあたり最大15MB |

+ | ストレージ | サブスクリプションプランによりアップロード上限が異なります |

-| 出力変数 | 形式 |

-|----------------|-----------------|

-| `{x} Document` | 単一ドキュメント |

-

-

+ **出力変数**

+ | 出力変数 | 形式 |

+ |----------------|-----------------|

+ | `{x} Document` | 単一ドキュメント |

+

-

- 对于自托管部署,可通过环境变量调整以下限制:

+ 对于自托管部署,可通过环境变量 `ATTACHMENT_IMAGE_FILE_SIZE_LIMIT` 调整图片大小限制。

+

- - 最大图片尺寸:`ATTACHMENT_IMAGE_FILE_SIZE_LIMIT`

+

+ 每个分段最多支持 10 个图片附件,超出的图片不会被提取。

- - 每个分段的最大附件数量:`SINGLE_CHUNK_ATTACHMENT_LIMIT`

-

+ 对于自托管部署,可通过环境变量 `SINGLE_CHUNK_ATTACHMENT_LIMIT` 调整此数量限制。

+

-若在索引设置中选择多模态嵌入模型(带有 **Vision** 图标),则提取出的图片也将被向量化并参与检索。

+若在后续的索引设置中选择多模态嵌入模型(带有 **Vision** 图标),则提取出的图片将被向量化并参与检索。

@@ -242,23 +234,21 @@ Dify Extractor 是 Dify 开发的一款内置文档解析器。它支持多种

-

-

-

-

-

-**設定オプション**

-

-| 項目 | オプション | 出力変数 | 説明 |

-|------------|------------|-----------------|------------------------|

-| Extractor | 有効 | `{x} Content` | 構造化・処理済み情報 |

-| | 無効 | `{x} Document` | オリジナルテキスト |

-

-

-

+

+

---

@@ -122,53 +116,45 @@ Webコンテンツを大規模言語モデルでも読みやすい形式に変

シンプルかつ使いやすいAPIを提供するオープンソースのWeb解析ツールです。Webコンテンツの高速クロールと処理に適しています。

-

+

+

+

+ **設定オプション**

+

+ | 項目 | オプション | 出力変数 | 説明 |

+ |------------|------------|-----------------|------------------------|

+ | Extractor | 有効 | `{x} Content` | 構造化・処理済み情報 |

+ | | 無効 | `{x} Document` | オリジナルテキスト |

+

-

----

-

### 在线网盘

连接你的在线云储存服务(例如 Google Drive、Dropbox、OneDrive),Dify 将自动检索云储存中的文件,你可以勾选并导入相应文档进行下一步处理,无需手动下载文件再进行上传。

@@ -196,24 +190,22 @@ title: "步骤二:编排知识流水线"

通过合适的文档处理工具,可将文档中的图片提取为对应分段的附件。被提取的图片可独立管理,并在检索时与分段一同返回。

-被提取图片的 URL 会保留在分段文本中,但你可以安全地删除这些 URL 以保持文本整洁——这不会影响已提取的图片。

-

-每个分段最多支持 10 个图片附件,超出的图片不会被提取。

-

若使用的工具未提取到图片,Dify 会自动提取通过以下 Markdown 语法引用、URL 可访问且小于 2 MB 的 JPG、JPEG、PNG 和 GIF 图片:

- ``

- ``

-

-

-

-

-

-**パラメータ設定**

-

-| パラメータ | 種類 | 説明 |

-|--------------------|--------|------------------------------------------------|

-| URL | 必須 | 対象Webページのアドレス |

-| サブページのクロール | 任意 | リンク先ページもクロールするか |

-| サイトマップ使用 | 任意 | サイトマップを利用してクロール |

-| 制限 | 必須 | クロールする最大ページ数 |

-| Extractor有効化 | 任意 | データ抽出方式の選択 |

-

-

-

+

+

#### Firecrawl

きめ細かなクロール制御オプションとAPIサービスを持つオープンソースのWeb解析ツールです。複雑なサイトの深層クロールやバッチ処理に適しています。

-

+

+

+

+ **パラメータ設定**

+

+ | パラメータ | 種類 | 説明 |

+ |--------------------|--------|------------------------------------------------|

+ | URL | 必須 | 対象Webページのアドレス |

+ | サブページのクロール | 任意 | リンク先ページもクロールするか |

+ | サイトマップ使用 | 任意 | サイトマップを利用してクロール |

+ | 制限 | 必須 | クロールする最大ページ数 |

+ | Extractor有効化 | 任意 | データ抽出方式の選択 |

+

-

-ドキュメント内の画像は、適切なドキュメントプロセッサを使用して抽出できます。抽出された画像は対応するチャンクに添付され、個別に管理でき、検索時にはそのチャンクと一緒に返されます。

-

-抽出された画像のURLはチャンクテキスト内に残りますが、テキストをクリーンに保つためにこれらのURLを安全に削除できます。これは抽出された画像には影響しません。

+ ドキュメント内の画像は、適切なドキュメントプロセッサを使用して抽出できます。抽出された画像は対応するチャンクに添付され、個別に管理でき、検索時にはそのチャンクと一緒に返されます。

-各チャンクには最大10枚まで画像を添付できます。これを超える画像は抽出されません。

+ 選択したプロセッサで画像が抽出されなかった場合、Difyは以下のMarkdown記法でアクセス可能なURLが参照されている2MB未満のJPG、PNG、GIF画像を自動的に抽出します:

-選択したプロセッサで画像が抽出されなかった場合、Difyは以下のMarkdown記法でアクセス可能なURLが参照されている2MB未満のJPG、JPEG、PNG、GIF画像を自動的に抽出します:

+ - ``

+ - ``

- - ``

- - ``

+

+ セルフホスト環境では、環境変数 `ATTACHMENT_IMAGE_FILE_SIZE_LIMIT` でサイズ上限を調整できます。

+

-

- セルフホスト環境では、以下の上限を環境変数で調整できます:

+

+ 各チャンクには最大10枚まで画像を添付できます。これを超える画像は抽出されません。

- - 画像サイズの上限:`ATTACHMENT_IMAGE_FILE_SIZE_LIMIT`

-

- - 1チャンクあたりの添付画像数上限:`SINGLE_CHUNK_ATTACHMENT_LIMIT`

-

+ セルフホスト環境では、環境変数 `SINGLE_CHUNK_ATTACHMENT_LIMIT` でこの上限を調整できます。

+

-インデックス設定で**Vision**アイコン付きのマルチモーダル埋め込みモデルを選択した場合、抽出された画像も埋め込み・インデックス化され、検索対象となります。

+ その後のインデックス設定で**Vision**アイコン付きのマルチモーダル埋め込みモデルを選択した場合、抽出された画像も埋め込み・インデックス化され、検索対象となります。

#### Doc Extractor(ドキュメント抽出器)

-

+

-情報処理の中核となり、入力変数からファイルを識別・読取・情報抽出を行い、次のノードで利用できる形式へ変換します。

+情報処理の中核となり、入力ファイルを識別・読取・情報抽出を行い、次のノードで利用できる形式へ変換します。

-詳細は[ドキュメント抽出器](/ja/use-dify/nodes/doc-extractor)をご参照ください。

+詳細は[ドキュメント抽出器](/ja-jp/use-dify/nodes/doc-extractor)をご参照ください。

#### Dify Extractor

@@ -240,18 +224,15 @@ Dify Extractorは、Difyが提供する内蔵ドキュメント解析ツール

#### Unstructured

-

他のツールについては[Dify Marketplace](https://marketplace.dify.ai)をご覧ください。

@@ -297,22 +278,22 @@ Dify Extractorは、Difyが提供する内蔵ドキュメント解析ツール

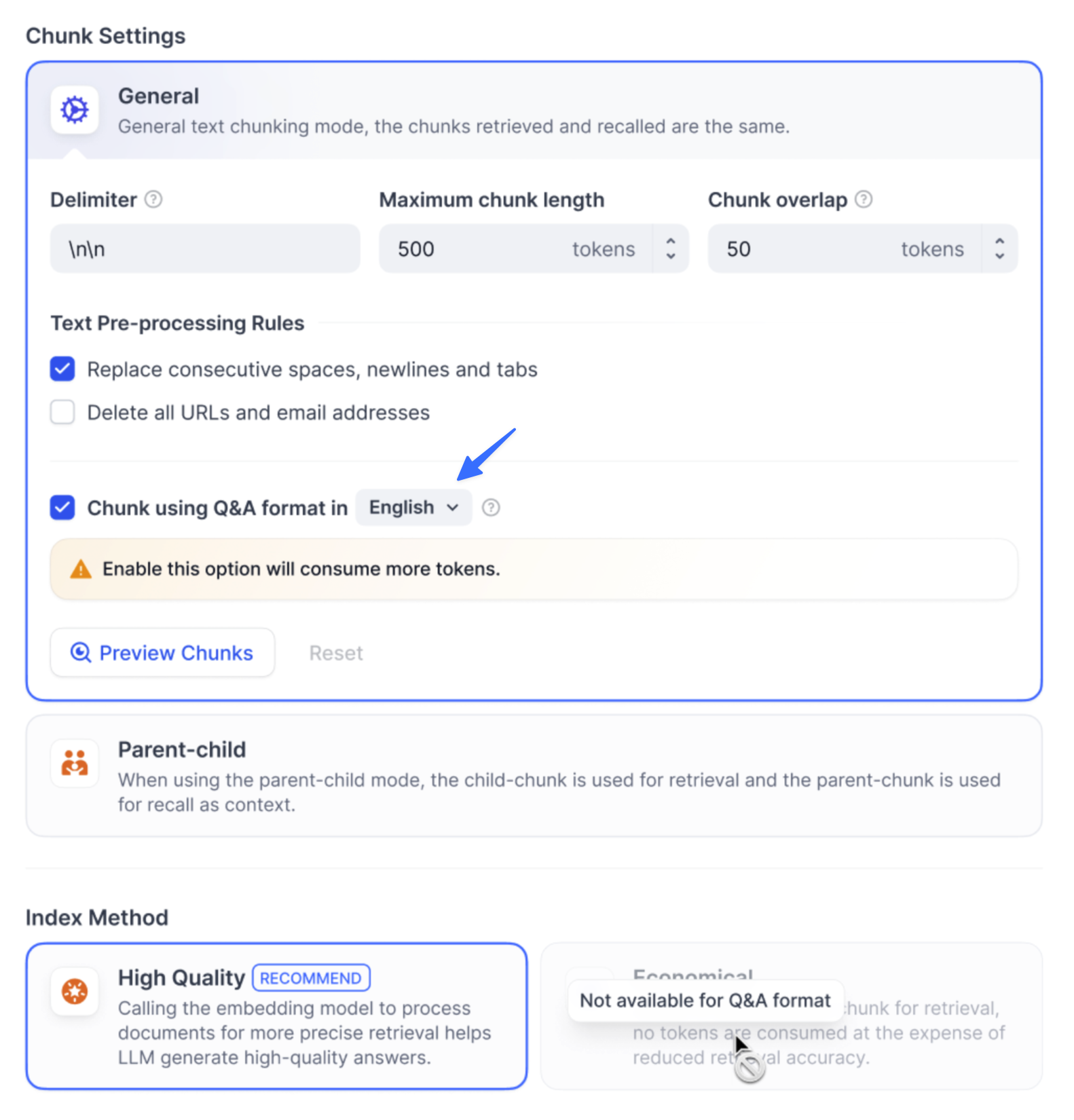

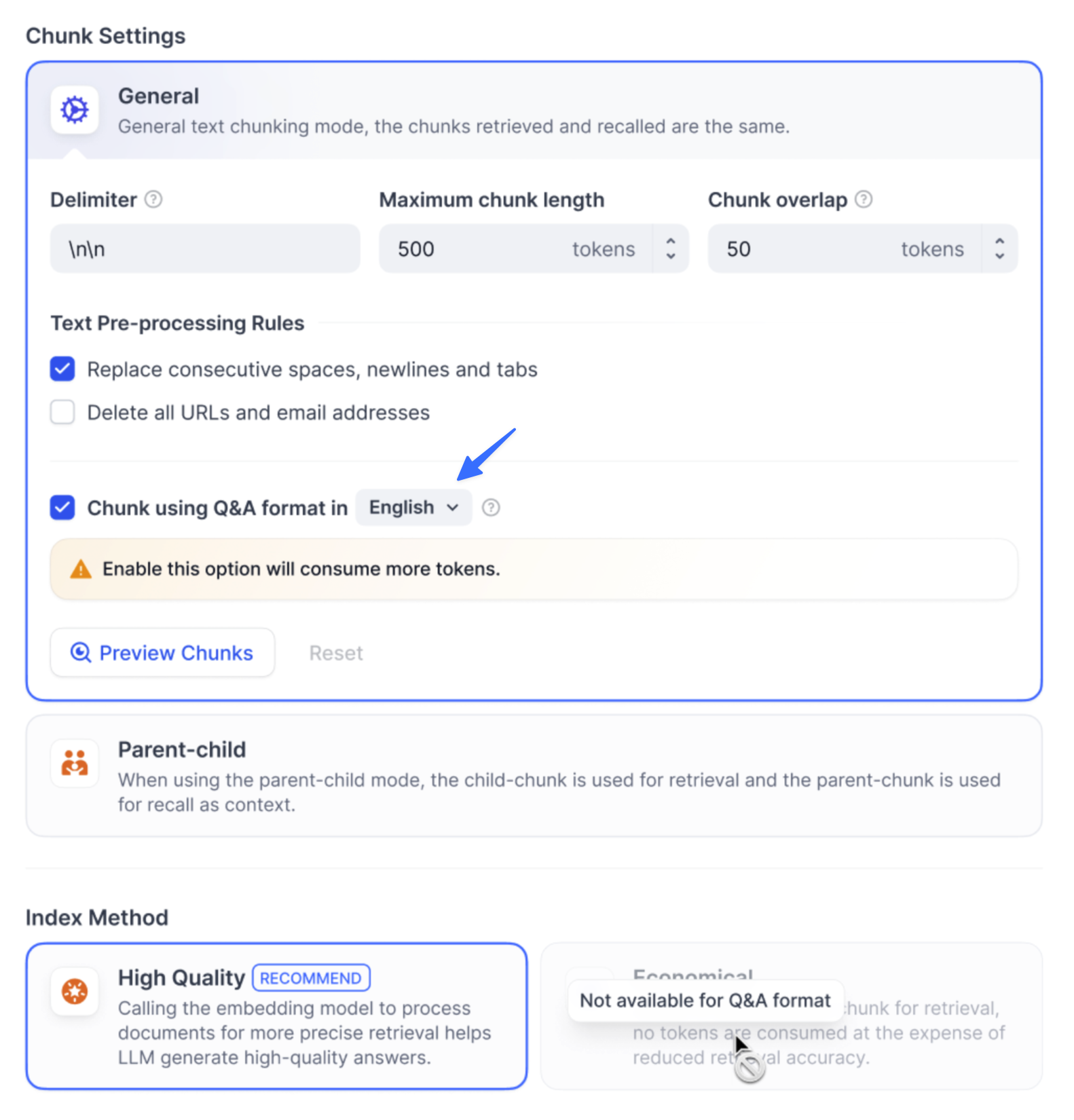

| 設定項目 | 説明 |

|-------------------|--------------------------------------------------------------------------|

-| 区切り文字 | デフォルトは`\n`(段落区切り用改行)。正規表現によるカスタム分割ルールも利用可。テキスト内に区切り文字が出現すると自動的に分割されます。 |

-| 最大チャンク長 | 各セグメントの最大文字数。上限超過時は強制分割されます。 |

+| 区切り文字 | デフォルトは`\n`(段落区切り用改行)。正規表現も利用可。 |

+| 最大チャンク長 | 各セグメントの最大文字数(上限超過時は自動分割) |

| チャンク重複 | 分割時にセグメント間で部分重複させることで情報保持・検索精度を向上 |

#### 親子分割器(Parent-child Chunker)

-クエリマッチング精度と豊富なコンテキスト両立のため、二層チャンク構造を採用し、RAGシステムにおけるコンテキストと精度の矛盾を解決します。

+クエリマッチング精度と豊富なコンテキスト両立のため、二層チャンク構造を採用しています。

**親子分割器の仕組み**

-- **子チャンク(高精度マッチング用)**:ユーザーのクエリに高精度でマッチングするための小さく精密な情報セグメント(通常、1文ごと)

-- **親チャンク(豊富なコンテキスト)**:該当する子チャンクを含む広い範囲のコンテンツブロック(段落、セクション、またはドキュメント全体)で、大規模言語モデル(LLM)に包括的な背景情報を提供

+- **子チャンク(高精度マッチング用)**:通常、1文ごとの細かなセグメント

+- **親チャンク(豊富なコンテキスト)**:該当する子チャンクを含む広い範囲(段落やセクション単位)

| タイプ | 変数 | 説明 |

|------------|---------------------------|------------------------------|

-| 入力変数 | `{x} Content` | 分割対象となる文書コンテンツ |

+| 入力変数 | `{x} Content` | 原文テキスト |

| 出力変数 | `{x} Array[ParentChunk]` | 親チャンク配列 |

**分割設定**

@@ -323,7 +304,7 @@ Dify Extractorは、Difyが提供する内蔵ドキュメント解析ツール

| 親チャンク最大長 | 親チャンクの最大文字数 |

| 子チャンク区切り文字 | 子チャンク分割ルール |

| 子チャンク最大長 | 子チャンクの最大文字数 |

-| 親モード | 「段落」(テキストを段落に分割)または「全文書」(ドキュメント全体を親チャンクとして直接検索に使用)いずれか選択 |

+| 親モード | 「段落」または「全文書」いずれか選択 |

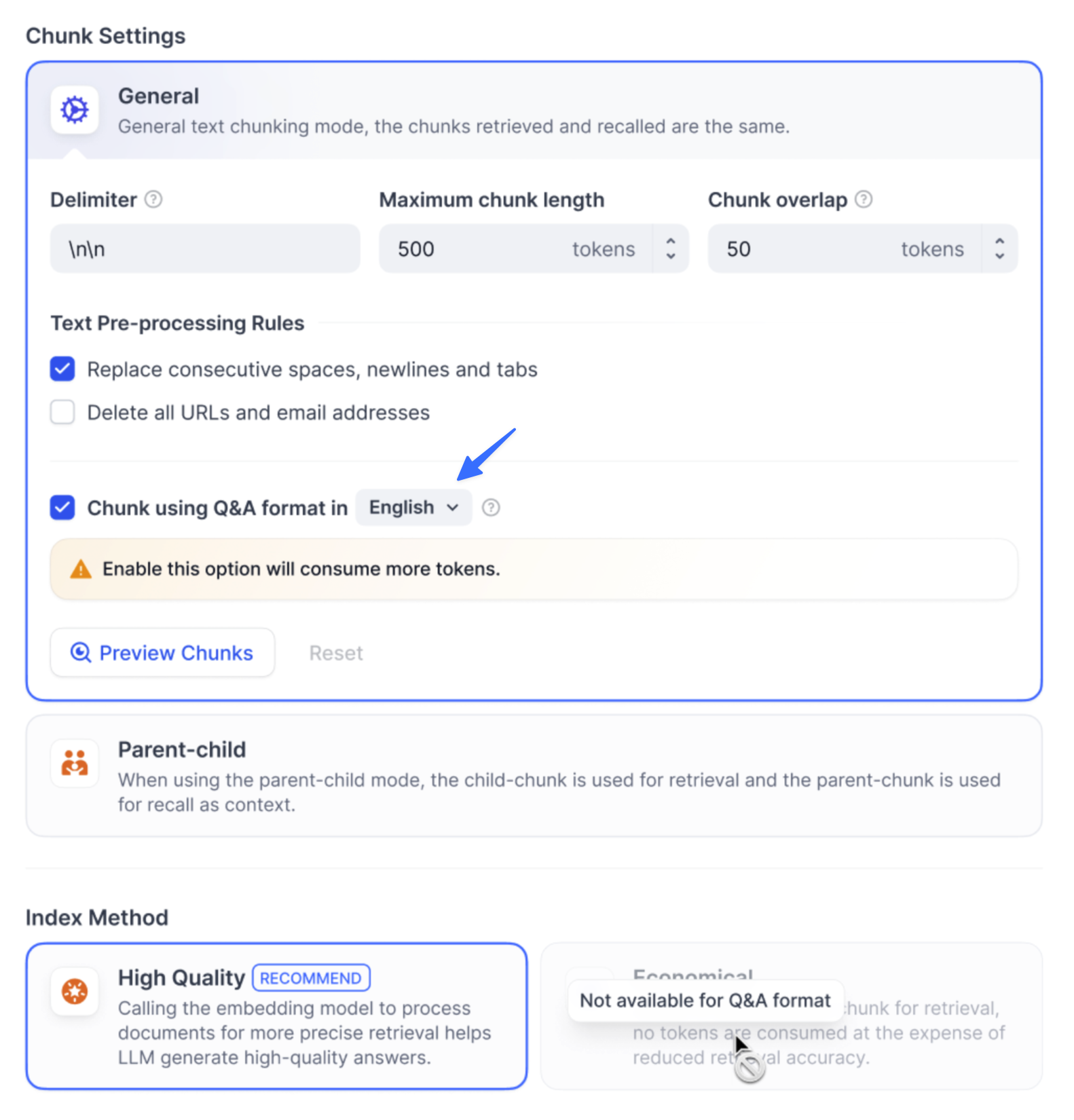

#### Q&Aプロセッサ

@@ -334,14 +315,14 @@ Dify Extractorは、Difyが提供する内蔵ドキュメント解析ツール

| タイプ | 変数 | 説明 |

|-----------|------------------------|---------------------------------------|

| 入力変数 | `{x} Document` | 単一ファイル |

-| 出力変数 | `{x} Array[QAChunk]` | Q&Aチャンク |

+| 出力変数 | `{x} Array[QAChunk]` | Q&Aチャンク配列 |

**変数設定**

| 設定項目 | 説明 |

|-----------------|------------------|

-| 質問用カラム番号 | 質問として設定するコンテンツ列 |

-| 回答用カラム番号 | 回答として設定する列 |

+| 質問用カラム番号 | 質問内容の列番号 |

+| 回答用カラム番号 | 回答内容の列番号 |

---

@@ -355,9 +336,9 @@ Dify Extractorは、Difyが提供する内蔵ドキュメント解析ツール

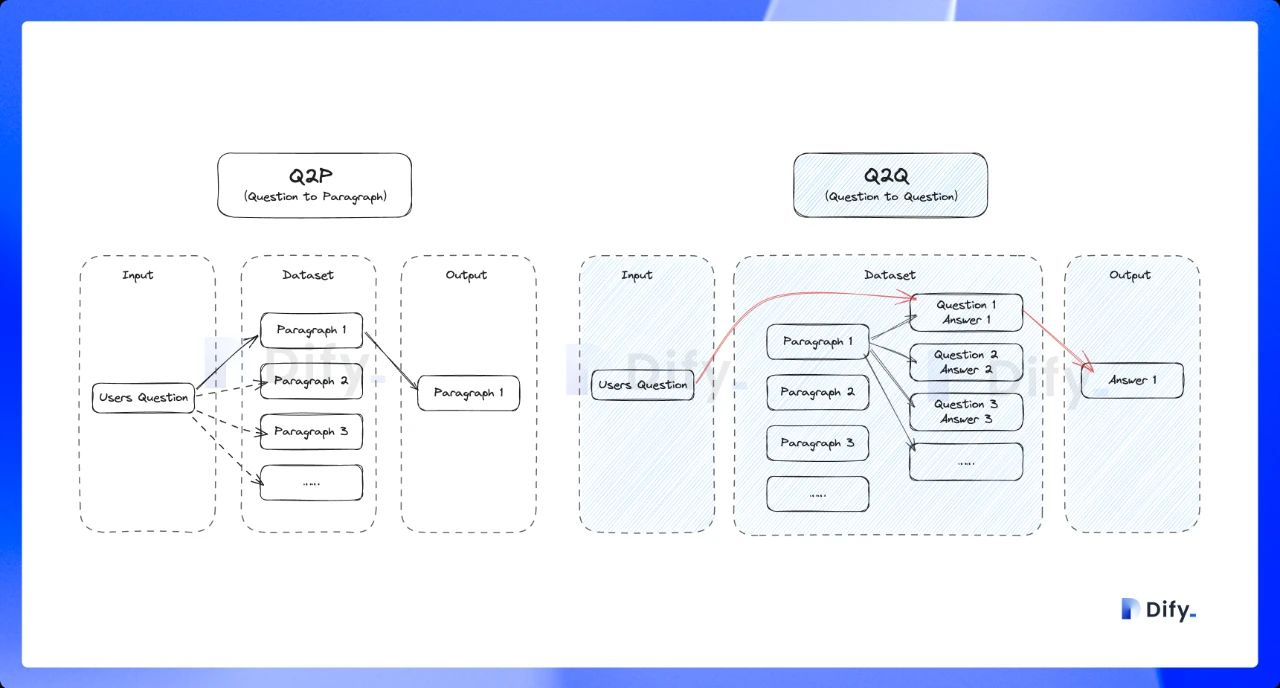

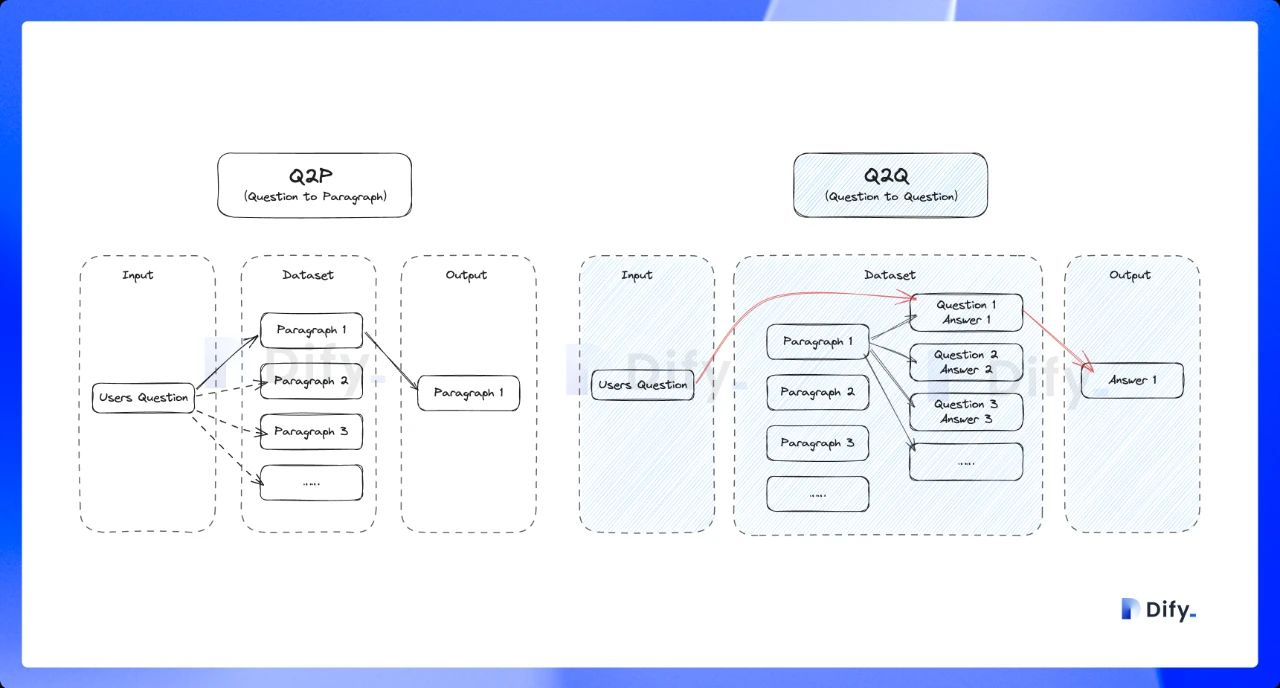

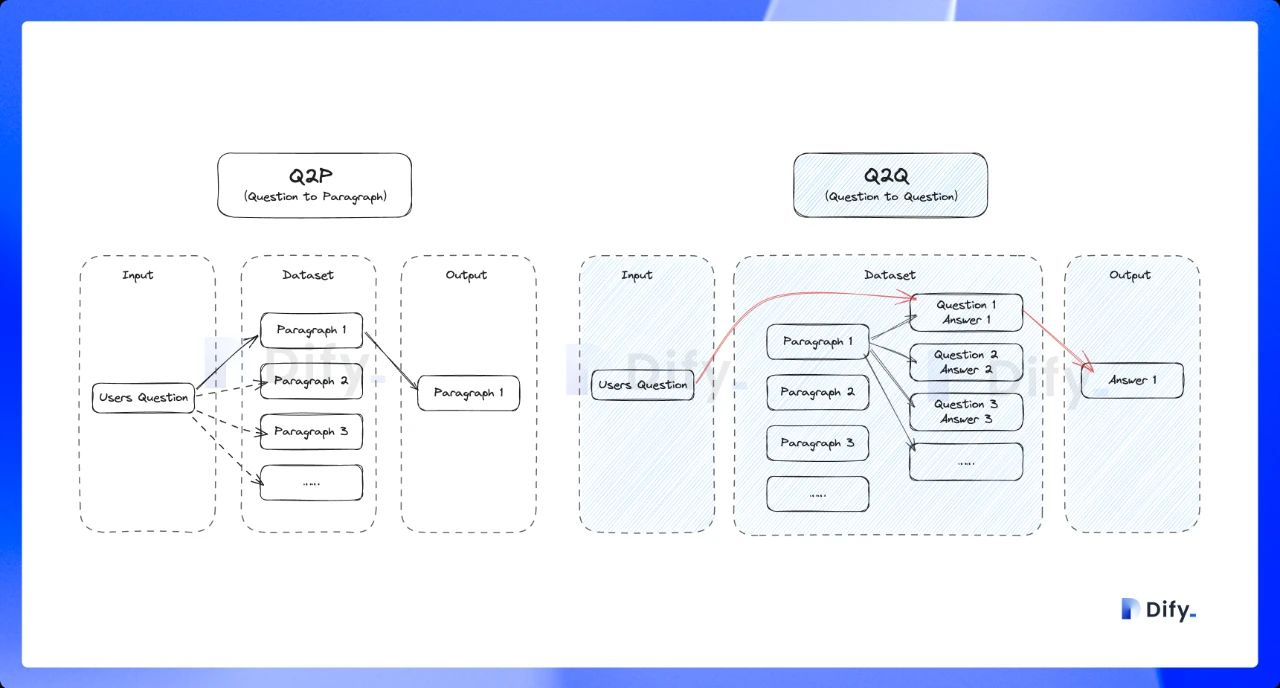

-チャンク構造は、ナレッジベースが文書コンテンツをどう整理・インデックス化するかを定めます。ドキュメントタイプ、用途、コストに適したモードを選択してください。

+チャンク構造は、ナレッジベースが文書コンテンツをどう整理・インデックス化するかを定めます。用途やコストに適したモードを選択してください。

-ナレッジベースは3つのチャンクモードをサポートします:**汎用モード**、**親子モード**、**Q&Aモード**。初めてナレッジベースを作成する場合は親子モードが推奨されます。

+ナレッジベースは3つのチャンクモードをサポートします:**汎用モード**、**親子モード**、**Q&Aモード**。初めて設定する場合は親子モードが推奨されます。

**重要:** チャンク構造は一度保存・公開すると変更できません。慎重にご選択ください。

@@ -365,157 +346,146 @@ Dify Extractorは、Difyが提供する内蔵ドキュメント解析ツール

#### 汎用モード

-標準的なドキュメント処理に最適です。柔軟なインデックスオプションを提供し、品質やコストの異なる要件に応じて適切なインデックス方法を選択できます。

-

-汎用モードは高品質とコスト効率の両方のインデックス方法、および各種検索設定をサポートします。

+標準的なドキュメント処理に最適です。ニーズに応じ、柔軟なインデックスと検索設定が選択可能です。

#### 親子モード

-検索時の高精度マッチングと対応するコンテキスト情報を提供し、完全なコンテキストを維持する必要がある専門ドキュメントに適しています。

-

-親子モードはHQ(高品質)モードのみ対応で、クエリマッチング用の子チャンクと検索時のコンテキスト情報用の親チャンクを提供します。

+検索時の高精度マッチングと文脈提供が必要なエンタープライズ向け専門ドキュメントに最適です。HQ(高品質)インデックスのみ対応です。

#### Q&Aモード

-構造化された質問回答データを使用する際に、質問と回答をペアにしたドキュメントを作成します。これらのドキュメントは質問部分に基づいてインデックス化され、クエリの類似性に基づいて関連する回答を検索できます。

-

-Q&AモードはHQ(高品質)モードのみ対応です。

+構造化された質問回答データ向けです。Q&Aペアが質問部に基づいてインデックス化され、関連回答が検索できます。こちらもHQモードのみ対応です。

### 入力変数

-入力変数はデータ処理ノードからの処理結果をナレッジベースのデータソースとして受け取ります。分割器の出力をナレッジベースノードへ入力として接続する必要があります。

-

-ノードは選択したチャンク構造に基づいて異なるタイプの標準入力をサポートします:

+入力変数はデータ処理ノードからの出力をナレッジベースのデータソースとして受け取ります。分割器の出力をナレッジベースノードへ接続します。

-- **汎用モード**:x Array[Chunk] - 汎用チャンク配列

-- **親子モード**:x Array[ParentChunk] - 親チャンク配列

-- **Q&Aモード**:x Array[QAChunk] - Q&Aチャンク配列

+- **汎用モード**:`{x} Array[Chunk]`(汎用チャンク配列)

+- **親子モード**:`{x} Array[ParentChunk]`(親チャンク配列)

+- **Q&Aモード**:`{x} Array[QAChunk]`(Q&Aチャンク配列)

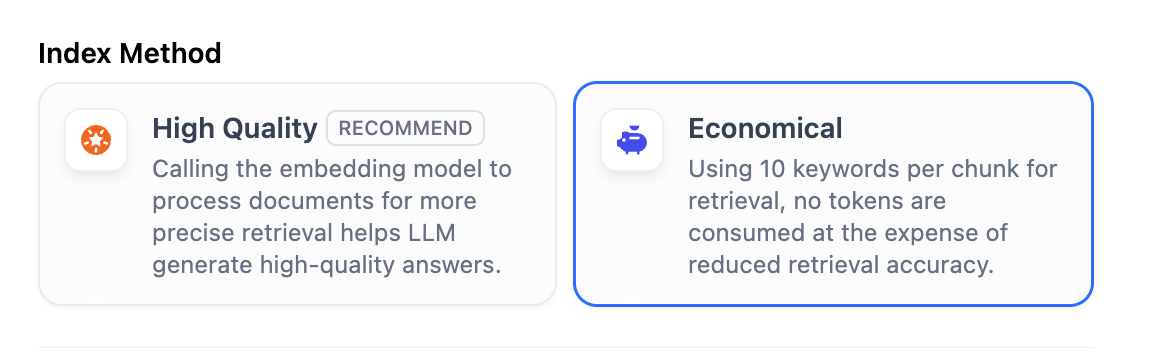

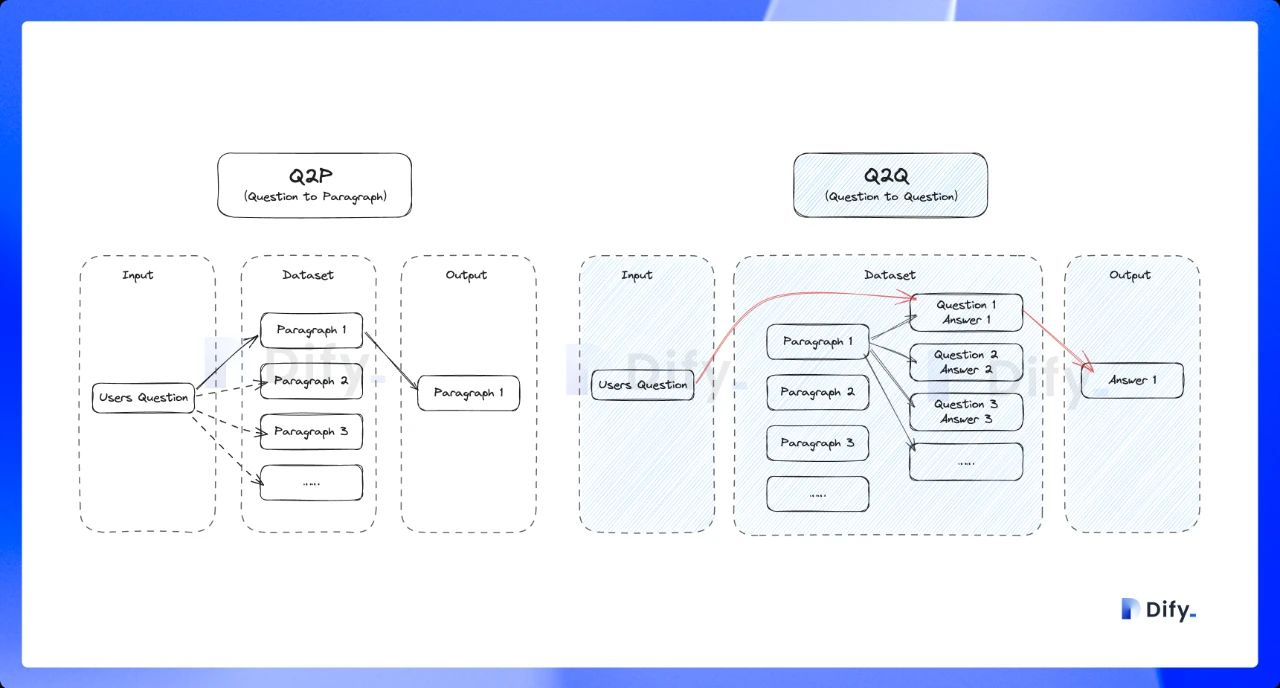

### インデックス方法と検索設定

-インデックス方法はナレッジベース内のコンテンツインデックスの構築方法を決定し、検索設定は選択したインデックス方法に基づいた対応する検索戦略を提供します。

-

-つまり、インデックス方法はドキュメントの整理方法を決定し、検索設定はユーザーがドキュメントを見つけるために使用できる方法を指定します。

-

-ナレッジベースでは**高品質**と**コスト効率**の2つのインデックス方法があり、それぞれ異なる検索設定オプションを提供します。

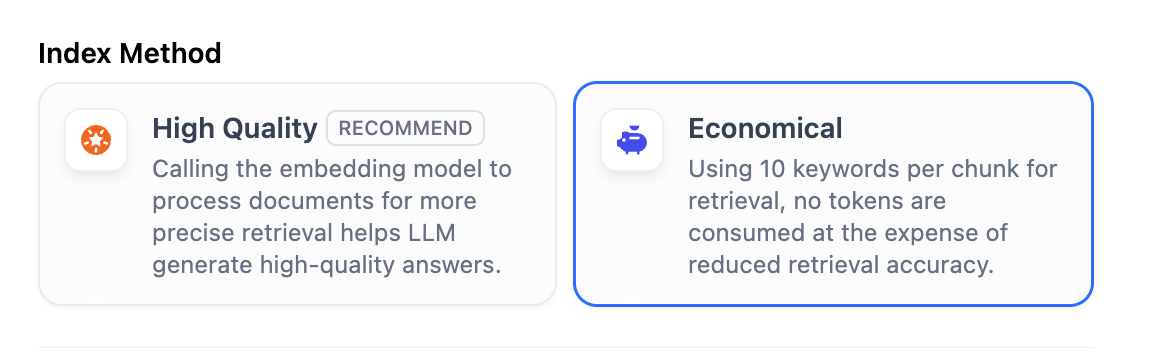

+インデックス方法はナレッジベース内のコンテンツ整理法を決定し、検索設定はそれに基づいた検索戦略を指定します。

+ナレッジベースでは**高品質**と**コスト効率**の2方式があり、それぞれ検索方法が異なります。

-**高品質モード**では、埋め込みモデルを使用してチャンクを数値ベクトルに変換し、大量の情報をより効果的に圧縮・保存できます。これにより、ユーザーの質問の言い回しがドキュメントと完全に一致しなくても、意味的に関連する正確な回答をシステムが見つけることができます。

+**高品質モード**では、埋め込みモデル(Embedding)によりテキストをベクトル化し、意味的な関連性検索が可能です(完全一致でなくても適切な回答に辿り着けます)。

- クロスモーダル検索(テキストと画像を意味的関連性に基づいて取得)を有効にするには、**Vision**アイコン付きのマルチモーダル埋め込みモデルを選択してください。ドキュメントから抽出された画像も埋め込み・インデックス化され、検索対象となります。

+

+ クロスモーダル検索(テキストと画像を意味的関連性に基づいて取得)を有効にするには、**Vision**アイコン付きのマルチモーダル埋め込みモデルを選択してください。ドキュメントから抽出された画像もベクトル化され、検索用にインデックス化されます。

このような埋め込みモデルを使用するナレッジベースは、カード上で**Multimodal**と表示されます。

+

+

-**コスト効率モード**では、各ブロックは10個のキーワードで検索用にインデックス化され、埋め込みモデルを呼び出さないためコストは発生しません。

+**コスト効率モード**では、各ブロックは10個のキーワードでインデックス化され、埋め込みモデルのコストは発生しません。

+

+

+詳細は[インデックス方法と検索設定を指定](/ja/use-dify/knowledge/create-knowledge-and-upload-documents/setting-indexing-methods)もご参照ください。

+

-

-詳細は[インデックス方法と検索設定を指定](/ja/use-dify/knowledge/create-knowledge/setting-indexing-methods)をご参照ください。

-

+#### インデックス方法と検索設定概要

-| インデックス方法 | 利用可能な検索設定 | 説明 |

+| インデックス方法 | 検索設定 | 説明 |

|----------------|----------------|-----------------------------------------------------|

-| 高品質 | ベクトル検索 | 意味的類似性に基づいてクエリの深い意味を理解 |

-| | 全文検索 | キーワードベースの包括的検索機能を提供 |

-| | ハイブリッド検索| 意味検索とキーワード検索を組み合わせ |

-| コスト効率 | 逆引きインデックス| 一般的な検索エンジン検索方式で、クエリを主要コンテンツとマッチング |

+| 高品質 | ベクトル検索 | 意味的類似性(自然言語での深い検索) |

+| | 全文検索 | キーワードベースの包括的検索 |

+| | ハイブリッド検索| 意味検索+キーワード検索の組合せ |

+| コスト効率 | 逆引きインデックス| 一般的な検索エンジン型方式 |

- 選択した埋め込みモデルがマルチモーダルの場合は、**Vision**アイコンが表示されたマルチモーダルリランキングモデルも選択してください。そうでない場合、検索された画像は再ランクおよび検索結果から除外されます。

+ 選択した埋め込みモデルがマルチモーダルの場合は、**Vision**アイコンが表示されたマルチモーダルリランキングモデルも選択してください。そうでない場合、検索された画像は再ランクおよび最終出力から除外されます。

-チャンク構造、インデックス方法、パラメータ、検索設定の構成については、以下の表もご参照ください。

+詳細は以下の表をご参照ください。

| チャンク構造 | インデックス方法 | パラメータ | 検索設定 |

|-------------|----------------|-------------------|----------------------|

-| 汎用モード | 高品質

コスト効率 | 埋め込みモデル

キーワード数 | ベクトル検索

全文検索

ハイブリッド検索

逆引きインデックス | -| 親子モード | 高品質のみ | 埋め込みモデル | ベクトル検索

全文検索

ハイブリッド検索 | -| Q&Aモード | 高品質のみ | 埋め込みモデル | ベクトル検索

全文検索

ハイブリッド検索 | +| 汎用モード | 高品質

コスト効率 | 埋め込みモデル

キーワード数 | ベクトル

全文

ハイブリッド検索

逆引きインデックス | +| 親子モード | 高品質のみ | 埋め込みモデル | ベクトル

全文

ハイブリッド検索 | +| Q&Aモード | 高品質のみ | 埋め込みモデル | ベクトル

全文

ハイブリッド検索 | --- ## ステップ4:ユーザー入力フォームの作成 -ユーザー入力フォームは、パイプラインを効果的に実行するために必要な初期情報を収集するために不可欠です。ワークフローの[ユーザー入力ノード](/ja/use-dify/nodes/user-input)と同様に、このフォームはユーザーから必要な詳細情報(アップロードするファイル、ドキュメント処理の特定パラメータなど)を収集し、パイプラインが正確な結果を提供するために必要なすべての情報を確保します。 - -これにより、さまざまなユースケースシナリオに特化した入力フォームを作成でき、さまざまなデータソースやドキュメント処理ステップに対するパイプラインの柔軟性と使いやすさを向上できます。 +ユーザー入力フォームは、パイプライン実行時に必要な初期情報をユーザーから収集します。ワークフローの開始ノードと同様に、必要な设置情報(アップロードファイル、特定パラメータなど)を収集し、パイプラインの柔軟性・利便性を高めます。 ### フォームの作成方法 -ユーザー入力フィールドを作成する方法は2つあります: +1. **パイプライン構築UI** + - 「入力フィールド」をクリックして作成・設定を開始 +  -1. **パイプライン構築インターフェース**\ - **入力フィールド**をクリックして入力フォームの作成と設定を開始します。\ - -2. **ノードパラメータパネル**\

- ノードを選択します。次に、右側パネルのパラメータ入力で、新しい入力項目のために「+ ユーザー入力を作成」をクリックします。新しい入力項目は入力フィールドにも収集されます。

-2. **ノードパラメータパネル**\

- ノードを選択します。次に、右側パネルのパラメータ入力で、新しい入力項目のために「+ ユーザー入力を作成」をクリックします。新しい入力項目は入力フィールドにも収集されます。 +2. **ノードパラメータパネル**

+ - ノード選択後、パラメータ入力欄の「+ ユーザー入力を作成」をクリック

+

### ユーザー入力フィールドの追加

-#### 各エントランス固有の入力

-

-

+#### 各エントランス固有入力

-これらの入力は各データソースとその下流ノードに固有です。ユーザーは対応するデータソースを選択した場合にのみ、これらのフィールドに入力する必要があります(例:異なるデータソース用の異なるURL)。

+

-**作成方法**:データソースの右側にある`+`ボタンをクリックして、その特定のデータソース用のフィールドを追加します。これらのフィールドは、そのデータソースとその後続の接続ノードからのみ参照できます。

+2. **ノードパラメータパネル**

+ - ノード選択後、パラメータ入力欄の「+ ユーザー入力を作成」をクリック

+

### ユーザー入力フィールドの追加

-#### 各エントランス固有の入力

-

-

+#### 各エントランス固有入力

-これらの入力は各データソースとその下流ノードに固有です。ユーザーは対応するデータソースを選択した場合にのみ、これらのフィールドに入力する必要があります(例:異なるデータソース用の異なるURL)。

+

-**作成方法**:データソースの右側にある`+`ボタンをクリックして、その特定のデータソース用のフィールドを追加します。これらのフィールドは、そのデータソースとその後続の接続ノードからのみ参照できます。 +これは各データソースや下流ノードに固有です。該当データソース選択時のみ入力対象となります(例:異なるURLの指定等)。

-#### すべてのエントランス用のグローバル入力

+**作成方法**:データソース横の`+`ボタンからそのソース専用フィールドを追加できます。選択したソースからのみアクセス可能です。

-

+

-グローバル共有入力はすべてのノードから参照できます。これらの入力は、区切り文字、最大チャンク長、ドキュメント処理設定など、汎用的な処理パラメータに適しています。ユーザーはどのデータソースを選択しても、これらのフィールドに入力する必要があります。

+#### すべてのエントランス共通入力

-**作成方法**:グローバル入力の右側にある`+`ボタンをクリックして、任意のノードから参照できるフィールドを追加します。

-

-### サポートされる入力フィールドタイプ

+

-ナレッジパイプラインは7種類の入力変数をサポートします:

+全ノードから参照できるグローバル共有入力です。チャンク区切りや最大長等、汎用パラメータの入力に適します。

-

+これは各データソースや下流ノードに固有です。該当データソース選択時のみ入力対象となります(例:異なるURLの指定等)。

-#### すべてのエントランス用のグローバル入力

+**作成方法**:データソース横の`+`ボタンからそのソース専用フィールドを追加できます。選択したソースからのみアクセス可能です。

-

+

-グローバル共有入力はすべてのノードから参照できます。これらの入力は、区切り文字、最大チャンク長、ドキュメント処理設定など、汎用的な処理パラメータに適しています。ユーザーはどのデータソースを選択しても、これらのフィールドに入力する必要があります。

+#### すべてのエントランス共通入力

-**作成方法**:グローバル入力の右側にある`+`ボタンをクリックして、任意のノードから参照できるフィールドを追加します。

-

-### サポートされる入力フィールドタイプ

+

-ナレッジパイプラインは7種類の入力変数をサポートします:

+全ノードから参照できるグローバル共有入力です。チャンク区切りや最大長等、汎用パラメータの入力に適します。

-

-

-

-

-

-

-**パラメータ設定**

-

-| パラメータ | 種類 | 説明 |

-|-----------------------|--------|------------------------------------------------|

-| URL | 必須 | 対象Webページのアドレス |

-| 制限 | 必須 | クロールする最大ページ数 |

-| サブページクロール | 任意 | リンク先ページもクロールするか |

-| 最大深度 | 任意 | 開始URLからクロールする階層の深さ |

-| 除外パス | 任意 | クロール対象から除外したいURLパターン |

-| 限定パス | 任意 | 指定したパスのみクロール |

-| Extractor | 任意 | データ処理方式の選択 |

-| 主要コンテンツのみ抽出 | 任意 | ページの主要テキストやメディアのみ抽出 |

-

-

-

+

+

---

@@ -193,43 +179,41 @@ Google Drive、Dropbox、OneDriveなどのクラウドストレージサービ

### ドキュメントプロセッサ

-PDF、XLSX、DOCXなど多様な形式のドキュメントが存在しますが、LLMはこれらをそのまま扱えません。そのため、抽出器(Extractor)が各種ファイルを解析・変換し、LLMが扱いやすい形式に変換します。

+PDF, XLSX, DOCXなど多様な形式のドキュメントが存在しますが、LLMはこれらをそのまま扱えません。そのため、抽出器(Extractor)が各種ファイルを解析・変換し、LLMが扱いやすい形式に変換します。

Difyのドキュメント抽出器、あるいはMarketplaceから「Dify Extractor」「Unstructured」等のツールを選択できます。

+

+

+

+ **パラメータ設定**

+

+ | パラメータ | 種類 | 説明 |

+ |-----------------------|--------|------------------------------------------------|

+ | URL | 必須 | 対象Webページのアドレス |

+ | 制限 | 必須 | クロールする最大ページ数 |

+ | サブページクロール | 任意 | リンク先ページもクロールするか |

+ | 最大深度 | 任意 | 開始URLからクロールする階層の深さ |

+ | 除外パス | 任意 | クロール対象から除外したいURLパターン |

+ | 限定パス | 任意 | 指定したパスのみクロール |

+ | Extractor | 任意 | データ抽出方式の選択 |

+ | 主要コンテンツのみ抽出 | 任意 | ページの主要テキストやメディアのみ抽出 |

+

-

+

-

-

-

-

-

-[Unstructured](https://marketplace-staging.dify.dev/plugins/langgenius/unstructured)は、高度なカスタマイズ可能性を備えた抽出戦略でドキュメントを機械可読形式へ変換します。抽出戦略(auto、hi_res、fast、OCR-only)や分割方法(by_title、by_page、by_similarity)に柔軟に対応。要素ごとの座標や信頼度、レイアウトなどリッチなメタデータも出力し、企業のドキュメントワークフローや混合タイプファイルの精密な処理に適しています。

-

-

-

-

+

+

+

+

+ [Unstructured](https://marketplace.dify.ai/plugins/langgenius/unstructured)は、高度なカスタマイズ可能性を備えた抽出戦略でドキュメントを機械可読形式へ変換します。

+ 抽出戦略(auto, hi_res, fast, OCR-only)や分割方法(by_title, by_page, by_similarity)に柔軟に対応。要素ごとの座標や信頼度、レイアウトなどリッチなメタデータも出力し、企業のドキュメントワークフローや混合タイプファイルの精密な処理に適しています。

+

+  +

+

コスト効率 | 埋め込みモデル

キーワード数 | ベクトル検索

全文検索

ハイブリッド検索

逆引きインデックス | -| 親子モード | 高品質のみ | 埋め込みモデル | ベクトル検索

全文検索

ハイブリッド検索 | -| Q&Aモード | 高品質のみ | 埋め込みモデル | ベクトル検索

全文検索

ハイブリッド検索 | +| 汎用モード | 高品質

コスト効率 | 埋め込みモデル

キーワード数 | ベクトル

全文

ハイブリッド検索

逆引きインデックス | +| 親子モード | 高品質のみ | 埋め込みモデル | ベクトル

全文

ハイブリッド検索 | +| Q&Aモード | 高品質のみ | 埋め込みモデル | ベクトル

全文

ハイブリッド検索 | --- ## ステップ4:ユーザー入力フォームの作成 -ユーザー入力フォームは、パイプラインを効果的に実行するために必要な初期情報を収集するために不可欠です。ワークフローの[ユーザー入力ノード](/ja/use-dify/nodes/user-input)と同様に、このフォームはユーザーから必要な詳細情報(アップロードするファイル、ドキュメント処理の特定パラメータなど)を収集し、パイプラインが正確な結果を提供するために必要なすべての情報を確保します。 - -これにより、さまざまなユースケースシナリオに特化した入力フォームを作成でき、さまざまなデータソースやドキュメント処理ステップに対するパイプラインの柔軟性と使いやすさを向上できます。 +ユーザー入力フォームは、パイプライン実行時に必要な初期情報をユーザーから収集します。ワークフローの開始ノードと同様に、必要な设置情報(アップロードファイル、特定パラメータなど)を収集し、パイプラインの柔軟性・利便性を高めます。 ### フォームの作成方法 -ユーザー入力フィールドを作成する方法は2つあります: +1. **パイプライン構築UI** + - 「入力フィールド」をクリックして作成・設定を開始 +  -1. **パイプライン構築インターフェース**\ - **入力フィールド**をクリックして入力フォームの作成と設定を開始します。\ -

-2. **ノードパラメータパネル**\

- ノードを選択します。次に、右側パネルのパラメータ入力で、新しい入力項目のために「+ ユーザー入力を作成」をクリックします。新しい入力項目は入力フィールドにも収集されます。

-2. **ノードパラメータパネル**\

- ノードを選択します。次に、右側パネルのパラメータ入力で、新しい入力項目のために「+ ユーザー入力を作成」をクリックします。新しい入力項目は入力フィールドにも収集されます。 +2. **ノードパラメータパネル**

+ - ノード選択後、パラメータ入力欄の「+ ユーザー入力を作成」をクリック

+

### ユーザー入力フィールドの追加

-#### 各エントランス固有の入力

-

-

+#### 各エントランス固有入力

-これらの入力は各データソースとその下流ノードに固有です。ユーザーは対応するデータソースを選択した場合にのみ、これらのフィールドに入力する必要があります(例:異なるデータソース用の異なるURL)。

+

-**作成方法**:データソースの右側にある`+`ボタンをクリックして、その特定のデータソース用のフィールドを追加します。これらのフィールドは、そのデータソースとその後続の接続ノードからのみ参照できます。

+2. **ノードパラメータパネル**

+ - ノード選択後、パラメータ入力欄の「+ ユーザー入力を作成」をクリック

+

### ユーザー入力フィールドの追加

-#### 各エントランス固有の入力

-

-

+#### 各エントランス固有入力

-これらの入力は各データソースとその下流ノードに固有です。ユーザーは対応するデータソースを選択した場合にのみ、これらのフィールドに入力する必要があります(例:異なるデータソース用の異なるURL)。

+

-**作成方法**:データソースの右側にある`+`ボタンをクリックして、その特定のデータソース用のフィールドを追加します。これらのフィールドは、そのデータソースとその後続の接続ノードからのみ参照できます。 +これは各データソースや下流ノードに固有です。該当データソース選択時のみ入力対象となります(例:異なるURLの指定等)。

-#### すべてのエントランス用のグローバル入力

+**作成方法**:データソース横の`+`ボタンからそのソース専用フィールドを追加できます。選択したソースからのみアクセス可能です。

-

+

-グローバル共有入力はすべてのノードから参照できます。これらの入力は、区切り文字、最大チャンク長、ドキュメント処理設定など、汎用的な処理パラメータに適しています。ユーザーはどのデータソースを選択しても、これらのフィールドに入力する必要があります。

+#### すべてのエントランス共通入力

-**作成方法**:グローバル入力の右側にある`+`ボタンをクリックして、任意のノードから参照できるフィールドを追加します。

-

-### サポートされる入力フィールドタイプ

+

-ナレッジパイプラインは7種類の入力変数をサポートします:

+全ノードから参照できるグローバル共有入力です。チャンク区切りや最大長等、汎用パラメータの入力に適します。

-

+これは各データソースや下流ノードに固有です。該当データソース選択時のみ入力対象となります(例:異なるURLの指定等)。

-#### すべてのエントランス用のグローバル入力

+**作成方法**:データソース横の`+`ボタンからそのソース専用フィールドを追加できます。選択したソースからのみアクセス可能です。

-

+

-グローバル共有入力はすべてのノードから参照できます。これらの入力は、区切り文字、最大チャンク長、ドキュメント処理設定など、汎用的な処理パラメータに適しています。ユーザーはどのデータソースを選択しても、これらのフィールドに入力する必要があります。

+#### すべてのエントランス共通入力

-**作成方法**:グローバル入力の右側にある`+`ボタンをクリックして、任意のノードから参照できるフィールドを追加します。

-

-### サポートされる入力フィールドタイプ

+

-ナレッジパイプラインは7種類の入力変数をサポートします:

+全ノードから参照できるグローバル共有入力です。チャンク区切りや最大長等、汎用パラメータの入力に適します。

-

-

-サポートされるフィールドタイプの詳細については、[ユーザー入力](/ja/use-dify/nodes/user-input)をご参照ください。

-

+

+詳細は[入力フィールドのドキュメント](/ja/use-dify/nodes/user-input)をご参照ください。

+

### フィールド設定オプション

-すべての入力フィールドタイプには、必須、任意、および追加設定があります。適切なオプションをチェックしてフィールドを必須にするかどうかを設定できます。

+全入力フィールドには必須/任意および追加設定があります。適切なチェックで必須化等を指定します。

| 設定 | 名称 | 説明 | 例 |

|-------------------|---------------|--------------------------------------------------|--------------------------|

-| 必須設定 | 変数名 | 内部システム識別子、通常は英語とアンダースコアで命名 | `user_email` |

-| | 表示名 | インターフェース表示名、通常は簡潔で読みやすいテキスト | ユーザーメール |

-| タイプ固有設定 | | 異なるフィールドタイプの特別な要件 | テキストフィールドの最大長100文字 |

-| 追加設定 | デフォルト値 | ユーザーが入力していない場合のデフォルト値 | 数値フィールドのデフォルトは0、テキストフィールドのデフォルトは空 |

-| | プレースホルダー | 入力ボックスが空のときに表示されるヒントテキスト | 「メールアドレスを入力してください」 |

-| | ツールチップ | ユーザー入力をガイドする説明テキスト、通常はマウスホバー時に表示 | 「有効なメールアドレスを入力してください」 |

-| 特殊任意設定 | | 異なるフィールドタイプに基づく追加設定オプション | メール形式のバリデーション |

+| 必須設定 | 変数名 | 内部識別用(英数字・アンダースコア推奨) | `user_email` |

+| | 表示名 | UI上に表示される名称 | ユーザーメール |

+| タイプ固有設定 | | タイプごとの条件 | テキストの最大長制限等 |

+| 追加設定 | デフォルト値 | 未入力時の既定値 | 数値は0、テキストは空文字 |

+| | プレースホルダー | 入力欄が空のときのヒント表示 | 「メールアドレス入力」 |

+| | ツールチップ | 補足説明(マウスホバー時表示) | 「有効なメールアドレスを…」 |

+| 特殊任意設定 | | タイプごとの特殊バリデーション | メール形式チェック等 |

-設定完了後、右上のプレビューボタンをクリックしてフォームプレビューインターフェースを閲覧できます。フィールドのグループ化をドラッグして調整できます。感嘆符が表示された場合は、移動後に参照が無効になっていることを示します。

+設定後、右上のプレビューボタンで実際のフォーム動作確認やフィールド並び替えが可能です。「!」マーク表示時は参照無効を示します。

-

+

---

@@ -523,50 +493,40 @@ Q&AモードはHQ(高品質)モードのみ対応です。

-デフォルトのナレッジベース名は「Untitled+番号」、権限は「自分のみ」、アイコンはオレンジ色の書籍です。DSLファイルからインポートした場合は保存されたアイコンが使用されます。

+デフォルトのナレッジベース名は「Untitled+番号」、権限は「自分のみ」、アイコンはオレンジ色の書籍です。DSLファイルからインポートした場合は元のアイコンが適用されます。

-左パネルの**設定**をクリックし、以下の情報を入力してください:

-

-- **名前とアイコン**\

- ナレッジベースの名前を決定します。\

- 絵文字を選択、画像をアップロード、または画像URLを貼り付けてこのナレッジベースのアイコンとして設定できます。

-- **ナレッジベース説明**\

- ナレッジベースの簡単な説明を入力してください。これによりAIがデータをより適切に理解し検索できるようになります。空のままにすると、Difyはデフォルトの検索戦略を適用します。

-- **権限**\

- ドロップダウンメニューから適切なアクセス権限を選択してください。

+左パネルの「設定」をクリックし、以下を設定してください。

+- **名前とアイコン**

+ ナレッジベース名を決定します。絵文字選択、画像アップロード、画像URLによるアイコン設定が可能です。

+- **ナレッジベース説明**

+ 簡単な説明を記入してください。AIがデータをより適切に理解し検索できるようになります。未入力の場合はDifyのデフォルト検索戦略が使われます。

+- **権限**

+ ドロップダウンから適切なアクセス権限を選択してください。

---

## ステップ6:テスト

-いよいよ最終工程です!これがナレッジパイプラインオーケストレーションの最終ステップです。

-

-オーケストレーションが完了したら、まずすべての設定を検証する必要があります。次に、いくつかの実行テストを行い、すべての設定を確認します。最後に、ナレッジパイプラインを公開します。

-

-### 設定完全性チェック

-

-テスト前に、設定の不備によるテスト失敗を避けるため、設定の完全性をチェックすることをお勧めします。

+いよいよ最終工程です!

-右上のチェックリストボタンをクリックすると、システムが不足している部分を表示します。

+設定が整ったら、まずは全設定の完全性チェックを行いましょう。チェックは右上のチェックリストボタンで行え、不足項目があると通知されます。

-

+

-すべての設定が完了したら、テスト実行を通じてナレッジベースパイプラインの動作をプレビューし、すべての設定が正確であることを確認してから、公開に進みます。

+全設定完了後、テスト実行でパイプライン全体の動作確認を行い、不備がないことを確認した上で公開します。

### テスト実行

-

-

-1. **テスト開始**:右上の「テスト実行」ボタンをクリック

-2. **テストファイルインポート**:右側にポップアップするデータソースウィンドウでファイルをインポート

-

-

- **重要:** デバッグと観察を容易にするため、テスト実行ごとに1ファイルのみアップロード可能です。

-

+

-3. **パラメータ入力**:インポート成功後、先に設定したユーザー入力フォームに従って対応するパラメータを入力

-4. **テスト実行開始**:次のステップをクリックしてパイプライン全体のテストを開始

+1. **テスト開始**:**テスト実行**をクリック

+2. **テストファイルインポート**:右側ウィンドウからファイル選択

+

+ **注意:** デバッグのため、1回につき1ファイルのみアップロード可能です。

+

+3. **パラメータ入力**:設定した入力フォームに従い必要なパラメータを入力

+4. **パイプライン実行**:**次へ**をクリックしテスト開始

-テスト中は、[履歴ログ](/ja/use-dify/monitor/logs)(タイムスタンプ、実行ステータス、入出力サマリーを含むすべての実行記録を追跡)と[変数インスペクタ](/ja/use-dify/debug/variable-inspect)(各ノードの入出力データを表示し、問題の特定とデータフローの検証を支援するダッシュボード)にアクセスして、効率的なトラブルシューティングとエラー修正を行えます。

+テスト時は、[履歴ログ](/ja/use-dify/monitor/logs)(実行記録の確認)や[変数インスペクタ](/ja/use-dify/debug/variable-inspect)(ノード入出力内容の可視化)が問題特定に役立ちます。

\ No newline at end of file

diff --git a/ja/use-dify/knowledge/knowledge-request-rate-limit.mdx b/ja/use-dify/knowledge/knowledge-request-rate-limit.mdx

index ae1f68e2e..3d08a1587 100644

--- a/ja/use-dify/knowledge/knowledge-request-rate-limit.mdx

+++ b/ja/use-dify/knowledge/knowledge-request-rate-limit.mdx

@@ -6,9 +6,11 @@ tag: "CLOUD"

⚠️ このドキュメントはAIによって自動翻訳されています。不正確な部分がある場合は、[英語版](/en/use-dify/knowledge/knowledge-request-rate-limit)を参照してください。

+Dify クラウドサービスの安定性を維持し、すべてのユーザーにより良いナレッジベース利用体験を向上させるため、**2025 年 2 月 24 日** よりナレッジリクエストレート頻度制限(Knowledge Request Rate Limit)を導入します。

+

## ナレッジベースの要求頻度制限とは?

-「Dify Cloud」では、ナレッジリクエスト頻度制限とは、ワークスペースが1分間にナレッジベース内で実行できる操作の最大回数を指します。これには、データセットの作成、ドキュメントの管理、アプリやワークフローでのクエリ実行などが含まれます。

+ナレッジリクエスト頻度制限とは、1つのワークスペースがナレッジベースに対して1分間に実行できる最大リクエスト数のことです。この操作には、データセットの作成、ドキュメントの管理、アプリケーションやワークフローにおけるナレッジベースのクエリなどが含まれます。

## サブスクリプションバージョンの制限値

diff --git a/ja/use-dify/knowledge/manage-knowledge/maintain-knowledge-documents.mdx b/ja/use-dify/knowledge/manage-knowledge/maintain-knowledge-documents.mdx

index 9574965c3..ec9a20284 100644

--- a/ja/use-dify/knowledge/manage-knowledge/maintain-knowledge-documents.mdx

+++ b/ja/use-dify/knowledge/manage-knowledge/maintain-knowledge-documents.mdx

@@ -7,9 +7,7 @@ sidebarTitle: コンテンツの管理

## ドキュメントの管理

-ナレッジベース内では、インポートされたすべてのアイテム(ローカルファイル、Notion ページ、またはウェブページなど)がドキュメントとして扱われます。

-

-ドキュメント一覧から、すべてのドキュメントを閲覧・管理し、ナレッジの正確性、関連性、最新性を維持できます。

+ナレッジベース内では、インポートされたすべてのアイテム(ローカルファイル、Notion ページ、またはウェブページなど)がドキュメントとして扱われます。ドキュメント一覧から、すべてのドキュメントを閲覧・管理し、ナレッジの正確性、関連性、最新性を維持できます。

画面上部のナレッジベース名をクリックすると、他のナレッジベースへ素早く切り替えできます。

@@ -22,31 +20,29 @@ sidebarTitle: コンテンツの管理

| 追加 | 新しいドキュメントをインポートします。|

| チャンク設定の変更 | ドキュメントのチャンク設定を変更します(チャンク構造を除く)。各ドキュメントには個別のチャンク設定を持たせることができますが、チャンク構造はナレッジベース全体で共通であり、一度設定すると変更できません。 |

| 削除 | ドキュメントを完全に削除します。**削除は元に戻せません。**|

-| 有効/無効 | 一時的にドキュメントを検索対象に含める/除外します。Dify Cloud では、一定期間更新または検索に使用されていないドキュメントは、自動的に無効化されパフォーマンスが最適化されます。

非アクティブ期間はプランごとに異なります: |

+| 有効/無効 | 一時的にドキュメントを検索対象に含める/除外します。Dify Cloud では、一定期間更新または検索に使用されていないドキュメントは、自動的に無効化されパフォーマンスが最適化されます。

非アクティブ期間はプランごとに異なります: |

| アーカイブ/アーカイブ解除 | 検索には不要だが保持しておきたいドキュメントをアーカイブします。アーカイブ済みドキュメントは読み取り専用で、いつでもアーカイブ解除可能です。|

| 編集 | ドキュメント内のチャンクを編集して、コンテンツを修正します。詳細は [チャンクの管理](#チャンクの管理) を参照してください。|

| 名前を変更 | ドキュメントの名前を変更します。|

## チャンクの管理

-チャンク設定に基づき、すべてのドキュメントは検索の基本単位であるコンテンツチャンクに分割されます。

-

-各ドキュメント内のチャンク一覧からそれらを閲覧・管理し、検索の効率と精度を向上させることができます。

+チャンク設定に基づき、すべてのドキュメントは検索の基本単位であるコンテンツチャンクに分割されます。各ドキュメント内のチャンク一覧からそれらを閲覧・管理し、検索の効率と精度を最適化できます。

- 左上のドキュメント名をクリックすると、別のドキュメントへ素早く切り替えられます。

+ 左上のドキュメント名をクリックして、別のドキュメントに素早く切り替えられます。

| 操作 | 説明 |

|:-------- |:---------------------|

-| 追加 | 新しいチャンクを1つまたは複数まとめて追加します。

親子分割モードのドキュメントでは、親チャンクと子チャンクの両方を追加可能です。「チャンクを追加」は Dify Cloud の有料機能です。利用するには [Professional または Team プラン](https://dify.ai/pricing) へのアップグレードが必要です。 |

+| 追加 | 新しいチャンクを1つまたは複数まとめて追加します。

親子分割モード(階層分割モード)のドキュメントでは、親チャンクと子チャンクの両方を追加可能です。「チャンクを追加」は有料機能です。Dify Cloud で利用するには [Professional または Team プラン](https://dify.ai/jp/pricing) へのアップグレードが必要です。 |

| 削除 | チャンクを完全に削除します。**削除は元に戻せません。**|

| 有効/無効 | 一時的にチャンクを検索対象に含める/除外します。無効化されたチャンクは編集できません。|

-| 編集 | チャンクの内容を修正します。編集されたチャンクには **Edited** マークが付きます。

親子分割モードのドキュメントでは:

1つのチャンクにつき最大10個のキーワードを設定可能です。| -| 画像添付ファイルの追加/削除 | ドキュメントから抽出された画像を削除したり、対応するチャンク内に新しい画像をアップロードしたりできます。

抽出された画像のURLはチャンクテキスト内に残りますが、テキストをきれいに保つためにこれらのURLを安全に削除できます。抽出された画像には影響しません。各チャンクには最大10枚まで画像の添付が可能で、検索時にチャンクと一緒に返されます。この制限を超える画像は抽出されません。

セルフホスティング環境では、環境変数 `SINGLE_CHUNK_ATTACHMENT_LIMIT` でこの制限を調整できます。 マルチモーダル埋め込みモデル(**Vision** アイコン付き)を選択すると、抽出された画像も埋め込み・インデックス化され、検索に利用されます。 |

+| 編集 | チャンクの内容を修正します。編集されたチャンクは **「編集済み」** と表示されます。

親子分割モード(階層分割モード)のドキュメントでは:ドキュメント内の画像が添付ファイルとして抽出される場合、そのURLはチャンクテキスト内に残ります。これらのURLを削除しても、抽出された画像の添付ファイルには影響しません。 |

+| キーワードの追加/編集/削除 | 経済的インデックス方式を使用するナレッジベースでは、各チャンクに対してキーワードを追加・編集して検索精度を向上させることができます。

1つのチャンクにつき最大10個のキーワードを設定可能です。 | +| 画像の追加/削除 | ドキュメントから抽出された画像を削除したり、対応するチャンク内に新しい画像をアップロードしたりできます。

画像の添付ファイルとチャンクは独立して編集でき、互いに影響しません。 各チャンクには最大10枚まで画像の添付が可能で、検索時に一緒に返されます。これを超える画像は抽出されません。

セルフホスティング環境では、環境変数 `SINGLE_CHUNK_ATTACHMENT_LIMIT` を変更してこの制限を調整できます。 クロスモーダル検索(テキストと画像の両方を意味的関連性に基づいて検索)を有効にするには、ナレッジベースに多モーダル埋め込みモデル(**Vision** アイコン付き)を選択してください。画像の添付ファイルは埋め込み・インデックス化され、検索に利用されます。 |

## ベストプラクティス

@@ -64,7 +60,7 @@ sidebarTitle: コンテンツの管理

### 子チャンクを親チャンクの検索フックとして使用

-親子分割モードで分割されたドキュメントでは、システムは子チャンクを検索し、結果として親チャンクを返します。子チャンクを編集しても親チャンクは更新されないため、子チャンクを親チャンクの **セマンティックタグ(意味的タグ)** や **検索ヒント** として活用できます。

+親子分割モード(階層分割モード)で分割されたドキュメントでは、システムは子チャンクを検索し、結果として親チャンクを返します。子チャンクを編集しても親チャンクは更新されないため、子チャンクを親チャンクの **セマンティックタグ(意味的タグ)** や **検索ヒント** として活用できます。

そのためには、子チャンクを **キーワード**・**要約**・**ユーザーの一般的な質問** のいずれかに書き換えることを推奨します。

たとえば、親チャンクが *返品ポリシー* 全体を扱う場合、子チャンクを次のように設定できます:

@@ -73,4 +69,4 @@ sidebarTitle: コンテンツの管理

- 「返金期間はどのくらいですか?」

-- 「返品時の送料はかかりますか?」

\ No newline at end of file

+- 「返品時の送料はかかりますか?」

diff --git a/ja/use-dify/monitor/logs.mdx b/ja/use-dify/monitor/logs.mdx

index cca606395..d0bf5ec81 100644

--- a/ja/use-dify/monitor/logs.mdx

+++ b/ja/use-dify/monitor/logs.mdx

@@ -53,17 +53,15 @@ AIが不適切な応答をしたり、ユーザーの意図を理解できなか

**フィードバック分析**

一般的な苦情パターン、成功したやり取りタイプ、改善が必要な分野を特定できます。

-## ログの保持期間

+## データ保持

アプリケーションが現地のデータプライバシー規制に準拠していることを確認してください。プライバシーポリシーを公開し、必要に応じ

- - **Sandbox**:ログは30日間保持されます。

-

- - **Professional & Team**:アクティブなサブスクリプション期間中はログ保持期間が無制限です。

-

- - **セルフホスト**:デフォルトで無制限ですが、環境変数 `WORKFLOW_LOG_CLEANUP_ENABLED`、`WORKFLOW_LOG_RETENTION_DAYS`、`WORKFLOW_LOG_CLEANUP_BATCH_SIZE` で設定可能です。

+**無料プラン:** ログは30日間保持されます

+**有料プラン:** プラン階層に基づく延長保持

+**セルフホスト:** 設定可能な保持ポリシー

## ログを使ったアプリケーションの改善

diff --git a/ja/use-dify/nodes/human-input.mdx b/ja/use-dify/nodes/human-input.mdx

new file mode 100644

index 000000000..a545ed556

--- /dev/null

+++ b/ja/use-dify/nodes/human-input.mdx

@@ -0,0 +1,83 @@

+---

+title: 人間の入力

+description: ワークフローを一時停止して、人間の入力、レビュー、または決定を要求します

+icon: user-magnifying-glass

+---

+

+ ⚠️ このドキュメントはAIによって自動翻訳されています。不正確な部分がある場合は、[英語版](/en/use-dify/nodes/human-input)を参照してください。

+

+人間の入力ノードは、実行が続行される前に人間の入力を要求するため、重要なポイントでワークフローを一時停止します。

+

+実行がこのノードに到達すると、カスタマイズ可能なリクエストフォームが特定のチャネルを通じて配信されます。受信者は入力を提供し、データをレビューし、ワークフローの進行方法を決定する事前定義されたアクション(`Approve`や`Regenerate`など)から選択できます。

+

+人間の入力を重要な場所に直接埋め込むことで、**自動化された効率性と人間の監視のバランス**を取ることができます。

+

+ +

+## 設定

+

+ノードが人間の入力を要求し処理する方法を定義するために、以下を設定します:

+

+- **配信方法**:リクエストフォームが受信者に届く方法。

+

+- **フォーム内容**:受信者が見る情報と入力できる内容。

+

+- **ユーザーアクション**:受信者が取れるアクションと、それに応じてワークフローがどのように進行するか。

+

+- **タイムアウト戦略**:設定された時間内に誰も応答しない場合の対応。

+

+### 配信方法

+

+リクエストフォームが配信されるチャネルを選択します。現在利用可能な方法:

+

+- **Webアプリ**:現在のユーザーが応答できるように、Webアプリインターフェースに直接リクエストフォームを表示します。

+

+- **メール**:1人以上の受信者にリクエストフォームのリンクを含むメールを直接送信します。

+

+

+

+## 設定

+

+ノードが人間の入力を要求し処理する方法を定義するために、以下を設定します:

+

+- **配信方法**:リクエストフォームが受信者に届く方法。

+

+- **フォーム内容**:受信者が見る情報と入力できる内容。

+

+- **ユーザーアクション**:受信者が取れるアクションと、それに応じてワークフローがどのように進行するか。

+

+- **タイムアウト戦略**:設定された時間内に誰も応答しない場合の対応。

+

+### 配信方法

+

+リクエストフォームが配信されるチャネルを選択します。現在利用可能な方法:

+

+- **Webアプリ**:現在のユーザーが応答できるように、Webアプリインターフェースに直接リクエストフォームを表示します。

+

+- **メール**:1人以上の受信者にリクエストフォームのリンクを含むメールを直接送信します。

+

+

+ 配信方法に関係なく、最初の応答後にリクエストは閉じられます。

+

+

+### フォーム内容

+

+リクエストフォームに表示される内容をカスタマイズします:

+

+- **Markdown**構文を使用してコンテンツをフォーマットおよび構造化します

+

+- 利用可能な**変数**を参照して動的データを表示します

+

+

+ 推論モデルの`text`出力変数を参照すると、フォームには最終的な回答とともにモデルの思考プロセスが表示されます。

+

+ 回答のみを表示するには、対応するLLMノードで**推論タグ分離を有効にする**をオンにしてください。

+

+

+- 受信者が入力や編集を行える対話型の**入力フィールド**を追加します

+

+

+ 入力フィールドは、受信者が編集できる変数または静的コンテンツで事前入力できます。

+

+ 各入力フィールドは、下流のノードで使用するための出力変数になります。

+

+

+### ユーザーアクション

+

+受信者がクリックできる決定ボタンを定義します。

+

+各ボタンは人間の入力ノードから対応する分岐を作成し、行われた決定に基づいて実行をルーティングします。

+

+例えば、`Post`分岐はコンテンツの公開をトリガーするノードにつながり、`Regenerate`分岐はコンテンツを修正するためにLLMノードにループバックする場合があります。

+

+

+ プリセットのボタンスタイルを使用して、アクションを視覚的に区別します。

+

+ 例えば、`Approve`のような主要なアクションには目立つスタイルを使用し、二次的なオプションにはより控えめなスタイルを使用します。

+

+

+### タイムアウト戦略

+

+指定された期間内に誰も応答しない場合にワークフローがどのように進行するかを決定するタイムアウト戦略を設定します。

+

+- **タイムアウト期間**:タイムアウトになるまでの待機時間(時間または日単位)。

+

+- **タイムアウトパス**:タイムアウト期間内に誰も応答しない場合に従う分岐。通知またはデフォルトの決定につながる場合があります。

\ No newline at end of file

diff --git a/ja/use-dify/nodes/ifelse.mdx b/ja/use-dify/nodes/ifelse.mdx

index 51f7c387f..c864b4ecc 100644

--- a/ja/use-dify/nodes/ifelse.mdx

+++ b/ja/use-dify/nodes/ifelse.mdx

@@ -6,6 +6,7 @@ icon: "code-branch"

⚠️ このドキュメントはAIによって自動翻訳されています。不正確な部分がある場合は、[英語版](/en/use-dify/nodes/ifelse)を参照してください。

+

If-Elseノードは、定義した条件に基づいて実行を異なるパスにルーティングすることで、ワークフローに意思決定ロジックを追加します。変数を評価し、ワークフローが従うべき分岐を決定します。

@@ -28,11 +29,11 @@ If-Elseノードは、定義した条件に基づいて実行を異なるパス

- **Contains** / **Not contains** - 値が特定の単語やフレーズを含むかチェック

+ **Contains** / **Not contains** - テキストが特定の単語やフレーズを含むかチェック

**Starts with** / **Ends with** - パターンマッチングのためにテキストの始まりや終わりをテスト

- **Is** / **Is not** - 完全値マッチング

+ **Is** / **Is not** - 正確なテキスト比較のための完全値マッチング

@@ -58,6 +59,18 @@ If-Elseノードは、定義した条件に基づいて実行を異なるパス

## 変数参照

-条件で以前のワークフローノードからの任意の変数を参照します。変数は、ユーザー入力、LLMレスポンス、API呼び出し、または他のワークフローノード出力から取得できます。

+条件で以前のワークフローノードからの任意の変数を参照します。変数は、ユーザー入力、大規模言語モデルのレスポンス、API呼び出し、または他のワークフローノード出力から取得できます。

+

+変数セレクターを使用して利か、`{{variable_name}}`構文を使用して変数名を直接入力します。

+

+## 共通パターン

+

+**コンテンツルーティング** - カテゴリ、言語、または複雑さに基づいて、異なるタイプのコンテンツを専用の処理ノードに振り分けます。

+

+**ユーザー役割管理** - ユーザー権限、サブスクリプションレベル、またはアカウントタイプに基づいて異なるワークフロー動作を実装します。

+

+**エラーハンドリング** - レスポンス状態コード、データ妥当性、または処理結果をチェックして、ワークフローを適切にルーティングします。

+

+**動的処理** - 入力特性、処理結果、または外部条件に基づいてワークフロー動作を調整します。

-変数セレクターを使用して利用可能な変数から選択するか、`{{variable_name}}`構文を使用して変数名を直接入力します。

\ No newline at end of file

+**マルチパスワークフロー** - アプリケーションのさまざまなシナリオやエッジケースを処理する洗練された分岐ロジックを作成します。

diff --git a/ja/use-dify/nodes/knowledge-retrieval.mdx b/ja/use-dify/nodes/knowledge-retrieval.mdx

index 3c73bd49d..a5730f298 100644

--- a/ja/use-dify/nodes/knowledge-retrieval.mdx

+++ b/ja/use-dify/nodes/knowledge-retrieval.mdx

@@ -7,50 +7,48 @@ icon: "database"

## はじめに

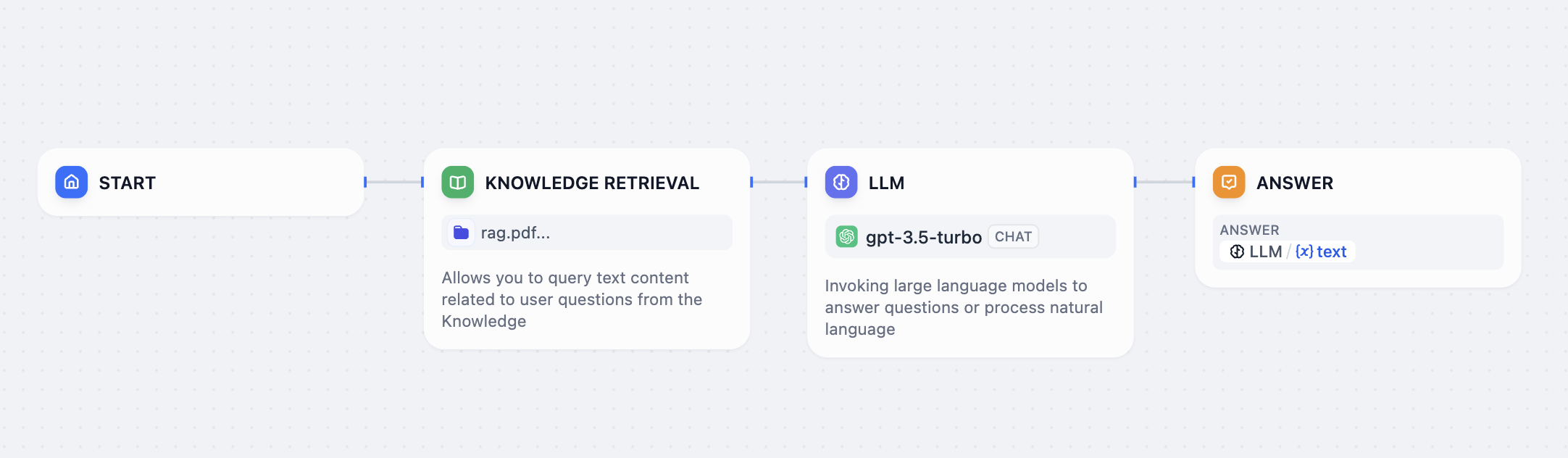

-知識検索ノードを使用すると、既存のナレッジベースをChatflowやワークフローに統合できます。このノードは指定されたナレッジからクエリに関連する情報を検索し、その結果を下流ノード(例:LLM)で利用できるコンテキスト情報として出力します。

+知識検索ノードを使用すると、既存のナレッジベースを Chatflow や Workflow に統合できます。

-以下はChatflowにおける知識検索ノードの利用例です:

+このノードは指定されたナレッジからクエリに関連する情報を検索し、その結果を下流ノード(例:LLM)で利用できるコンテキスト情報として出力します。

+

+以下は Chatflow における 知識検索ノード の利用例です:

1. **ユーザー入力** ノードがユーザーの質問を収集します。

-2. **知識検索** ノードが選択されたナレッジベースからユーザーの質問に関連するコンテンツを検索し、検索結果を出力します。

+2. **知識検索** ノードが選択されたナレッジベースから関連情報を検索し、結果を出力します。

-3. **LLM** ノードがユーザーの質問と検索されたナレッジの両方をもとに回答を生成します。

+3. **LLM** ノードがユーザー質問と検索結果の両方をもとに回答を生成します。

-4. **回答** ノードがLLMの応答をユーザーへ返します。

+4. **回答** ノードが LLM の出力をユーザーへ返します。

- 知識検索ノードを使用する前に、少なくとも1つのナレッジベースが利用可能であることを確認してください。ナレッジベースの作成方法については、[ナレッジ](/ja/use-dify/knowledge/readme#ナレッジの作成)を参照してください。

-

-

-

- Dify Cloudでは、知識検索の操作は契約プランに応じたレートリミットが適用されます。詳細は[ナレッジベースの要求頻度制限](/ja/use-dify/knowledge/knowledge-request-rate-limit)を参照してください。

-

+ 知識検索ノードを使用する前に、少なくとも1つの利用可能なナレッジベースが存在することを確認してください。

-## 設定

-

-知識検索ノードを正常に機能させるには、次の点を指定する必要があります:

+ ナレッジベースの作成方法については、[ナレッジ](/ja/use-dify/knowledge/readme#ナレッジの作成) を参照してください。

+

-- **何を**検索するか(クエリ)

+## 知識検索ノードの設定

-- **どこを**検索するか(ナレッジベース)

+知識検索ノードを正常に機能させるには、次の3点を指定する必要があります:

-- **どのように**検索結果を処理するか(ノードレベルの検索設定)

+- **何を検索するか**(クエリ)

+- **どこを検索するか**(ナレッジベース)

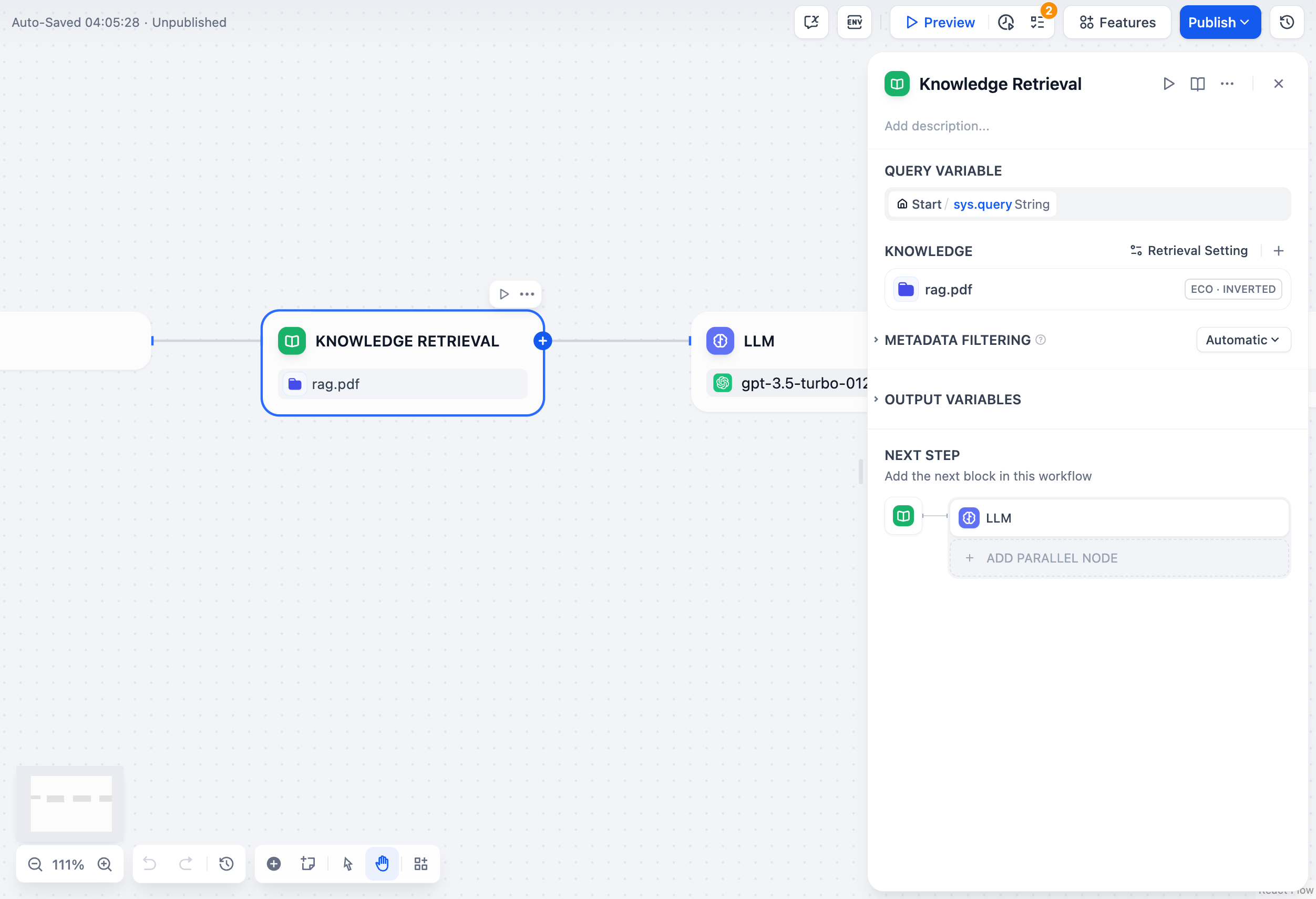

+- **どのように検索結果を処理するか**(ノードレベルの検索設定)

また、ドキュメントのメタデータを利用してフィルタベースの検索を有効化し、検索精度をさらに向上させることもできます。

### クエリの指定

-ノードが選択されたナレッジベースで検索するクエリ内容を指定します。

+ノードが選択されたナレッジベースで検索する対象を指定します。

-- **クエリテキスト**:テキスト変数を選択します。たとえば、Chatflowでは`userinput.query`を使用してユーザー入力を参照したり、ワークフローではカスタムのテキスト型ユーザー入力変数を使用したりできます。

+- **クエリテキスト**:テキスト変数を選択します。たとえば、Chatflow では `userinput.query`(ユーザー入力ノードの入力)を指定できます。Workflow ではテキスト型のユーザー入力変数を利用します。

-- **クエリ画像**:画像変数を選択します。例えば、ユーザー入力ノードを通じてユーザーがアップロードした画像を使用して画像検索を行います。画像サイズの上限は2 MBです。

+ **クエリ画像**:画像検索を行う場合は、ユーザー入力ノードを通じてアップロードされた画像など、画像変数を選択してください。最大サイズは 2 MB です。

- セルフホスト環境では、環境変数`ATTACHMENT_IMAGE_FILE_SIZE_LIMIT`を変更することで画像サイズ上限を調整できます。

+ 自己ホスティング環境では、環境変数 `ATTACHMENT_IMAGE_FILE_SIZE_LIMIT` を変更することで画像サイズ上限を調整できます。

@@ -61,76 +59,82 @@ icon: "database"

### 検索対象ナレッジベースの選択

-ノードでクエリ内容に関連するコンテンツを検索するためのナレッジベースを1つ以上追加します。

+ノードで検索対象とするナレッジベースを1つ以上追加します。

-複数のナレッジベースを追加した場合、まずすべてのナレッジベースから同時に検索を行い、その後[ノードレベルの検索設定](#ノードレベルの検索設定)に従って結果を統合・処理します。

+複数のナレッジベースを追加した場合、すべてのナレッジベースから同時に検索を行い、その結果を統合して[ノードレベルの検索設定](#ノードレベルの検索設定)に従って処理します。

- **Vision**アイコンが付いたナレッジベースはクロスモーダル検索をサポートしており、セマンティックな関連性に基づいてテキストと画像の両方を検索できます。

+ **Vision**アイコンが付いたナレッジベースは、セマンティックな関連性に基づいてテキストと画像の両方をクロスモーダルで検索できます。

- 追加したナレッジベースの横にある**編集**アイコンをクリックすると、知識検索ノード内で直接その設定を変更できます。

-

- これらの設定の詳細については、[ナレッジ設定の管理](/ja/use-dify/knowledge/manage-knowledge/introduction)をご覧ください。

+ ノード内で任意のナレッジベースの **編集** アイコンをクリックすると、直接その設定を変更できます。

+

+ 詳細な設定方法については、[ナレッジ設定の管理](/ja/use-dify/knowledge/manage-knowledge/introduction)をご覧ください。

### ノードレベルの検索設定

-ナレッジベースから取得した検索結果を、ノード内でどのように処理するかを微調整できます。

+ナレッジベースから取得した検索結果を、ノード内でどのように絞り込み・再ランク付けするかを調整できます。

- 検索設定には2つのレイヤーがあります—ナレッジベースレベルと知識検索ノードレベルです。

-

- これらは2つの連続したフィルターと考えてください:ナレッジベースの設定が最初の結果プールを決定し、ノードの設定がさらに結果を再ランク付けまたは絞り込みます。

+ 検索設定には2つのレイヤー(階層)があります。

+

+ ナレッジベースレベルの設定が最初の検索プールを決定し、ノードレベルの設定がその結果を再スコアリングまたは絞り込みします。

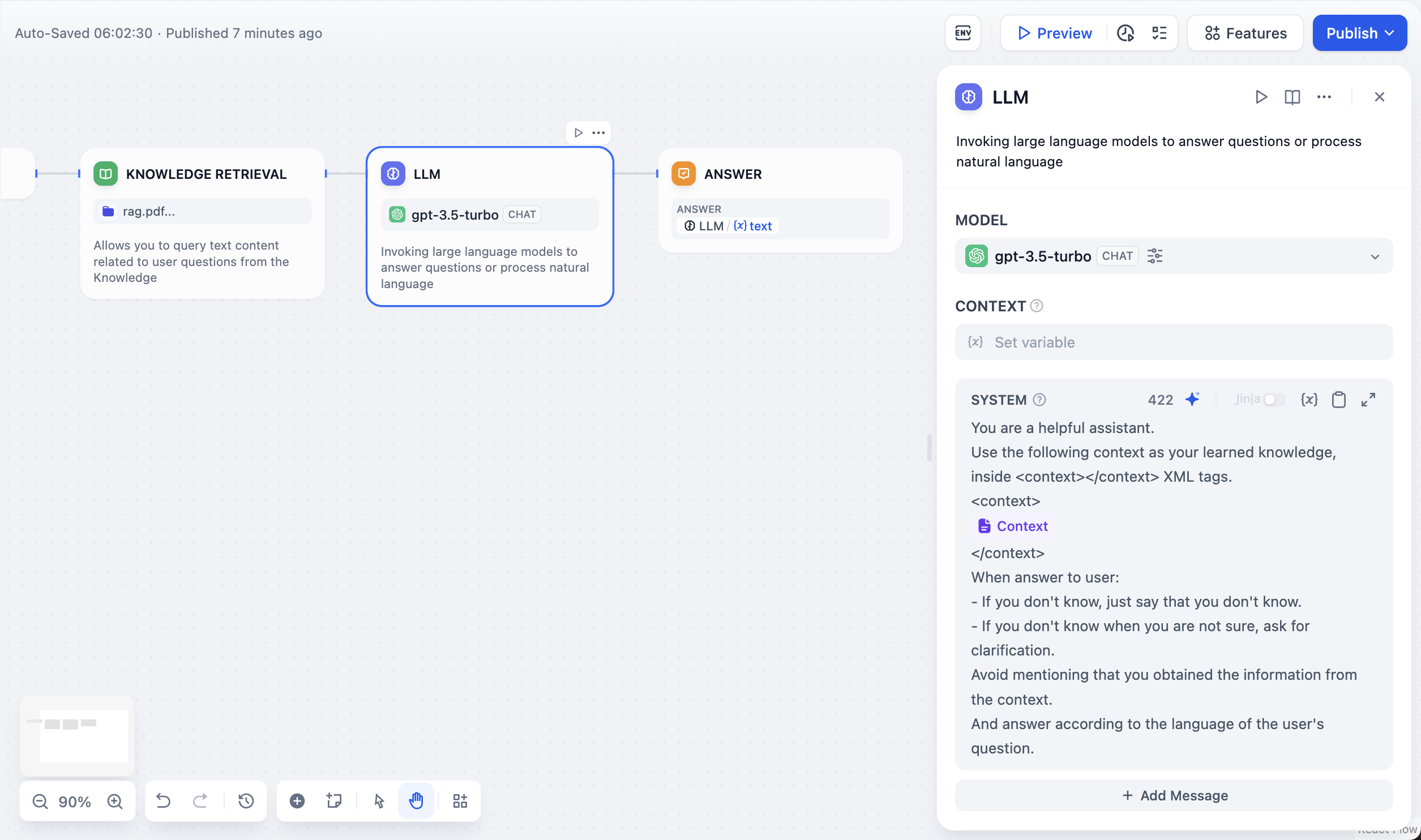

-- **Rerank設定**

+- **Rerank 設定**

- - **ウェイト設定**:再ランク付け時におけるセマンティック類似度とキーワード一致の相対的な比重です。セマンティックの比重を高くすると意味的関連性を重視し、キーワードの比重を高くすると正確な一致を重視します。

+ - **ウェイト設定**: 再ランク付け時におけるセマンティック類似度(意味の近さ)とキーワード一致の比重を調整します。セマンティックの比重を高くすると意味的関連性を重視し、キーワードの比重を高くすると正確な一致を重視します。

- **ウェイト設定**は、追加したナレッジベースがすべて高品質タイプである場合のみ利用できます。

+ **ウェイト設定** は、追加したナレッジベースがすべて「高品質」タイプである場合に利用できます。

- - **Rerankモデル**:クエリとの関連度に基づいてすべての結果を再スコアリング・並べ替えするRerankモデルです。

+ - **Rerank モデル**: クエリとの関連度に基づいてすべての検索結果を再スコアリング・並べ替えします。

+

+

+ 選択したナレッジベースの中にマルチモーダル対応のものが含まれている場合は、**Vision**アイコンが表示されたマルチモーダル再ランクモデルを選択してください。そうでない場合、検索された画像は再ランクおよび最終出力から除外されます。

+

+

+- **トップ K**: 再ランク後に返す最大件数を指定します。 Rerank モデルを選択している場合、この値はモデルが処理可能な最大入力サイズ(トークン上限)に応じて自動的に調整されます。

- マルチモーダルナレッジベースが追加されている場合は、マルチモーダルRerankモデル(**Vision**アイコン付き)も選択してください。そうでない場合、検索された画像は再ランク付けおよび最終出力から除外されます。

+ 選択したナレッジベースの中にマルチモーダル対応のものが含まれている場合は、**Vision**アイコンが表示されたマルチモーダル再ランクモデルを選択してください。そうでない場合、検索された画像は再ランクおよび最終出力から除外されます。

-- **トップK**:再ランク後に返す結果の最大件数です。Rerankモデルを選択している場合、この値はモデルの最大入力容量(モデルが一度に処理できるテキスト量)に基づいて自動的に調整されます。

-

-- **スコア閾値**:返される結果の最低類似度スコアです。この閾値未満の結果は除外されます。高めに設定すると関連性の厳密な検索が行われ、低めにするとより広範なマッチを含めることができます。

+- **スコア閾値**: 結果を返す際の最低スコア(類似度)を指定します。この閾値未満の結果は除外されます。高めに設定すると関連性の厳密な検索が行われ、低めにするとより広範なマッチを含めることができます。

### メタデータフィルタの有効化

-既存のドキュメントメタデータを使用して、ナレッジベース内の特定のドキュメントに検索を制限し、検索精度を向上させます。

-

-メタデータフィルタを有効にすると、知識検索ノードはナレッジベース全体を検索するのではなく、指定されたメタデータ条件に一致するドキュメントのみを検索します。これは、大規模で多様なナレッジベースでのターゲット検索に特に有用です。

+ナレッジベース内のドキュメントメタデータを利用して、特定の条件に合致するドキュメントのみを検索対象とすることができます。これにより、大規模または多様なナレッジベース内での検索精度が向上します。

- ドキュメントメタデータの作成と管理については、[メタデータ](/ja/use-dify/knowledge/metadata)を参照してください。

+ ドキュメントメタデータの作成と管理については、[メタデータ](/ja/use-dify/knowledge/metadata) を参照してください。

## 出力

-知識検索ノードの出力は`result`という変数として返されます。この変数は検索されたドキュメントチャンクの配列で、各チャンクにはコンテンツ、メタデータ、タイトル、その他の属性が含まれます。

+知識検索ノードの出力は `result` という変数として返されます。この変数は検索されたドキュメントチャンクの配列で、各チャンクには内容・メタデータ・タイトルなどの情報が含まれます。

-検索結果に画像添付が含まれる場合、`result`変数には画像メタデータを含む`files`というフィールドも含まれます。

+検索結果に画像が含まれる場合、`result` 変数には画像の詳細が格納された `files` フィールドも含まれます。

-## LLMノードとの連携

+## LLM ノードとの連携

-LLMノードでユーザーの質問に回答するためのコンテキストとして検索結果を使用するには:

+検索結果を活用して LLM ノードで質問応答を行うには:

-1. **コンテキスト**フィールドで、知識検索ノードの`result`変数を選択します。

+1. **コンテキスト** フィールドで、知識検索ノードの `result` 変数を選択します。

-2. プロンプトフィールドで、`Context`変数とユーザー入力変数(例:Chatflowの`userinput.query`)の両方を参照します。

+2. LLM のプロンプト入力欄では、`コンテキスト` 変数とユーザー入力変数(例:Chatflow の `userinput.query`)の両方を参照してください。

-3. (任意)LLMがVision機能に対応している場合(**Vision**アイコン付き)、**Vision**を有効にして検索された画像を解釈させることができます。

+3. (任意)LLMがVision機能に対応している場合は、**Vision**を有効にすると、`コンテキスト`変数内の画像添付を解釈できるようになります。

- **Vision**を有効にすると、LLMは検索された画像を自動的に処理します。**Vision**入力フィールドで`Context`変数を再度手動で参照する必要はありません。

+ **Vision**を有効にすると、LLMは`コンテキスト`変数内の画像を直接理解できます。別途**Vision**入力変数を設定する必要はありません。

- +

+ +

+

+

+

+ Dify Cloud では、知識検索の操作は契約プランに応じたレートリミット(リクエスト上限)が適用されます。詳細は [ナレッジベースの要求頻度制限](/ja/use-dify/knowledge/knowledge-request-rate-limit) を参照してください。

+

\ No newline at end of file

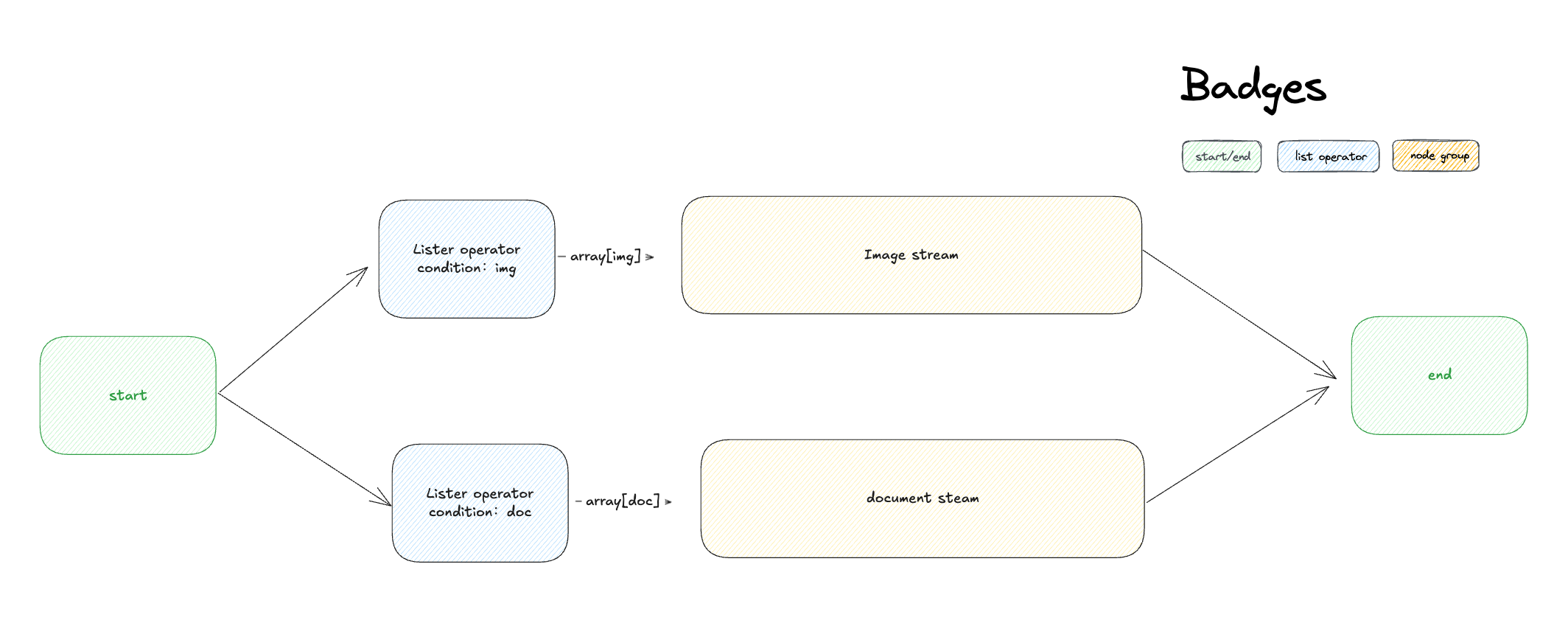

diff --git a/ja/use-dify/nodes/list-operator.mdx b/ja/use-dify/nodes/list-operator.mdx

index e0400a3fe..a287c5554 100644

--- a/ja/use-dify/nodes/list-operator.mdx

+++ b/ja/use-dify/nodes/list-operator.mdx

@@ -6,9 +6,8 @@ icon: "filter"

⚠️ このドキュメントはAIによって自動翻訳されています。不正確な部分がある場合は、[英語版](/en/use-dify/nodes/list-operator)を参照してください。

-リスト演算子ノードは、配列のフィルタリング、ソート、特定の要素の選択を行います。混合ファイルアップロード、大規模なデータセット、または下流処理の前に分離や整理が必要な配列データを扱う際に使用します。

-サポートされる入力データ型には、`array[string]`、`array[number]`、`array[file]`、`array[boolean]`があります。

+リスト演算子ノードは、配列のフィルタリング、ソート、特定の要素の選択を行います。混合ファイルアップロード、大規模なデータセット、または下流処理の前に分離や整理が必要な配列データを扱う際に使用します。

@@ -24,6 +23,16 @@ icon: "filter"

@@ -24,6 +23,16 @@ icon: "filter"

+## サポートされるデータ型

+

+ノードは適切なフィルタリングオプションを使用して、さまざまな配列タイプを処理します:

+

+**Array[string]** - テキストリスト、カテゴリ、名前、または任意の文字列コレクション

+

+**Array[number]** - 数値データ、スコア、測定値、または計算結果

+

+**Array[file]** - 豊富なメタデータフィルタリング機能を持つ混合ファイルアップロード

+

## 操作

### フィルタリング

@@ -70,7 +79,7 @@ icon: "filter"

**result** - バルク処理用の完全なフィルタリングおよびソート済み配列

-**first_record** - 先頭からの単一要素、「主要」または「最新」アイテム選択に最適

+**first_record** - 先頭からの単一要素、「プテム選択に最適

**last_record** - 末尾からの単一要素、「最新」または「最終」選択に有用

@@ -86,9 +95,31 @@ icon: "filter"

1. **混合アップロードの設定** - 複数のファイルタイプを受け入れるファイルアップロード機能を有効化

2. **タイプ別に分割** - 異なるフィルターを持つ別々のリスト演算子ノードを使用:

- - `type = "image"`でフィルタリング → ビジョン機能を持つLLMにルーティング

+ - `type = "image"`でフィルタリング → ビジョン機能を持つ大規模言語モデルにルーティング

- `type = "document"`でフィルタリング → 文書抽出器にルーティング

3. **適切に処理** - 画像は直接分析され、文書はテキスト抽出が行われる

4. **結果を結合** - 処理された出力を統一されたレスポンスにマージ

-このパターンは、異なるファイルタイプを適切なプロセッサーに自動的にルーティングし、シームレスなマルチモーダルユーザーエクスペリエンスを作成します。

\ No newline at end of file

+このパターンは、異なるファイルタイプを適切なプロセッサーに自動的にルーティングし、シームレスなマルチモーダルユーザーエクスペリエンスを作成します。

+

+## 一般的な使用例

+

+**ファイルタイプルーティング** - 混合アップロードをコンテンツタイプに基づいて専門的な処理パイプラインに分離

+

+**データフィルタリング** - 特定の基準に基づいて大規模なデータセットから関連するサブセットを抽出

+

+**コンテンツ優先順位付け** - コレクションから最も重要または最新のアイテムをソートして選択

+

+**品質管理** - 処理前に無効、過大サイズ、またはサポートされていないコンテンツをフィルターで除外

+

+**バッチ準備** - 下流の反復処理や並列処理のためにデータを管理可能なチャンクに整理

+

+## ベストプラクティス

+

+**フィルター基準の計画** - 下流処理要件に基づいて明確なフィルタリングルールを定義

+

+**適切な出力タイプの使用** - 下流ノードがデータをどのように使用するかに基づいて、完全な配列、最初のレコード、または最後のレコードを選択

+

+**空の結果の処理** - フィルターが一致しない場合の対処法を検討し、適切なフォールバックロジックを計画

+

+**実データでのテスト** - 本番環境での信頼性のある動作を保証するために、実際のユーザーアップロードでフィルタリング動作を検証

diff --git a/ja/use-dify/nodes/llm.mdx b/ja/use-dify/nodes/llm.mdx

index 5b00f5892..e5fb911fd 100644

--- a/ja/use-dify/nodes/llm.mdx

+++ b/ja/use-dify/nodes/llm.mdx

@@ -6,6 +6,7 @@ icon: "brain"

+## サポートされるデータ型

+

+ノードは適切なフィルタリングオプションを使用して、さまざまな配列タイプを処理します:

+

+**Array[string]** - テキストリスト、カテゴリ、名前、または任意の文字列コレクション

+

+**Array[number]** - 数値データ、スコア、測定値、または計算結果

+

+**Array[file]** - 豊富なメタデータフィルタリング機能を持つ混合ファイルアップロード

+

## 操作

### フィルタリング

@@ -70,7 +79,7 @@ icon: "filter"

**result** - バルク処理用の完全なフィルタリングおよびソート済み配列

-**first_record** - 先頭からの単一要素、「主要」または「最新」アイテム選択に最適

+**first_record** - 先頭からの単一要素、「プテム選択に最適

**last_record** - 末尾からの単一要素、「最新」または「最終」選択に有用

@@ -86,9 +95,31 @@ icon: "filter"

1. **混合アップロードの設定** - 複数のファイルタイプを受け入れるファイルアップロード機能を有効化

2. **タイプ別に分割** - 異なるフィルターを持つ別々のリスト演算子ノードを使用:

- - `type = "image"`でフィルタリング → ビジョン機能を持つLLMにルーティング

+ - `type = "image"`でフィルタリング → ビジョン機能を持つ大規模言語モデルにルーティング

- `type = "document"`でフィルタリング → 文書抽出器にルーティング

3. **適切に処理** - 画像は直接分析され、文書はテキスト抽出が行われる

4. **結果を結合** - 処理された出力を統一されたレスポンスにマージ

-このパターンは、異なるファイルタイプを適切なプロセッサーに自動的にルーティングし、シームレスなマルチモーダルユーザーエクスペリエンスを作成します。

\ No newline at end of file

+このパターンは、異なるファイルタイプを適切なプロセッサーに自動的にルーティングし、シームレスなマルチモーダルユーザーエクスペリエンスを作成します。

+

+## 一般的な使用例

+

+**ファイルタイプルーティング** - 混合アップロードをコンテンツタイプに基づいて専門的な処理パイプラインに分離

+

+**データフィルタリング** - 特定の基準に基づいて大規模なデータセットから関連するサブセットを抽出

+

+**コンテンツ優先順位付け** - コレクションから最も重要または最新のアイテムをソートして選択

+

+**品質管理** - 処理前に無効、過大サイズ、またはサポートされていないコンテンツをフィルターで除外

+

+**バッチ準備** - 下流の反復処理や並列処理のためにデータを管理可能なチャンクに整理

+

+## ベストプラクティス

+

+**フィルター基準の計画** - 下流処理要件に基づいて明確なフィルタリングルールを定義

+

+**適切な出力タイプの使用** - 下流ノードがデータをどのように使用するかに基づいて、完全な配列、最初のレコード、または最後のレコードを選択

+

+**空の結果の処理** - フィルターが一致しない場合の対処法を検討し、適切なフォールバックロジックを計画

+

+**実データでのテスト** - 本番環境での信頼性のある動作を保証するために、実際のユーザーアップロードでフィルタリング動作を検証

diff --git a/ja/use-dify/nodes/llm.mdx b/ja/use-dify/nodes/llm.mdx

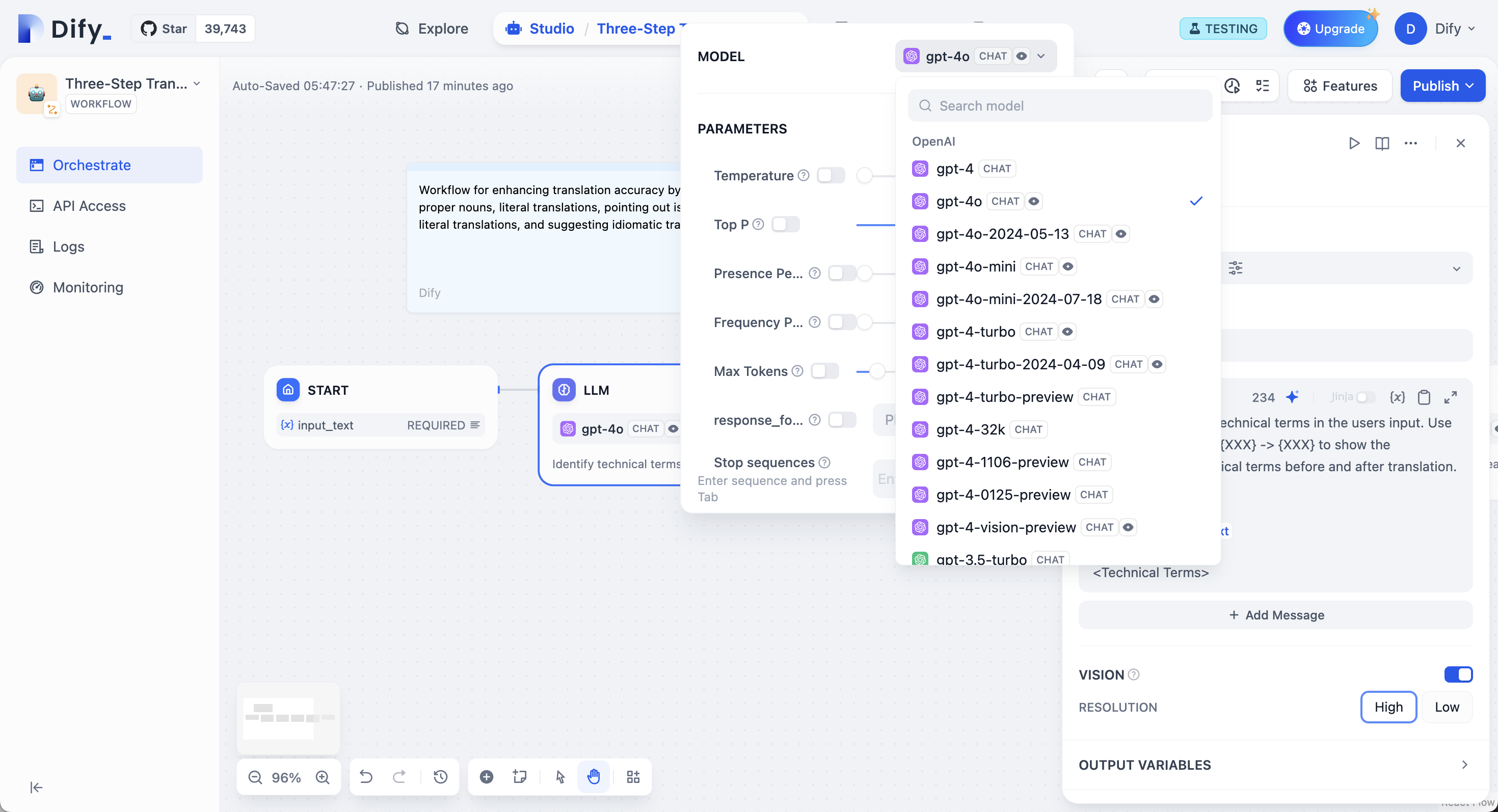

index 5b00f5892..e5fb911fd 100644

--- a/ja/use-dify/nodes/llm.mdx

+++ b/ja/use-dify/nodes/llm.mdx

@@ -6,6 +6,7 @@ icon: "brain"

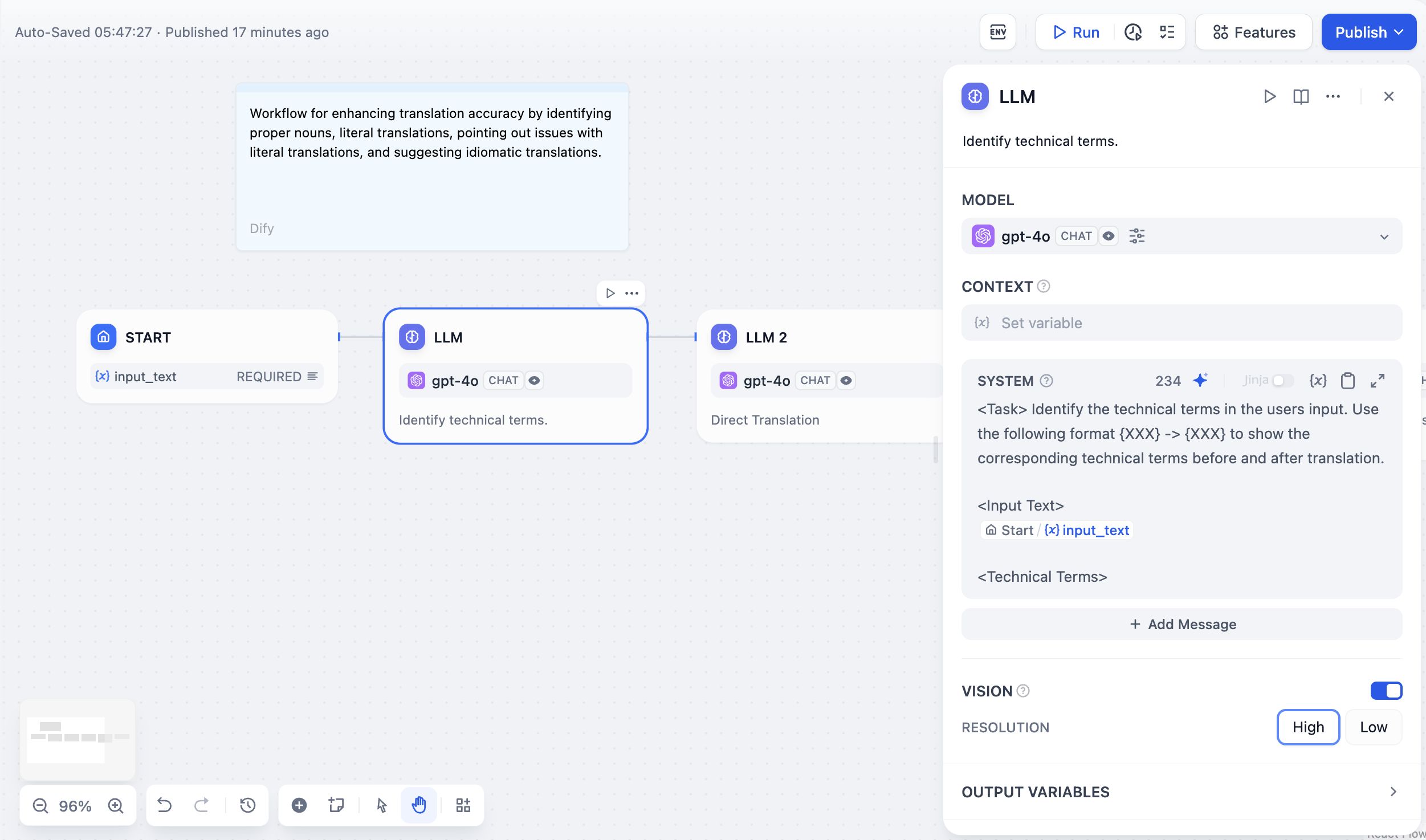

⚠️ このドキュメントはAIによって自動翻訳されています。不正確な部分がある場合は、[英語版](/en/use-dify/nodes/llm)を参照してください。

+

LLMノードは大規模言語モデルを呼び出してテキスト、画像、ドキュメントを処理します。設定されたモデルにプロンプトを送信し、その応答を取得します。構造化出力、コンテキスト管理、マルチモーダル入力をサポートしています。

@@ -13,18 +14,18 @@ LLMノードは大規模言語モデルを呼び出してテキスト、画像

- LLMノードを使用する前に、**システム設定 → モデルプロバイダー**で少なくとも1つのモデルプロバイダーを設定してください。

+ LLMノードを使用する前に、**システム設定 → モデルプロバイダー**で少なくとも1つのモデルプロバイダーを設定してください。セットアップ手順については[モデル設定ガイド](/en/guides/model-configuration/readme)をご覧ください。

-## モデル選択とパラメータ

+## モデル選択とパラメーター

設定したモデルプロバイダーから任意のモデルを選択できます。異なるモデルはそれぞれ異なるタスクに適しています。GPT-4とClaude 3.5は複雑な推論を得意としますがコストが高く、GPT-3.5 Turboは機能と価格のバランスが取れています。ローカル展開には、Ollama、LocalAI、Xinferenceを使用してください。

-

+

-モデルパラメータは応答生成を制御します。**温度**は0(決定的)から1(創造的)の範囲です。**Top P**は確率によって単語選択を制限します。**頻度ペナルティ**は繰り返しを減らします。**存在ペナルティ**は新しいトピックを促進します。プリセットも使用できます:**精密**、**バランス**、**創造的**。

+モデルパラメーターは応答生成を制御します。**温度**は0(決定的)から1(創造的)の範囲です。**核サンプリング**は確率によって単語選択を制限します。**頻度ペナルティ**は繰り返しを減らします。**存在ペナルティ**は新しいトピックを促進します。プリセットも使用できます:**精密**、**バランス**、**創造的**。

## プロンプト設定

@@ -39,7 +40,7 @@ User: {{user_input}}

## コンテキスト変数

-コンテキスト変数はソース帰属を保持しながら外部知識を注入します。これにより、大規模言語モデルがあなたの特定のドキュメントを使用して質問に答えるRAGアプリケーションが可能になります。

+コンース帰属を保持しながら外部知識を注入します。これにより、大規模言語モデルがあなたの特定のドキュメントを使用して質問に答えるRAGアプリケーションが可能になります。

-モデルパラメータは応答生成を制御します。**温度**は0(決定的)から1(創造的)の範囲です。**Top P**は確率によって単語選択を制限します。**頻度ペナルティ**は繰り返しを減らします。**存在ペナルティ**は新しいトピックを促進します。プリセットも使用できます:**精密**、**バランス**、**創造的**。

+モデルパラメーターは応答生成を制御します。**温度**は0(決定的)から1(創造的)の範囲です。**核サンプリング**は確率によって単語選択を制限します。**頻度ペナルティ**は繰り返しを減らします。**存在ペナルティ**は新しいトピックを促進します。プリセットも使用できます:**精密**、**バランス**、**創造的**。

## プロンプト設定

@@ -39,7 +40,7 @@ User: {{user_input}}

## コンテキスト変数

-コンテキスト変数はソース帰属を保持しながら外部知識を注入します。これにより、大規模言語モデルがあなたの特定のドキュメントを使用して質問に答えるRAGアプリケーションが可能になります。

+コンース帰属を保持しながら外部知識を注入します。これにより、大規模言語モデルがあなたの特定のドキュメントを使用して質問に答えるRAGアプリケーションが可能になります。

@@ -54,7 +55,7 @@ User: {{user_input}}

質問:{{user_question}}

```

-知識検索からのコンテキスト変数を使用する場合、Difyは自動的に引用を追跡するため、ユーザーは情報源を確認できます。

+知識検索からのコンテキスト変数を使用する場合、Difyは自動的に引用と帰属を追跡するため、ユーザーは情報源を確認できます。

## 構造化出力

@@ -93,10 +94,9 @@ User: {{user_input}}

## メモリとファイル処理

-

-メモリを有効にすると、チャットフロー会話内の複数のLLM呼び出しでコンテキストを維持できます。有効にすると、以前のインタラクションがフォーマットされたユーザー - アシスタント出力として後続のプロンプトに含まれます。`USER`テンプレートを編集することで、ユーザープロンプトに入力される内容をカスタマイズできます。メモリはノード固有であり、異なる会話間では持続しません。

+**メモリ**を有効にすると、ワークフロー実行内の複数のLLM呼び出しでコンテキストを維持できます。ノードは以前のインタラクションを後続のプロンプトに含めます。メモリはノード固有であり、ワークフロー実行間では持続しません。

-**ファイル処理**では、マルチモーダルモデル用にプロンプトにファイル変数を追加します。GPT-4Vは画像を、ClaudeはPDFを直接処理しますが、他のモデルでは前処理が必要な場合があります。

+**ファイル処理**では、マルチモーダルモデル用にプロンプトにファイル変数を追加します。GPT-4Vは画像をaudeはPDFを直接処理しますが、他のモデルでは前処理が必要な場合があります。

### ビジョン機能設定

@@ -104,12 +104,18 @@ User: {{user_input}}

- **高詳細** - 複雑な画像でより良い精度を提供しますが、より多くのトークンを使用します

- **低詳細** - シンプルな画像でより少ないトークンでより高速な処理

-ビジョン機能のデフォルト変数セレクターは`userinput.files`で、ユーザー入力ノードからファイルを自動的に取得します。

+ビジョン機能のデフォルト変数セレクターは`sys.files`で、開始ノードからファイルを自動的に取得します。

@@ -54,7 +55,7 @@ User: {{user_input}}

質問:{{user_question}}

```

-知識検索からのコンテキスト変数を使用する場合、Difyは自動的に引用を追跡するため、ユーザーは情報源を確認できます。

+知識検索からのコンテキスト変数を使用する場合、Difyは自動的に引用と帰属を追跡するため、ユーザーは情報源を確認できます。

## 構造化出力

@@ -93,10 +94,9 @@ User: {{user_input}}

## メモリとファイル処理

-

-メモリを有効にすると、チャットフロー会話内の複数のLLM呼び出しでコンテキストを維持できます。有効にすると、以前のインタラクションがフォーマットされたユーザー - アシスタント出力として後続のプロンプトに含まれます。`USER`テンプレートを編集することで、ユーザープロンプトに入力される内容をカスタマイズできます。メモリはノード固有であり、異なる会話間では持続しません。

+**メモリ**を有効にすると、ワークフロー実行内の複数のLLM呼び出しでコンテキストを維持できます。ノードは以前のインタラクションを後続のプロンプトに含めます。メモリはノード固有であり、ワークフロー実行間では持続しません。

-**ファイル処理**では、マルチモーダルモデル用にプロンプトにファイル変数を追加します。GPT-4Vは画像を、ClaudeはPDFを直接処理しますが、他のモデルでは前処理が必要な場合があります。

+**ファイル処理**では、マルチモーダルモデル用にプロンプトにファイル変数を追加します。GPT-4Vは画像をaudeはPDFを直接処理しますが、他のモデルでは前処理が必要な場合があります。

### ビジョン機能設定

@@ -104,12 +104,18 @@ User: {{user_input}}

- **高詳細** - 複雑な画像でより良い精度を提供しますが、より多くのトークンを使用します

- **低詳細** - シンプルな画像でより少ないトークンでより高速な処理

-ビジョン機能のデフォルト変数セレクターは`userinput.files`で、ユーザー入力ノードからファイルを自動的に取得します。

+ビジョン機能のデフォルト変数セレクターは`sys.files`で、開始ノードからファイルを自動的に取得します。

+補完モデルでの会話履歴については、マルチターンコンテキストを維持するために会話変数を挿入します:

+

+

+

+補完モデルでの会話履歴については、マルチターンコンテキストを維持するために会話変数を挿入します:

+

+

+  +

+

## Jinja2テンプレートサポート

LLMプロンプトは高度な変数処理のためにJinja2テンプレートをサポートしています。Jinja2モード(`edition_type: "jinja2"`)を使用すると、次のことができます:

@@ -122,9 +128,9 @@ LLMプロンプトは高度な変数処理のためにJinja2テンプレート

Jinja2変数は通常の変数置換とは別に処理され、プロンプト内でループ、条件文、複雑なデータ変換が可能になります。

-## ストリーミング出力

+## ストリーミングレスポンス

-LLMノードはデフォルトでストリーミング出力をサポートしています。各テキストチャンクは`RunStreamChunkEvent`として生成され、リアルタイムの応答表示が可能になります。ファイル出力(画像、ドキュメント)はストリーミング中に自動的に処理され保存されます。

+LLMノードはデフォルトでストリーミングレスポンスをサポートしています。各テキストチャンクは`RunStreamChunkEvent`として生成され、リアルタイムの応答表示が可能になります。ファイル出力(画像、ドキュメント)はストリーミング中に自動的に処理され保存されます。

## エラーハンドリング

diff --git a/ja/use-dify/nodes/trigger/overview.mdx b/ja/use-dify/nodes/trigger/overview.mdx

index 87f4edf08..e250ce9aa 100644

--- a/ja/use-dify/nodes/trigger/overview.mdx

+++ b/ja/use-dify/nodes/trigger/overview.mdx

@@ -3,28 +3,26 @@ title: トリガー

sidebarTitle: "概要"

---

-

+

+

## Jinja2テンプレートサポート

LLMプロンプトは高度な変数処理のためにJinja2テンプレートをサポートしています。Jinja2モード(`edition_type: "jinja2"`)を使用すると、次のことができます:

@@ -122,9 +128,9 @@ LLMプロンプトは高度な変数処理のためにJinja2テンプレート

Jinja2変数は通常の変数置換とは別に処理され、プロンプト内でループ、条件文、複雑なデータ変換が可能になります。

-## ストリーミング出力

+## ストリーミングレスポンス

-LLMノードはデフォルトでストリーミング出力をサポートしています。各テキストチャンクは`RunStreamChunkEvent`として生成され、リアルタイムの応答表示が可能になります。ファイル出力(画像、ドキュメント)はストリーミング中に自動的に処理され保存されます。

+LLMノードはデフォルトでストリーミングレスポンスをサポートしています。各テキストチャンクは`RunStreamChunkEvent`として生成され、リアルタイムの応答表示が可能になります。ファイル出力(画像、ドキュメント)はストリーミング中に自動的に処理され保存されます。

## エラーハンドリング

diff --git a/ja/use-dify/nodes/trigger/overview.mdx b/ja/use-dify/nodes/trigger/overview.mdx

index 87f4edf08..e250ce9aa 100644

--- a/ja/use-dify/nodes/trigger/overview.mdx

+++ b/ja/use-dify/nodes/trigger/overview.mdx

@@ -3,28 +3,26 @@ title: トリガー

sidebarTitle: "概要"

---

- ⚠️ このドキュメントはAIによって自動翻訳されています。不正確な部分がある場合は、[英語版](/en/use-dify/nodes/trigger/overview)を参照してください。

-

## はじめに

- トリガーはワークフローアプリケーションでのみ利用可能です。

+ トリガーは workflow アプリケーションでのみ利用可能です。

-トリガーは開始ノードの一種で、ユーザーや API 呼び出しによる能動的な開始を待つのではなく、スケジュールに従って、または外部システム(例:GitHub、Gmail、または独自の内部システム)からのイベントに応じて、ワークフローを自動的に実行できるようにします。

+トリガーは開始ノードの一種で、ユーザーや API 呼び出しによる能動的な開始を待つのではなく、スケジュールに従って、または外部システム(例:GitHub、Gmail、または独自の内部システム)からのイベントに応じて、workflow を自動的に実行できるようにします。

-トリガーは、反復タスクの自動化や、ワークフローをサードパーティアプリケーションと統合して自動的なデータ同期と処理を実現するのに最適です。

+トリガーは、反復タスクの自動化や、workflow をサードパーティアプリケーションと統合して自動的なデータ同期と処理を実現するのに最適です。

-1 つのワークフローは、並行して実行される複数のトリガーを持つことができます。また、同じキャンバス上に複数の独立したワークフローを構築し、それぞれが独自のトリガーで開始することもできます。

+1 つの workflow は、並行して実行される複数のトリガーを持つことができます。また、同じキャンバス上に複数の独立した workflow を構築し、それぞれが独自のトリガーで開始することもできます。

- Sandbox プランでは、ワークフローあたり 2 つのトリガーのみがサポートされています。追加するには[アップグレード](https://dify.ai/pricing)してください。

+ Sandbox プランでは、workflow あたり 2 つのトリガーのみがサポートされています。追加するには[アップグレード](https://dify.ai/jp/pricing)してください。

-各ワークフロー実行のトリガーソースは、**ログ**セクションに表示されます。

+各 workflow 実行のトリガーソースは、**ログ**セクションに表示されます。

- Dify Cloud では、トリガーイベント(トリガーによって開始されるワークフロー実行)はプランごとに異なる上限が設定されています。詳細は[プラン比較](https://dify.ai/pricing)をご覧ください。

+ Dify Cloud では、トリガーイベント(トリガーによって開始される workflow 実行)はプランごとに異なる上限が設定されています。詳細は[プラン比較](https://dify.ai/jp/pricing)をご覧ください。

ワークスペースのオーナーおよび管理者は、**設定** > **請求**で残りのクォータを確認できます。

@@ -33,28 +31,24 @@ sidebarTitle: "概要"

- [スケジュールトリガー](/ja/use-dify/nodes/trigger/schedule-trigger)

- - 指定された時刻または間隔でワークフローを実行します。

+ - 指定された時刻または間隔で workflow を実行します。

- 例:毎朝 9 時に日次売上レポートを自動生成し、チームにメールで送信します。

-

- 各ワークフローには最大 1 つのスケジュールトリガーを設定できます。

-

-

- [プラグイントリガー](/ja/use-dify/nodes/trigger/plugin-trigger)

- - トリガープラグインを通じたイベントサブスクリプションにより、外部システムで特定のイベントが発生したときにワークフローを実行します。

+ - トリガープラグインを通じたイベントサブスクリプションにより、外部システムで特定のイベントが発生したときに workflow を実行します。

- 例:Slack トリガープラグインを通じて`チャンネル内の新規メッセージ`イベントをサブスクライブすることで、特定の Slack チャンネル内の新規メッセージを自動的に分析およびアーカイブします。

- [Webhook トリガー](/ja/use-dify/nodes/trigger/webhook-trigger)

- - カスタム webhook を介して外部システムで特定のイベントが発生したときにワークフローを実行します。

+ - カスタム webhook を介して外部システムで特定のイベントが発生したときに workflow を実行します。

- 例:e コマースプラットフォームから注文詳細を含む HTTP リクエストに応答して、新規注文を自動的に処理します。

- プラグイントリガーと webhook トリガーは、どちらもワークフローを*イベント駆動型*にします。選択方法は次のとおりです:

+ プラグイントリガーと webhook トリガーは、どちらも workflow を*イベント駆動型*にします。選択方法は次のとおりです:

1. 対象の外部システムにトリガープラグインが利用可能な場合は、**プラグイントリガー**を使用してください。サポートされているイベントを簡単にサブスクライブできます。

@@ -63,7 +57,7 @@ sidebarTitle: "概要"

## トリガーの有効化または無効化

-**クイック設定**サイドメニューでは、公開済みのトリガーを有効化または無効化できます。無効化されたトリガーはワークフローの実行を開始しません。

+**クイック設定**サイドメニューでは、公開済みのトリガーを有効化または無効化できます。無効化されたトリガーは workflow の実行を開始しません。

**クイック設定**には、公開済みのトリガーのみが表示されます。トリガーがリストに表示されない場合は、まず公開されていることを確認してください。

@@ -73,7 +67,7 @@ sidebarTitle: "概要"

## 複数のトリガーをテストする

-ワークフローに複数のトリガーがある場合、**テスト実行** > **すべてのトリガーを実行**をクリックして一度にテストできます。最初にアクティブ化されたトリガーがワークフローを開始し、他のトリガーは無視されます。

+workflow に複数のトリガーがある場合、**テスト実行** > **すべてのトリガーを実行**をクリックして一度にテストできます。最初にアクティブ化されたトリガーが workflow を開始し、他のトリガーは無視されます。

**すべてのトリガーを実行**をクリックすると:

@@ -81,4 +75,4 @@ sidebarTitle: "概要"

- プラグイントリガーはサブスクライブされたイベントをリッスンします。

-- Webhook トリガーは外部 HTTP リクエストをリッスンします。

\ No newline at end of file

+- Webhook トリガーは受信 HTTP リクエストをリッスンします。

\ No newline at end of file

diff --git a/ja/use-dify/nodes/trigger/plugin-trigger.mdx b/ja/use-dify/nodes/trigger/plugin-trigger.mdx

index 5d912d3b8..3026c746e 100644

--- a/ja/use-dify/nodes/trigger/plugin-trigger.mdx

+++ b/ja/use-dify/nodes/trigger/plugin-trigger.mdx

@@ -2,32 +2,30 @@

title: プラグイントリガー

---

- ⚠️ このドキュメントはAIによって自動翻訳されています。不正確な部分がある場合は、[英語版](/en/use-dify/nodes/trigger/plugin-trigger)を参照してください。

-

## はじめに

- トリガーはワークフローアプリケーションでのみ利用可能です。

+ トリガーは workflow アプリケーションでのみ利用可能です。

-プラグイントリガーは、外部システムで特定のイベントが発生したときに自動的にワークフローを開始します。必要なのは、トリガープラグインを通じてこれらのイベントをサブスクライブし、対応するプラグイントリガーをワークフローに追加することだけです。

+プラグイントリガーは、外部システムで特定のイベントが発生したときに自動的に workflow を開始します。必要なのは、トリガープラグインを通じてこれらのイベントをサブスクライブし、対応するプラグイントリガーを workflow に追加することだけです。

-例えば、GitHub トリガープラグインをインストールしたとします。これは、`Pull Request`、`Push`、`Issue` を含む、サブスクライブできる GitHub イベントのリストを提供します。`Pull Request` イベントをサブスクライブし、`Pull Request` プラグイントリガーをワークフローに追加すると、指定されたリポジトリで誰かがプルリクエストを開くたびに自動的に実行されます。

+例えば、GitHub トリガープラグインをインストールしたとします。これは、`Pull Request`、`Push`、`Issue` を含む、サブスクライブできる GitHub イベントのリストを提供します。`Pull Request` イベントをサブスクライブし、`Pull Request` プラグイントリガーを workflow に追加すると、指定されたリポジトリで誰かがプルリクエストを開くたびに自動的に実行されます。

## プラグイントリガーの追加と設定

-1. ワークフローキャンバスで右クリックし、**ブロックを追加** > **始める** を選択してから、利用可能なプラグイントリガーの中から選択するか、[Dify Marketplace](https://marketplace.dify.ai/?language=jp-ja&category=trigger) でさらに検索します。

+workflow キャンバスで右クリックし、**ブロックを追加** > **始める** を選択してから、利用可能なプラグイントリガーの中から選択するか、[Dify Marketplace](https://marketplace.dify.ai/?language=jp-ja&category=trigger) でさらに検索します。

- 対象の外部システムに適切なトリガープラグインがない場合は、[コミュニティにリクエスト](https://github.com/langgenius/dify-plugins/issues/new?template=plugin_request.yaml)したり、[自分で開発](/ja/develop-plugin/dev-guides-and-walkthroughs/trigger-plugin)したり、代わりに [Webhook トリガー](/ja/use-dify/nodes/trigger/webhook-trigger)を使用したりできます。

- - 1 つのワークフローは、並行して実行される複数のプラグイントリガーで開始できます。並行分岐に同一の連続したノードが含まれている場合、共通セクションの前に[変数集約](/ja/use-dify/nodes/variable-aggregator)ノードを追加して分岐をマージできます。これにより、各分岐で同じノードを個別に重複して追加することを回避できます。

+ - 1 つの workflow は、並行して実行される複数のプラグイントリガーで開始できます。並行分岐に同一の連続したノードが含まれている場合、共通セクションの前に[変数集約](/ja/use-dify/nodes/variable-aggregator)ノードを追加して分岐をマージできます。これにより、各分岐で同じノードを個別に重複して追加することを回避できます。

2. 既存のサブスクリプションを選択するか、[新しいサブスクリプションを作成](#新しいサブスクリプションを作成)します。

- **プラグイン**配下のプラグイン詳細パネルから、特定のサブスクリプションを使用しているワークフローの数を確認できます。

+ **プラグイン**配下のプラグイン詳細パネルから、特定のサブスクリプションを使用している workflow の数を確認できます。

3. その他の必要な設定を行います。

@@ -38,6 +36,10 @@ title: プラグイントリガー

## 新しいサブスクリプションを作成

+

+ サブスクリプションは一度作成すると変更できません。変更するには、既存のサブスクリプションを削除して新しいサブスクリプションを作成してください。

+

+

トリガープラグインは、ワークスペースごとに最大 10 個のサブスクリプションをサポートします。

@@ -61,7 +63,7 @@ Dify は以下の 2 つの方法でサブスクリプション(Webhook)を

サブスクリプションを作成する際は、利用可能なすべてのイベントを選択することをお勧めします。

- プラグイントリガーは、対応するイベントがリンクされたサブスクリプションに含まれている場合にのみ機能します。利用可能なすべてのイベントを選択すると、後でワークフローに追加するプラグイントリガーが同じサブスクリプションを使用でき、サブスクリプションを更新したり新しく作成したりする必要がなくなります。

+ プラグイントリガーは、対応するイベントがリンクされたサブスクリプションに含まれている場合にのみ機能します。利用可能なすべてのイベントを選択すると、後で workflow に追加するプラグイントリガーが同じサブスクリプションを使用でき、別のサブスクリプションを作成する必要がなくなります。

@@ -90,7 +92,7 @@ Dify は以下の 2 つの方法でサブスクリプション(Webhook)を

3. サブスクリプション名を指定し、サブスクライブするイベントを選択し、その他の必要な設定を行います。

- 利用可能なすべてのイベントを選択することをお勧めしますが、後から**プラグイン**配下のプラグイン詳細パネルでいつでも選択を変更できます。

+ 利用可能なすべてのイベントを選択することをお勧めします。

4. **作成**をクリックします。

@@ -111,7 +113,7 @@ Dify は以下の 2 つの方法でサブスクリプション(Webhook)を

4. サブスクリプション名を指定し、サブスクライブするイベントを選択し、その他の必要な設定を行います。

- 利用可能なすべてのイベントを選択することをお勧めしますが、後から**プラグイン**配下のプラグイン詳細パネルでいつでも選択を変更できます。

+ 利用可能なすべてのイベントを選択することをお勧めします。

5. **作成**をクリックします。

@@ -136,7 +138,7 @@ Dify は以下の 2 つの方法でサブスクリプション(Webhook)を

3. サブスクリプション名を指定し、サブスクライブするイベントを選択し、その他の必要な設定を行います。

- 利用可能なすべてのイベントを選択することをお勧めしますが、後から**プラグイン**配下のプラグイン詳細パネルでいつでも選択を変更できます。

+ 利用可能なすべてのイベントを選択することをお勧めします。

4. **作成**をクリックします。

@@ -181,4 +183,4 @@ Dify は以下の 2 つの方法でサブスクリプション(Webhook)を

## プラグイントリガーをテストする

-未公開のプラグイントリガーをテストするには、まず**このステップ実行**をクリックするか、ワークフロー全体をテスト実行する必要があります。これによりトリガーがリスニング状態になり、外部イベントを監視できるようになります。そうしないと、イベントが発生してもトリガーはサブスクライブしたイベントをキャプチャしません。

\ No newline at end of file

+未公開のプラグイントリガーをテストするには、まず**このステップ実行**をクリックするか、workflow 全体をテスト実行する必要があります。これによりトリガーがリスニング状態になり、外部イベントを監視できるようになります。そうしないと、イベントが発生してもトリガーはサブスクライブしたイベントをキャプチャしません。

\ No newline at end of file

diff --git a/ja/use-dify/nodes/trigger/schedule-trigger.mdx b/ja/use-dify/nodes/trigger/schedule-trigger.mdx

index 83ea1ad94..a46f13914 100644

--- a/ja/use-dify/nodes/trigger/schedule-trigger.mdx

+++ b/ja/use-dify/nodes/trigger/schedule-trigger.mdx

@@ -2,21 +2,21 @@

title: スケジュールトリガー

---

- ⚠️ このドキュメントはAIによって自動翻訳されています。不正確な部分がある場合は、[英語版](/en/use-dify/nodes/trigger/schedule-trigger)を参照してください。

-

## はじめに

- - トリガーはワークフローアプリケーションでのみ利用可能です。

-

- - 各ワークフローには最大1つのスケジュールトリガーを設定できます。

+ トリガーは workflow アプリケーションでのみ利用可能です。

-スケジュールトリガーを使用すると、指定した時刻または間隔でワークフローを実行できます。これは、日次レポートの生成やスケジュールされた通知の送信など、繰り返し発生するタスクに最適です。

+スケジュールトリガーを使用すると、指定した時刻または間隔で workflow を実行できます。これは、日次レポートの生成やスケジュールされた通知の送信など、繰り返し発生するタスクに最適です。

## スケジュールトリガーの追加

-ワークフローキャンバスで右クリックし、**ブロックを追加** > **始める** > **スケジュールトリガー** を選択します。

+workflow キャンバスで右クリックし、**ブロックを追加** > **始める** > **スケジュールトリガー** を選択します。

+

+

+ 1 つの workflow は、並行して実行される複数のスケジュールトリガーで開始できます。並行分岐に同一の連続したノードが含まれている場合、共通セクションの前に[変数集約](/ja/use-dify/nodes/variable-aggregator)ノードを追加して分岐をマージできます。これにより、各分岐で同じノードを個別に重複して追加することを回避できます。

+

## スケジュールトリガーの設定

@@ -25,7 +25,7 @@ title: スケジュールトリガー

設定後、次の 5 回のスケジュール実行時刻を確認できます。

- スケジュールトリガーは出力変数を生成しませんが、ワークフローをトリガーするたびにシステム変数 `sys.timestamp`(各ワークフロー実行の開始時刻)を更新します。

+ スケジュールトリガーは出力変数を生成しませんが、workflow をトリガーするたびにシステム変数 `sys.timestamp`(各 workflow 実行の開始時刻)を更新します。

### ビジュアル設定を使用

@@ -42,7 +42,7 @@ title: スケジュールトリガー

#### 標準フォーマット

-Cron 式は、ワークフローの実行スケジュールを定義する文字列です。スペースで区切られた 5 つのフィールドで構成され、それぞれが異なる時間単位を表します。

+Cron 式は、workflow の実行スケジュールを定義する文字列です。スペースで区切られた 5 つのフィールドで構成され、それぞれが異なる時間単位を表します。

各フィールド間に 1 つのスペースがあることを確認してください。

@@ -59,14 +59,15 @@ Cron 式は、ワークフローの実行スケジュールを定義する文字

```

+

**日**と**曜日**の両方のフィールドが指定されている場合、トリガーは*どちらか*のフィールドに一致する日付でアクティブになります。

-

- 例えば、`1 2 3 4 4` は、4 月 3 日*および* 4 月の毎週木曜日にワークフローをトリガーします。4 月 3 日が木曜日である場合に限定されません。

+

+ 例えば、`1 2 3 4 4` は、4 月 3 日*および* 4 月の毎週木曜日に workflow をトリガーします。4 月 3 日が木曜日である場合に限定されません。

#### 特殊文字

-| 文字 | 説明 | 例 |

+| ⚠️ このドキュメントはAIによって自動翻訳されています。不正確な部分がある場合は、[英語版](/en/use-dify/nodes/user-input)を参照してください。

+ ⚠️ このドキュメントは AI によって自動翻訳されています。不正確な点がある場合は、[英語版](/en/use-dify/nodes/user-input)を参照してください。

## はじめに

-ユーザー入力ノードでは、アプリケーションへの入力としてエンドユーザーから収集する内容を定義できます。

+ユーザー入力ノードは、アプリケーションの実行時にエンドユーザーから収集する情報を定義できる開始ノードの一種です。

-このノードで開始するアプリケーションは*オンデマンド*で実行され、直接的なユーザー操作または API 呼び出しによって開始できます。

-

-これらのアプリケーションをスタンドアロンの Web アプリや MCP サーバーとして公開したり、バックエンドサービス API を介して公開したり、他の Dify アプリケーションでツールとして使用したりすることもできます。

+このノードで開始するアプリケーションは、直接的なユーザー操作または API 呼び出しによって開始される*オンデマンド*で実行されます。これらのアプリケーションをスタンドアロンの Web アプリや MCP サーバーとして公開したり、バックエンドサービス API を介して公開したり、他の Dify アプリケーションでツールとして使用したりすることもできます。

各アプリケーションキャンバスには、ユーザー入力ノードを 1 つだけ含めることができます。

@@ -36,16 +34,16 @@ icon: "input-text"

### カスタム

-ユーザー入力ノードでカスタム入力フィールドを設定して、さまざまな種類のユーザー入力を収集できます。各フィールドは、下流のノードから参照できる変数になります。

+ユーザー入力ノードでカスタム入力フィールドを構成して、エンドユーザーから情報を収集できます。各フィールドは、ダウンストリームノードが参照できる変数になります。たとえば、変数名 `user_name` の入力フィールドを追加すると、ワークフロー全体で `{{user_name}}` として参照できます。

+

+さまざまな種類のユーザー入力を処理するために、7 種類の入力フィールドから選択できます。

**ラベル名**はエンドユーザーに表示されます。

- チャットフローアプリケーションでは、任意のユーザー入力フィールドを**非表示**にして、エンドユーザーには見えないようにしつつ、チャットフロー内で参照可能な状態を維持できます。

-

- **必須**フィールドは非表示にできないことに注意してください。

+ チャットフローアプリケーションでは、任意の入力変数を**非表示**にして、エンドユーザーには見えないようにしつつ、チャットフロー内で参照可能な状態を維持できます。

#### テキスト入力

@@ -53,11 +51,11 @@ icon: "input-text"

- 最大 256 文字を受け付けます。名前、メールアドレス、タイトル、または 1 行に収まる短いテキスト入力に使用します。

+ 短いテキストフィールドは最大 256 文字を受け付けます。名前、メールアドレス、タイトル、または 1 行に収まる短いテキスト入力に使用します。

- 長さ制限なしの長文テキストを許可します。詳細な応答や説明のために、ユーザーに複数行のテキストエリアを提供します。

+ 段落フィールドは長さ制限なしの長文テキストを許可します。詳細な応答や説明のために、ユーザーに複数行のテキストエリアを提供します。

@@ -66,21 +64,15 @@ icon: "input-text"

- 事前定義されたオプションを含むドロップダウンメニューを表示します。ユーザーはリストされたオプションからのみ選択でき、データの一貫性を確保し、無効な入力を防ぎます。

+ 選択フィールドは、事前定義されたオプションを含むドロップダウンメニューを表示します。ユーザーはリストされたオプションからのみ選択でき、データの一貫性を確保し、無効な入力を防ぎます。

- 数値のみに入力を制限します。数量、評価、ID、または数学的処理を必要とするデータに最適です。

+ 数値フィールドは数値のみに入力を制限します—数量、評価、ID、または数学的処理を必要とするデータに最適です。

- シンプルなはい/いいえオプションを提供します。ユーザーがボックスをチェックすると、出力は `true` になり、それ以外の場合は `false` になります。確認や二者択一が必要な場合に使用します。

-

-

-

- JSON オブジェクト形式のデータを受け付けます。複雑でネストされたデータ構造をアプリケーションに渡すのに最適です。

-

- オプションで JSON スキーマを定義して、入力を検証し、ユーザーに期待されるデータ構造と検証要件を示すことができます。スキーマを定義すると、他のノードでオブジェクトの個々のプロパティを参照することもできます。

+ チェックボックスフィールドは、シンプルなはい/いいえオプションを提供します。ユーザーがボックスをチェックすると、出力は `true` になります。それ以外の場合は `false` になります。確認や二者択一が必要な場合に使用します。

@@ -88,12 +80,11 @@ icon: "input-text"

- ユーザーはデバイスまたはファイル URL を介して、サポートされている任意のタイプの 1 つのファイルをアップロードできます。アップロードされたファイルは、ファイルメタデータ(名前、サイズ、タイプなど)を含む変数として利用できます。

+ 単一ファイルフィールドを使用すると、ユーザーはデバイスまたはファイル URL を介して、サポートされている任意のタイプの 1 つのファイルをアップロードできます。アップロードされたファイルは、ファイルメタデータ(名前、サイズ、タイプなど)を含む変数として利用できます。

- 一度に複数のファイルのアップロードをサポートします。ドキュメント、画像、その他のファイルのバッチを一緒に処理する場合に便利です。

-

+ ファイルリストフィールドは単一ファイルと同様に機能しますが、一度に複数のファイルのアップロードをサポートします。ドキュメント、画像、その他のファイルのバッチを一緒に処理する場合に便利です。

リスト演算子ノードを使用して、アップロードされたファイルリストから特定のファイルをフィルタリング、並べ替え、または抽出して、さらに処理することができます。

@@ -102,16 +93,16 @@ icon: "input-text"

**ファイル処理**

-ユーザー入力ノードはファイルを収集するだけで、コンテンツを読み取ったり解析したりしないため、アップロードされたファイルは後続のノードによって適切に処理される必要があります。例えば:

+ユーザー入力ノードを介してアップロードされたファイルは、後続のノードによって適切に処理される必要があります。ユーザー入力ノードはファイルを収集するだけで、コンテンツを読み取ったり解析したりしません。

-- ドキュメントファイルは、LLM がそのコンテンツを理解できるように、テキスト抽出のためにドキュメント抽出器ノードにルーティングできます。

+したがって、ファイルコンテンツを抽出して処理するために特定のノードを接続する必要があります。例えば:

+- ドキュメントファイルは、LLM がそのコンテンツを理解できるように、テキスト抽出のためにドキュメント抽出器ノードにルーティングできます。

- 画像は、ビジョン機能を持つ LLM ノードまたは専用の画像処理ツールノードに送信できます。

-

- CSV や JSON などの構造化データファイルは、コードノードを使用して解析および変換できます。

- ユーザーが混在タイプの複数のファイル(画像とドキュメントなど)をアップロードする場合、リスト演算子ノードを使用してファイルタイプ別に分離してから、異なる処理ブランチにルーティングできます。

+ ユーザーが混在タイプの複数のファイル(画像とドキュメントなど)をアップロードする場合、リスト演算子ノードを使用してファイルタイプ別に分離してから、適切な処理ブランチにルーティングできます。

## 次のステップ

@@ -119,7 +110,5 @@ icon: "input-text"

ユーザー入力ノードを設定したら、収集したデータを処理する他のノードに接続できます。一般的なパターンには次のものがあります:

- 入力を LLM ノードに送信して処理する。

-

-- ナレッジ検索ノードを使用して、入力に関連する情報を検索する。

-

-- If/Else ノードを使用して、入力に基づいて条件分岐を作成する。

\ No newline at end of file

+- ナレッジ検索ノードを使用して、入力に基づいて関連情報を検索する。

+- 入力に基づいて条件ロジックを使用して実行パスを異なるブランチにルーティングする。

diff --git a/ja/use-dify/nodes/variable-aggregator.mdx b/ja/use-dify/nodes/variable-aggregator.mdx

index 7efce6a75..0c7db92c0 100644

--- a/ja/use-dify/nodes/variable-aggregator.mdx

+++ b/ja/use-dify/nodes/variable-aggregator.mdx

@@ -6,6 +6,7 @@ icon: "merge"

⚠️ このドキュメントはAIによって自動翻訳されています。不正確な部分がある場合は、[英語版](/en/use-dify/nodes/variable-aggregator)を参照してください。

+

変数アグリゲーターノードは、異なる実行パスからの変数を単一の統一された出力に結合します。複数のブランチが類似の出力を生成する場合、このノードは一つの一貫した変数参照を作成することで、下流での重複処理の必要性を排除します。

## 分岐の問題

@@ -51,10 +52,9 @@ icon: "merge"

**同一型ルール** - すべての集約された変数は同じデータ型である必要があります。最初の変数(例:文字列)を接続すると、ノードは他のブランチから同じ型の変数のみを受け入れます。

**サポートされる型:**

-- **文字列** - 異なる処理ブランチからのテキスト出力

+- **文字列** - 異なる処理力

- **数値** - 数値計算、スコア、または測定値

- **オブジェクト** - 類似のスキーマを持つ構造化データオブジェクト

-- **ブール値** - True/false値

- **配列** - リスト、コレクション、または複数の結果

### 出力動作

@@ -67,4 +67,24 @@ icon: "merge"

高度なワークフロー(v0.6.10+)では、複数の変数グループを同時に集約できます。各グループは独自の型制約を維持し、同一ノード内で異なるデータ型を並行して集約することができます。

-これは、ブランチが複数の関連する出力を生成し、それらを個別に結合する必要がある場合に便利です - たとえば、異なる処理パスからのテキスト要約と数値スコアの両方を集約する場合です。

\ No newline at end of file

+これは、ブランチが複数の関連する出力を生成し、それらを個別に結合する必要がある場合に便利です - たとえば、異なる処理パスからのテキスト要約と数値スコアの両方を集約する場合です。

+

+## 一般的な使用例

+

+**マルチカテゴリ処理** - 異なるコンテンツタイプには専用の処理が必要ですが、共通の下流ロジックに供給される類似の出力を生成します。

+

+**条件付きデータソース** - 異なる条件が異なる知識検索やAPI呼び出しをトリガーしますが、すべての結果には同じ最終処理が必要です。

+

+**ブランチ結果の統合** - 複雑な分岐ロジックがさまざまな出力を生成しますが、最終的には統一された処理が必要です。

+

+**エラー処理** - メイン処理とフォールバックブランチが異なるが互換性のある結果を生成し、下流ノードが一貫して処理できます。

+

+## ベストプラクティス

+

+**データ型の計画** - 変数アグリゲーターに接続する前に、すべてのブランチが互換性のあるデータ型を生成することを確認します。

+

+**一貫した出力構造** - オブジェクトや配列を集約する際は、予測可能な下流処理のためにすべてのブランチで一貫した構造を維持します。

+

+**説明的な名前を使用** - 集約された変数には、複数の可能なソースからの結果を含むことを明確に示す名前を付けます。

+

+**すべてのブランチをテスト** - 各可能な実行パスが、集約時に正しく動作する有効な出力を生成することを確認します。

diff --git a/ja/use-dify/nodes/variable-assigner.mdx b/ja/use-dify/nodes/variable-assigner.mdx

index c05106c60..8f8e58e4f 100644

--- a/ja/use-dify/nodes/variable-assigner.mdx

+++ b/ja/use-dify/nodes/variable-assigner.mdx

@@ -6,7 +6,8 @@ icon: "pen-to-square"

⚠️ このドキュメントはAIによって自動翻訳されています。不正確な部分がある場合は、[英語版](/en/use-dify/nodes/variable-assigner)を参照してください。

-変数アサイナーノードは、会話変数への書き込み(さまざまなタイプの変数については[こちら](/ja/use-dify/getting-started/key-concepts#変数)を参照)によってチャットフローアプリケーションの永続的なデータを管理します。各実行でリセットされる通常のワークフロー変数とは異なり、会話変数はチャットセッション全体を通じて持続します。

+

+変数アサイナーノードは、会話変数への書き込み(さまざまなタイプの変数については[こちら](jp/use-dify/getting-started/key-concepts#variables)を参照)によってチャットフローアプリケーションの永続的なデータを管理します。各実行でリセットされる通常のワークフロー変数とは異なり、会話変数はチャットセッション全体を通じて持続します。

@@ -39,64 +40,52 @@ icon: "pen-to-square"

異なる変数タイプは、そのデータ構造に基づいて異なる操作をサポートします:

@@ -39,64 +40,52 @@ icon: "pen-to-square"

異なる変数タイプは、そのデータ構造に基づいて異なる操作をサポートします:

-

- - **上書き** - 別の文字列変数で置き換える

+

+ **上書き** - 文字列値全体を新しいコンテンツで置き換える

- - **クリア** - 現在の値を削除する

+ **クリア** - 変数を空にし、nullまたは空白に設定する

- - **設定** - 固定値を手動で割り当てる

+ **設定** - 固定値を手動で入力する

-

- - **上書き** - 別の数値変数で置き換える

+

+ **上書き** - 数値を完全に置き換える

- - **クリア** - 現在の値を削除する

+ **クリア** - nullまたは空の状態に設定する

- - **設定** - 固定値を手動で割り当てる

+ **設定** - 特定の数値を手動で入力する

- - **算術演算** - 現在の値に対して別の数値で加算、減算、乗算、除算を行う

-

-

-

- - **上書き** - 別のブール変数で置き換える

-

- - **クリア** - 現在の値を削除する

-

- - **設定** - 固定値を手動で割り当てる

+ **算術演算** - 現在の値に対して加算、減算、乗算、除算を行う

-

- - **上書き** - 別のオブジェクト変数で置き換える

+

+ **上書き** - オブジェクト全体を新しいデータで置き換える

- - **クリア** - 現在の値を削除する

+ **クリア** - オブジェクトを空にし、すべてのプロパティを削除する

- - **設定** - オブジェクトの構造と値を手動で定義する

+ **設定** - オブジェクトの構造と値を手動で定義する

-

- - **上書き** - 同じタイプの別の配列変数で置き換える

+

+ **上書き** - 配列全体を新しいデータで置き換える

- - **クリア** - 配列からすべての要素を削除する

+ **クリア** - 配列を空にし、すべての要素を削除する

- - **追加** - 配列の最後に1つの要素を追加する

+ **追加** - 配列の最後に1つの項目を追加する

- - **拡張** - 同じタイプの別の配列からすべての要素を追加する

+ **拡張** - 他の配列から複数の項目を追加する

- - **最初/最後を削除** - 配列から最初または最後の要素を削除する

-

-

- 配列操作は、時間の経過とともに成長するメモリシステム、チェックリスト、会話履歴の構築において特に強力です。

-

-

+ **削除** - 最初または最後の位置から項目を削除する

+配列操作は、時間の経過とともに成長するメモリシステム、チェックリスト、会話履歴の構築において特に強力です。

## 一般的な実装パターン

### スマートメモリシステム

-会話から重要な情報を自動的に検出・保存するチャットボットを構築:

+会話から重要な情報を自動的に検出・

@@ -112,7 +101,7 @@ icon: "pen-to-square"

@@ -112,7 +101,7 @@ icon: "pen-to-square"

-**上書き**モードを使用してユーザー入力から初期設定をキャプチャし、パーソナライズされたインタラクションのために後続のすべてのLLMレスポンスでそれらを参照します。

+**上書き**モードを使用してユーザー入力から初期設定をキャプチャし、パーソナライズされたインタラクションのために後続のすべての大規模言語モデルレスポンスでそれらを参照します。

### 段階的チェックリスト

@@ -122,4 +111,16 @@ icon: "pen-to-square"

-**上書き**モードを使用してユーザー入力から初期設定をキャプチャし、パーソナライズされたインタラクションのために後続のすべてのLLMレスポンスでそれらを参照します。

+**上書き**モードを使用してユーザー入力から初期設定をキャプチャし、パーソナライズされたインタラクションのために後続のすべての大規模言語モデルレスポンスでそれらを参照します。

### 段階的チェックリスト

@@ -122,4 +111,16 @@ icon: "pen-to-square"

-配列会話変数を使用して完了した項目を追跡します。変数アサイナーは各ターンでチェックリストを更新し、LLMはそれを参照してユーザーを残りのタスクを通じてガイドします。

+配列会話変数を使用して完了した項目を追跡します。変数アサイナーは各ターンでチェックリストを更新し、大規模言語モデルはそれを参照してユーザーを残りのタスクを通じてガイドします。

+

+## ベストプラクティス

+

+**適切なデータタイプを選択** - 成長するコレクションには配列を、構造化データにはオブジェクトを、単一値には単純型を使用する。

+

+**説明的な変数名を使用** - 会話変数の目的と内容を示すように明確に命名する。